Linux (fr)

-

Un petit tour des systèmes de build

(Journaux LinuxFR)

Sommaire

Parlons un peu de systèmes de build.

Mon métier consiste à programmer des jeux vidéos destinés aux plates-formes mobiles Android et iOS. Ce qui est commun aux deux plates-formes, c’est-à-dire la plus grosse partie de l'application, est écrit en C++, et ce qui est spécifique à la plate-forme est en Java ou en Objective-C. L'intérêt principal de tout faire en C++ est que les développeurs peuvent lancer l'application directement sur leur poste de travail, sous Linux ou OSX, et tester leurs modifs sans payer le prix d'un émulateur ou du transfert sur un appareil mobile.

L'inconvénient est que l'on se retrouve à gérer des builds sur quatre plates-formes.

Pour compiler une application pour iOS il faut nécessairement un projet Xcode, bien que les bibliothèques puissent être compilées classiquement en ligne de commande. Cela signifie qu'il faut maintenir un fichier de projet Xcode ou alors avoir un outil pour le générer.

Côté Android la compilation du code C++ se fait avec l'outil

ndk-build, qui est en réalité une interface à GNU Make. Du coup les fichiers de projet sont évidemment des makefiles mais utilisant des variables et fonctions d'une sorte de framework dans le langage de Make. Là encore il faut maintenir des makefiles pour le projet, ou avoir un outil pour les générer.Pour Linux et OSX la compilation peut se faire avec des outils plus classiques mais évidemment pas avec les fichiers de build iOS ou Android. Et encore une fois il faut maintenir ces fichiers de build.

À moins qu'on ait un outil pour les générer tous…

Quelques systèmes de build

Le problème de la gestion de la compilation d'un projet a été posé bien avant ta naissance ; c'est pour cela qu'il n'existe qu'une seule méthode pour le faire, qui fait consensus depuis des décennies.

Ha ! Ha ! Ha !

Je peux te citer déjà douze outils de tête. Voyons un peu la présentation faite sur leurs sites respectifs et essayons de rester de bonne foi.

Make

D'après le site :

GNU Make est un outil qui contrôle la génération d'exécutables et autres fichiers non-source d'un programme à partir des fichiers source du programme.

J'ai mis la description du site de GNU Make mais la première version de Make date d'avril 1976. Elle précède ainsi le projet GNU de sept ans.

Le principe de base de Make est assez simple, on lui passe un fichier Makefile qui indique « voilà le fichier que je veux créer, il dépend de ces autres fichiers, et voilà les commandes à exécuter pour le créer ». Avec le mécanisme des dépendances l'outil se débrouille pour créer les cibles dans l'ordre.

Il m'arrive encore de créer des petits Makefiles manuellement mais c'est vite pénible. Par exemple, si un binaire

appest créé à partir d'un fichiera.cppqui inclut un fichierb.hppqui inclut lui-même un fichierc.hpp, en toute rigueur je dois lister ces trois fichiers en dépendances de la cibleapppour que la compilation soit refaite quand l'un d'eux est modifié. On fait ça une fois puis on cherche un truc pour que les dépendances soient gérées automatiquement.Un autre point difficile à gérer concerne la dépendance au fichier Makefile lui-même. Par exemple, si j'ajoute une option qui concerne l'édition des liens, celle-ci ne sera pas refaite par défaut.

Autotools

[Le premier objectif des Autotools] est de simplifier le développement de programmes portables. Le système permet au développeur de se concentrer sur l'écriture du programme, simplifiant de nombreux détails de portabilité entre systèmes Unix et même Windows, et permettant au développeur de décrire comment construire le programme via des règles simples plutôt que des Makefiles complexes.

Si vous avez déjà utilisé les autotools vous êtes probablement morts de rire en lisant ce paragraphe. Cette suite d'outils qui se présente comme simple et portable est en réalité ce qu'il y a de plus complexe en système de build et n'est portable que sur les systèmes Unix en évitant soigneusement Windows, le plus déployé des systèmes des trente dernières années.

Sans doute révolutionnaire à sa création, cet outil a extrêmement mal vieillit. Pour ma part j'ai eu l'occasion de compiler des logiciels tiers sous Windows avec ça et c'était tout simplement l'enfer. J'ai aussi tenté de l'utiliser pour mes propres projets et je me suis arrêté dans le tuto. Depuis je suis convaincu que ces outils sont faits pour les développeurs qui aiment transpirer.

SCons

SCons est un outil Open Source de construction de logiciel—plus précisément, une nouvelle génération d'outil de construction. Voyez SCons comme un substitut amélioré et multi-plateforme pour l'utilitaire Make classique avec des fonctionnalités intégrées similaires à autoconf/automake et aux caches de compilation tels que ccache. Pour faire court, SCons est un moyen plus facile, plus fiable et plus rapide de construire un logiciel.

Wow, là c'est carrément le futur.

Les fichiers SCons s'écrivent directement en Python, ce qui est assez sympa puisqu'on se retrouve avec un vrai langage et un a accès à un tas de bibliothèques pour décrire le projet.

J'ai compilé quelques projets en SCons il y a une quinzaine d'années et je crois que je n'ai jamais rien vu d'aussi lent. Et pas seulement parce que c'est du Python…

Il faut dire que le comportement par défaut de l'outil est de détecter les modifications des fichiers sources en calculant un md5 des fichiers, pour éviter de recompiler des fichiers dont seule la date a changé. Quand on voit le prix d'un md5 je trouve ce choix très discutable. Ce comportement peut être modifié via une option mais même en passant sur une comparaison de timestamps et en appliquant toutes les astuces connues pour le rendre plus rapide, ça reste hyper lent.

Premake

Un système de configuration de construction puissamment simple

Décrivez votre logiciel qu'une seule fois, via la syntaxe simple et facile à lire de Premake, et construisez-le partout.

Générez des fichiers de projets pour Visual Studio, GNU Make, Xcode, Code::Blocks, et plus sous Windows, Mac OS X et Linux. Utilisez l'intégralité du moteur de script Lua pour que la configuration de la construction devienne du gâteau.Pfiou, ça claque ! Ce n'est que le quatrième dans la liste et ça promet déjà de tout résoudre

Avec Premake les scripts de builds sont écrits en Lua et, à l'instar de SCons, cela permet de « programmer » son build en profitant de tout un tas de bibliothèques.

Sur le papier c'est très sympa, en pratique ça ne marche pas trop comme attendu. Il s'avère que la syntaxe de Premake est déclarative et ne se mélange pas bien avec le procédural de Lua. Par exemple, si j'écris

project "P" if false then files { "file.cpp" } endOn pourrait croire que le fichier

file.cppne fera pas partie du projetP, et bien pas du tout, leifne change rien du tout ici. Difficile de programmer dans ces conditions.Nous utilisons Premake depuis presque quatre ans au boulot. Le choix s'est fait en sa faveur bien que l'outil était en alpha car il permettait de générer des fichiers pour Xcode et ndk-build via deux plugins indépendants, en plus des Makefiles classiques. Aussi, il avait l'air facile à hacker ce qui était rassurant.

Maintenant j'essaye de le remplacer autant que possible.

Parmi les problèmes récurrents le plus pénible est certainement le message

error: (null), sans autre info, que l'outil affiche parce qu'une erreur s'est glissée dans un script. Bonne chance pour déboguer ça. J'aime aussi beaucoup le messageType 'premake5 --help' for helpqui s'affiche quand je fais une faute de frappe sur la ligne de commande. Là encore il n'y a aucune information utile et il faut se débrouiller pour trouver où on s'est trompé. Autre souci : il n'y a pas moyen de mettre des propriétés de link spécifiques à une bibliothèque. C'est embêtant quand on a besoin d'un-Wl,--whole-archive.Le développement de Premake en lui-même a l'air très laborieux. Quatre ans après il est toujours en alpha, avec une release datant d'août 2017. Le module Xcode a été intégré mais ne gère que OSX. Il a fallu réappliquer toutes nos modifs pour iOS. Quant au module pour le NDK il ne fonctionne plus suite à des changements dans Premake (hey, c'est une alpha…). Là encore il a fallu repatcher.

Il y a de nombreux contributeurs, dont des gros, mais chacun a l'air d'aller dans sa propre direction sans qu'il y ait d'objectif commun. Il y a par exemple deux générateurs de Makefiles,

gmakeetgmake2(j'attends impatiemmentyagmake). Il y a des fonctionnalités qui ne marchent qu'avec Visual Studio, d'autres trucs qui fonctionnaient il y a quatre ans et qui ne fonctionnent plus. Ça m'a l'air d'être typiquement le projet qui veut tout faire parfaitement et qui au final ne fait rien de bien. Bref, le produit n'est pas à la hauteur du pitch.CMake

CMake est une suite d'outils open source et multi-plateforme conçus pour construire, tester et empaqueter des logiciels. CMake est utilisé pour contrôler le processus de compilation du logiciel via des fichiers de configuration indépendants du compilateur et de la plate-forme, et il génère des fichiers Makefiles natifs ou des projets qui peuvent être utilisé avec l'environnement de compilation de votre choix.

CMake est tout simplement mon outil de build préféré de ces quinze dernières années.

Tout est dit.

Bon OK, j'explique. CMake lit des fichiers

CMakeLists.txtqui décrivent les projets à compiler dans un langage qui lui est propre. À partir de cela il génère des fichiers Makefile ou autres (des projets Xcode ou Visual Studio par exemple) qui permettent de construire le projet.Ce qui m'a convaincu dans cet outil est qu'il est plutôt rapide (bien qu'il ne soit pas le plus rapide) et qu'il gère parfaitement les règles de reconstruction des cibles. Par exemple, si j'ajoute un paramètre de ligne de commande pour l'édition des liens, alors l'édition des liens va être refaite. Si je modifie un fichier

CMakeLists.txtet que j'exécutemakesans relancer CMake, alors CMake se relance tout seul (les Makefiles ont une règle de dépendance vers lesCMakeLists.txt, pas con!) Je peux aussi simplement définir les répertoires d'entêtes, options de compilation et autres paramètres spécifiques à chaque projet, en précisant s'il le paramètre doit être visible des projets dépendants ou non.L'outil est assez bien fichu et est très populaire dans le milieu du C++.

Un des points les plus souvent reprochés à CMake est son langage, notamment à l'époque de la version 2 de l'outil qui était excessivement verbeuse et en plus en ALL CAPS. On avait l'impression de se faire crier dessus à longueur de fichier. Aujourd'hui ces soucis sont résolus et le problème semble surtout être que cela fait un langage de plus à apprendre et qui ne sert à rien d'autre (contrairement à SCons et Premake par exemple). Perso je n'y vois pas de difficulté, c'est un bête langage à macros avec des mécanismes bien pratique pour nommer des groupes de paramètres.

Comme d'habitude la qualification « indépendants du compilateur et de la plate-forme » des fichiers de configuration est très discutable dans la mesure où il y a tout ce qu'il faut pour glisser des commandes système dans le build.

Les principaux problèmes que j'ai pu rencontrer avec une version récente de CMake concernent l'export de projet. En effet il y a une commande

install(EXPORTS)qui permet de créer un fichier de configuration CMake pour inclure la cible en tant que dépendance dans un projet tiers. Malheureusement cette commande exporte par défaut les chemins absolus des dépendances de la cible et il faut bricoler pour exporter les dépendances proprement (en les enrobant dans des cibles importées par exemple).Un autre souci est que CMake génère plein de fichiers intermédiaires et qu'avec la pratique généralisée de lancer le build à la racine du projet on se retrouve à polluer toute l'arborescence. Idéalement il faudrait que l'outil refuse de faire un build in-source.

Ninja

Ninja est un petit système de construction se concentrant sur la vitesse. Il est différent des autres systèmes de construction sur deux aspects majeurs : il est conçu pour que ses fichiers d'entrées soient générés par un système de construction de plus haut niveau, et il est aussi conçu pour exécuter les builds le plus rapidement possible.

Ah cool, encore un outil qui se veut rapide, c'est exactement ce qu'il nous manquait. En plus quand on voit SCons et Premake qui se prétendent déjà les plus rapides, on a tout de suite confiance. Cela dit, contrairement à SCons et Premake, Ninja n'est pas un générateur de script de build. Il serait plutôt à comparer à Make.

Je n'ai jamais utilisé Ninja mais si jamais mes builds devenaient très lents je n'hésiterais pas à y jeter un coup d'œil. À moins que je ne passe à Meson.

Meson

Meson est un système open source de construction voulant être à la fois extrêmement rapide et, encore plus important, aussi accessible que possible.

Bon là je désespère. Encore un outil qui veut être le plus rapide et toujours pas d'outil qui prétend fonctionner correctement.

Je n'ai jamais utilisé Meson mais on m'a dit que c'est-nouveau-c'est-bien-tu-devrais-essayer.

Pourquoi pas, enfin moi je cherche surtout un truc qui me génère de quoi faire un build iOS, Android, OSX et Linux. Un truc qui juste marche quoi.

FASTbuild

FASTBuild est un système de construction open source et de haute performance supportant une haute montée en charge de la compilation, la mise en cache et la distribution sur le réseau.

Non mais franchement…

Là encore je n'ai pas utilisé cet outil. La promesse est sympa mais je ne vois pas trop l'intérêt par rapport aux deux mille autres outils du même genre.

Sharpmake

Sharpmake est un générateur de projets et solutions pour Visual Studio. Il est similaire à CMake et Premake, mais il est conçu pour être rapide et passer à l'échelle.

Celui-ci est développé par Ubisoft initialement en interne et libéré en septembre 2017. Apparemment il n'y a plus d'activité dans le dépôt depuis octobre de la même année. Comme son nom l'indique, les scripts de build sont écrits en C#.

D'après la doc il sait aussi générer des projets pour Xcode et des Makefiles. J'ai longtemps considéré l'utiliser en remplaçant de Premake mais d'une part c'est écrit en C#, donc c'est mort pour l'utiliser sous Linux, et d'autre part je sens bien que tout ce qui n'est pas Windows et Visual Studio va être bancal.

Maven

Apache Maven un outil de compréhension et de gestion de projet logiciel. Basé sur le concept de modèle d'objet de projet, Maven peut gérer la construction, le compte-rendu et la documentation d'un projet depuis un élément central d'information.

Je ne sais pas vous mais moi je comprends à peine le descriptif. C'est peut-être ma traduction qui est foireuse.

Maven est un outil du monde Java. J'ai pu l'utiliser un peu via des scripts déjà prêts et il n'y a pas grand-chose à lui reprocher de ce point de vue. Ça m'a l'air assez cool pour la gestion des dépendances.

C'est un outil qui a l'air très professionnel. Ah mais attend… c'est pour ça qu'on comprend rien au descriptif ! La première version date de 2004 et c'est donc tout naturellement que le langage le plus populaire du début du siècle a été choisi pour les scripts de build, je parle bien sûr du 🎉 XML 🎉.

Ant

Apache Ant est une bibliothèque Java et un outil en ligne de commande dons la mission est de piloter des processus décrits dans des fichiers de construction en tant que cibles et points d'extensions dépendant les uns des autres.

Là encore ça sent le professionnalisme. Les fichiers Ant sont des sortes de Makefiles mais écrits en XML. Faut-il le préciser, Ant est lui aussi un outil du monde Java.

Gradle

Accélérez la productivité des développeurs

Depuis les applications mobiles aux micro-services, des petites startups aux grandes entreprises, Gradle aide les équipes à construire, automatiser et livrer de meilleurs logiciels, plus rapidement.Je te laisse deviner à quel langage est destiné cet outil.

Gradle est l'outil de référence pour les builds des applications Android et c'est donc dans ce cadre que j'ai pu l'utiliser. Les scripts Gradle sont écrits en Groovy, un langage que je n'ai jamais utilisé par ailleurs. Perso je trouve pas ça génial mais c'est peut-être simplement parce ce que c'est loin de ce que l'on fait en C++.

Les trucs qui me fatiguent le plus avec Gradle sont d'abord le temps de compilation. La compilation du projet Java de nos jeux, une partie qui contient pourtant peu de code, prend quasiment une minute. L'autre souci est de trouver de la doc claire et facile à digérer. La doc officielle représente à peu près 24% du web[référence nécessaire], ce qui fait que la moindre interrogation demande déjà plusieurs heures de lectures, et les exemples de StackOverflow et divers blogs sont assez disparates.

Que choisir

Déjà douze outils et rien n'a l'air de dominer le marché :/ Sans doute faudrait-il inventer un nouvel outil pour les remplacer tous, quelque chose d'hyper rapide, évolutif, mais aussi adapté aux processes de déploiement intraprocéduraux sur concentrateur décentralisés pour les plus professionnels d'entre nous, avec des scripts dans un langage populaire, type GOTO++.

Malgré tout ce choix je n'ai rien trouvé qui résolve mon problème : générer un projet pour iOS, Android, Linux et OSX avec un seul script. Si vous avez une idée, ça m'intéresse.

Commentaires : voir le flux atom ouvrir dans le navigateur

-

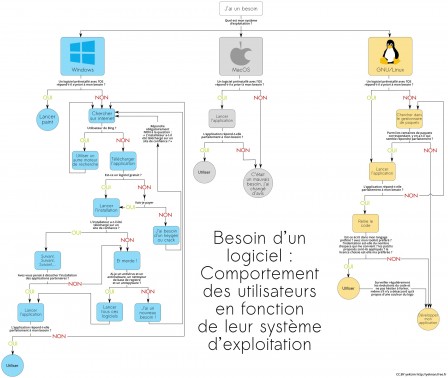

Installation de logiciel : comportement des utilisateurs en fonction du système d’exploitation

(Journaux LinuxFR)

J’ai toujours été amusé par la différence de mentalité entre les utilisateurs de Windows / MacOS / GNU-Linux. L’installation de logiciels est symptomatique de cette différence. J’ai voulu schématiser cette différence en caricaturant très légèrement, j’espère que cela vous semblera pertinent/amusant :

-

Migrer Windows 10 d'un disque BIOS/MBR, vers un SSD en mode UEFI/GPT avec des logiciels libres

(Journaux LinuxFR)

Sommaire

- Introduction

- Prérequis

- Nomenclature

- Procédure de base

- Quelques pistes si ça ne fonctionne pas…

- Documentation, pour aller plus loin…

- Historique de révisions

Introduction

Ce tutoriel vous guide pas à pas pour migrer votre installation de

Windows qui est actuellement sur un disque dur de votre PC vers un

nouveau disque, en l'occurrence un SSD. A vrai dire, vous pouvez aussi

bien migrer vers un autre HDD.La spécificité de ce tutoriel est qu'elle utilise les outils fournis par

Microsoft avec Windows ainsi que des logiciels libres (Clonezilla

principalement, mais si quelque chose devait mal tourner vous pouvez avoir

besoin d'utiliser fdisk, gdisk ou testdisk pour ne citer qu'eux). Quand

j'ai voulu faire cette migration je n'ai pas trouvé de tutoriel

expliquant de bout en bout comment faire cette migration juste avec les

outils de Microsoft et des logiciels libres.Typiquement, vous pouvez avoir envie/besoin de faire cela car vous avez

acheté un nouveau disque pour remplacer l'ancien (par exemple car

l'ancien montre des signes de faiblesse, ou vous voulez améliorer la

réactivité de votre système).En plus de la migration du système d'exploitation, ce tutoriel vous

explique comment passer d'un démarrage en mode BIOS/MBR à un démarrage

en mode UEFI/GPT.Succinctement la démarche est la suivante, d'abord installer le nouveau

disque dans le PC, et initialiser la table de partition selon les normes

Microsoft. Puis cloner/dupliquer la partition contenant le système

d'exploitation à l'aide de Clonezilla. Ensuite et avant de redémarrer

dans le clone de Windows sur le SSD, faire quelques modifications dans

le registre pour que la lettre de lecteurC:pointe vers la bonne

partition et éventuellement modifier le mode SATA en AHCI si vous le

modifiez aussi dans le UEFI/BIOS. Après cela, on va préparer la

partition système EFI/ESP pour que le PC puisse démarrer dessus et qu'il

démarre sur le Windows du SSD. Finalement, une fois dans le Windows du

SSD, on va réactiver l'"environnement de récupération de Windows".Mise en garde : Faites une sauvegarde de vos données avant toute

opération. Personne n'est à l'abri d'une mauvaise manipulation ou d'une

erreur.Prérequis

Compétences

Niveau de difficulté : Difficile.

Vous devez être à l'aise au niveau de l'utilisation de la ligne de

commande dans Windows, mais aussi assez à l'aise pour gérer les

partitions de votre disque. Savoir modifier le paramétrage de votre

Firmware UEFI/BIOS et aussi nécessaire. Ce tutoriel guide pas à pas pour

la majorité des opérations. Certaines n'ont pas été détaillées par souci

de simplicité et d'efficacité.Matériel

Le PC où vous voulez installer le SSD. Il faut qu'il soit en état de

marche. De plus il doit avoir un firmware UEFI. S'il n'a que un BIOS

standard, sans UEFI, ce tutoriel n'est pas adapté.Clé(s) USB ou plusieurs CD/DVD sur lequel vous aurez mis

Clonezilla, System rescue

CD et un environnement de démarrage

Windows PE, ou Windows RE, ou le DVD/Disque d'installation de Windows.Le disque SSD (testé avec Samsung SSD 860 EVO 250GB). Il doit avoir une

taille suffisante pour contenir votre partition de Windows. Dans tous

les cas, la taille de la partition qui contiendra Windows sur le SSD

doit être au moins égale à la taille de la partition Windows du HDD que

vous voulez cloner. Au besoin, pour remplir ce critère, réduisez la

taille de votre partition Windows avec le gestionnaire de disque de

Windows par exemple (ou un autre outil de gestion de partition, comme

gparted, sur le System Rescue CD). Cherchez sur internet si vous ne

savez pas comment faire.Logiciel

Windows 10 installé (en version 64 bits) (testé avec Win10 v1709)

Windows 10 PE ou support d'installation de Windows 10 (clé USB ou DVD) -

En Version 64 bits (testé avec un support d'installation de Win10 v1804)System rescue CD (version 5.2.2 par

exemple)Clonezilla installé sur une clé ou un CD.

Bien vérifier avant que votre système arrive à démarrer dessus. (Testé

avec Clonezilla 2.5.5-38)Nomenclature

SSD : désigne le nouveau SSD

HDD : désigne votre disque actuel, sur lequel est installé Windows

WinPE : un environnement de démarrage Windows PE, ou Windows RE, ou le

DVD/Disque d'installation de Windows. Il doit être sur un support

amovible (USB, CD ou DVD)S: La lettre de lecteur affectée à la partition Système EFI qui sera sur

le nouveau SSD (parfois appelée ESP, EFI_System_Partition ou encore

SYSTEM, ou EFI)N: Le clone de Windows, sur le SSD

O: Le Windows cloné, sur le HDD

C: La partition dans laquelle est installée Windows, lorsqu'on est dans

Windows (que ce soit le windows cloné, ou le clone)Les commandes doivent être lancées en tant qu'administrateur.

Procédure de base

Fixer et brancher le SSD dans l’ordinateur

Désactiver Windows FastStart (cf votre moteur de recherche préféré)

-

Initialiser et partitionner le disque à l'aide de Windows

- Démarrer sur le Windows installé ou WinPE

- Pour initialiser le disque, d'abord créer une table de partition,

puis partitionner le disque. Pour ce faire :

- Suivre les instructions de partitionnement UEFI/GPT selon Microsoft. Ci-dessous mon exemple, mais peut-être avez-vous besoin d'une partition "recovery" aussi, ou votre configuration nécessite quelques aménagements. Dans ce cas, voir les instructions de Microsoft et adapter pour vos besoins.

- Par exemple: une partition EFI de 260Mo, une partition

Microsoft Reserved (MSR) de 16Mo, une partition pour Windows

(taille au moins égale à la taille de la partition de Windows

à cloner). Pour informations, dans diskpart, les tailles que

vous donnez en MB/Mo sont en réalité des MiB/Mio (220 =

10242 octets).

- Ouvrir une invite de commande en mode administrateur et

lancer

diskpart

. Et une fois dans diskpart :

- list disk pour lister les disques et connaître le n° du SSD.

- select disk # avec le numéro du SSD à la place de #

- clean Supprime le contenu du disque / l'initialise

- convert gpt Définit que le disque aura une table de partition GPT

- create partition efi size=260 Crée une partition EFI de 260MiB

- format quick fs=fat32 label="System" Formater la partition EFI au format FAT32

- assign letter="S" Lui donner la lettre S

- create partition msr size=16 Créer une partition Microsoft Reserved de 16MiB

- create partition primary

Créer la partition pour Windows (l'équivalent du

C:) - format quick fs=ntfs label="Windows" Formater la partition pour Windows au format NTFS

- assign letter="N" Lui donner la lettre N

- list volume Liste les volumes. Permet de voir la table de partition.

- exit Quitte diskpart

- Ouvrir une invite de commande en mode administrateur et

lancer

diskpart

. Et une fois dans diskpart :

-

Cloner le Windows installé sur le HDD. Ceci sera fait à l'aide de

Clonezilla- Redémarrer dans Clonezilla

- Une fois dans clonezilla, et si vous êtes confortable avec les

lignes de commande Linux, éventuellement supprimer de la partition

Windows du HDD les fichiers

pagefile.sys,hyberfil.sys(désactiver windows faststart avant),swapfile.sys. - Cloner la partition Windows du HDD vers le SSD (de préférence,

partition de même taille, et de toutes façons, la partition de

destination doit être plus grande que la source. Si ce n'est pas

le cas, réduisez d'abord la taille de votre partition Windows

depuis Windows). Dans clonezilla, utiliser le mode Partition vers

Partition, et en mode Export. Utiliser les options

-e1 auto(automatically adjust file system geometry for a ntfs boot partition if exists)-e2(sfdisk uses CHS of hard drive from EDD (for non grub loader)-r(resize filesystem to fit partition size of target)-m(do NOT clone boot loader)-v(verbose) - Optionnellement cacher la partition contenant le windows source de la table de partition du disque source (si vous ne savez pas à quoi ça sert, passez votre chemin). Pour cela modifier le type de partition de la partition NTFS de windows (en principe, NTFS a un id de « 7 ». On peut utiliser id 17 pour la partition cachée : 17 correspond à « IFS Hidden »). Utiliser cfdisk ou fdisk pour faire ce changement (ce sont des programmes linux).

Dans le Firmware UEFI (ou BIOS-UEFI), on peut en profiter pour passer

du mode SATA "IDE" vers "AHCI". Windows n'aime pas ce changement et

il faut donc faire une opération dans le registre qui est

détaillée ci-dessous. Tant que vous ne le faites pas, vous aurez un

écran de plantage bleu de windows au démarrage (BSOD).Si vous voulez être sûr de ne pas faire de bêtise dans le Windows que

vous venez de cloner, je vous conseille d'éteindre l’ordinateur & de

débrancher l’ancien disque. Ainsi vous ne risquez pas de modifier le

mauvais fichier de registre (en l'occurrence celui de votre Windows

sur le HDD)-

Effectuer quelques opérations sur le Windows de destination (celui

sur le SSD) avant qu'on ne démarre dessus. En particulier corriger le

registre pour affecter la lettre de lecteur C: à la bonne partition,

et si le paramétrage du Firmware UEFI (BIOS-UEFI) a été modifié pour

passer de SATA Mode PCI vers AHCI, on va aussi faire ce changement

pour que ca fonctionne.- Redémarrer dans WinPE (en Mode UEFI, pas MBR !)

- Tout d'abord déterminer la lettre de lecteur affectée au clone

de Windows, celui qui est sur le SSD. Ou, s'il n'y a pas de

lettre affectée, lui en donner une, par exemple

N:(lettre utilisée dans les exemples qui suivent)- Pour cela, lancer dans

diskpart

- list volume

Ce qui retourne la liste des volumes avec la lettre de lecteur qui a été affectée à chacun.

- list volume

- Si aucune lettre de lecteur n'est affectée, il faut alors

lui en affecter une. Pour cela, lancer dans

diskpart

- select volume # (avec # étant le numéro du volume qui contient le nouveau windows)

- assign letter=N

S'il n'est pas possible d'utiliser select volume alors faire comme ceci - list disk

- select disk # (# étant le numéro affecté au SSD)

- list partition

- select partition # (# étant le numéro affecté à la partition de Windows sur le SSD, probablement 3)

- assign letter=N

- Pour cela, lancer dans

diskpart

- Faire un CHKDSK /F sur la lettre du nouveau Win

- Pour que la partition

C:utilisée par Windows soit celle du SSD et pas celle de l’ancien disque, modifier une clé de registre du nouveau Windows :- Lancer

REGEDIT

et dans le registre HKEY_LOCAL_MACHINE monter la ruche

N:\Windows\System32\Config\SYSTEM. Lui donner le nom "NewWin" On s’intéresse àHKEY_LOCAL_MACHINE\NewWin\MountedDevices. Ce sont là les valeurs qui sont dans le registre "HKEY_LOCAL_MACHINE\SYSTEM\MountedDevices" lorsqu'on est dans l'installation de Windows.- Dans

HKEY_LOCAL_MACHINE\NewWin\MountedDevicesmodifier la lettre de lecteur C: en renommant \DosDevices\C: par \DosDevices\O: (car la valeur fait référence à la partition de l'ancien Windows sur le HDD et on ne veut pas, en démarrant, utiliser cette partition mais celle de son clone qui est sur le SSD). Ainsi, lorsqu'on démarrera dans le nouveau Windows, la partition contenant le Windows sur le HDD aura la lettre O:, et la partition contenant le Windows sur le SSD aura la lettre C: - Créer une nouvelle valeur binaire nommée \DosDevices\C:

et lui donner comme contenu celui de \DosDevices\N: qui

est renseignée dans le registre WinPE, c'est-à-dire là

HKEY_LOCAL_MACHINE\SYSTEM\MountedDevices(C:étant la lettre qu'utilisait le Windows du HDD comme partition où il y a le dossier \Windows ) - ATTENTION: Bien vérifier que la copie a fonctionné et qu'il y a les bonnes valeurs, car dans mes essais, j'ai du m'y reprendre à 2 fois car le 1er "coller" ne collait pas ce que je voulais.

- En principe c'est tout. Mais d'après certaines sources,

il y aurait une clé \\?\Volume{GUID} ayant le même

contenu que le \DosDevices\O: qu’on vient de modifier.

Chez moi ce n'était pas le cas. Si vous avez une telle

valeur, alors il faut lui donner le contenu de

\DosDevices\N: depuis le registre WinPE

- Dans

- Lancer

REGEDIT

et dans le registre HKEY_LOCAL_MACHINE monter la ruche

- Si en même temps que la migration on veut aussi passer du mode

SATA IDE vers AHCI alors il faut encore faire ceci. Cela a été

repris du site

tomshardware.co.uk

- Toujours dans

REGEDIT

avec la ruche montée en

HKEY_LOCAL_MACHINE\NewWin - Aller à

HKEY_LOCAL_MACHINE\NewWin\ControlSet000\Services\storahci\StartOverride - Changer la valeur DWORD de 3 à 0.

- Au redémarrage, si ça n'a pas été fait, changer la paramétrage du contrôleur SATA de IDE à AHCI. Au redémarrage, Windows devrait directement démarrer correctement et sans plantage (BSOD).

- Toujours dans

REGEDIT

avec la ruche montée en

- Rendre le disque bootable en installant les outils EFI de

microsoft et configurant le Magasin BCD (BCD Store)

- D'abord assigner une lettre de lecteur à la partition ESP

- MOUNTVOL S: /S

Si ca n'a pas fonctionné, faire comme ceci dans diskpart - list disk

- select disk # (# est le numero du SSD retourné par list disk)

- list partition

- select partition # (# est probablement 1)

- assign letter=S

- MOUNTVOL S: /S

- Puis lancer

bcdboot

N:\windows /l fr-fr /s S: /f UEFI- Où

N:\Windowsest le répertoire contenant le clone de Windows sur le SSD) - S: = partition EFI

- Où

- D'abord assigner une lettre de lecteur à la partition ESP

- Tout d'abord déterminer la lettre de lecteur affectée au clone

de Windows, celui qui est sur le SSD. Ou, s'il n'y a pas de

lettre affectée, lui en donner une, par exemple

- Redémarrer dans WinPE (en Mode UEFI, pas MBR !)

Redémarrer, et avant le lancement de Windows vérifier votre UEFI

(ou BIOS-UEFI). Il faut qu'il soit configuré pour démarrer par défaut

en mode UEFI et pas en mode BIOS. Penser aussi à corriger le

paramétrage SATA si cela a été modifié dans le registre de Windows.

Le paramétrage du démarrage avecbcdboot N:\windows /l fr-fr /s S: /f UEFIa normalement créé le

magasin BCD, mis tous les fichiers EFI sur la partition SYSTEME (ESP,

partiton EFI, la 1ère du SSD) et dit au firmware UEFI qu'il doit

automatiquement démarrer avec le gestionnaire de démarrage

(boot manager) de Windows.-

Une fois qu’on a réussi à démarrer dans la copie de Windows

- Réactiver le "FastBoot"

- Réactiver l'environnement de récupération de Windows

en lançant, depuis une ligne de commande avec les droits

administrateur, la commande

reagentc.exe /enable. Vérifier avecreagentc.exe /info. Et s'il y a une erreur essayer avecreagentc.exe /enable /setreimage /path C:\Recovery\WindowsREoùC:\Recovery\WindowsREest le dossier où se trouve le fichierWinre.wim - Vérifier que tout est en ordre. Eventuellement donner un nouveau

nom à votre partition

C:(pour la différencier de celle sur le HDD) en lançant:LABEL [drive:][label] - Redémarrer encore une fois en laissant le processus de démarrage se faire tout seul pour vérifier que tout est ok.

Réinsérer l'ancien disque dur.

Normalement, il devrait être possible de redémarrer dans l'ancien

Windows, du moment que vous savez comment booter en MBR, et sous

réserve de ne pas avoir modifié le mode SATA dans le UEFI/BIOS. SI

c'est le cas, vous pouvez envisager de modifier le registre du

Windows du HDD, ou de modifier le paramétrage du UEFI/BIOS.

Si vous avez aussi Linux d'installé sur le HDD, il devrait toujours

être possible de le démarrer en mode BIOSOn peut diminuer/augmenter la taille de la partition C: du SSD (Pour

un SSD TLC ou VNAND, on peut par exemple laisser de l’espace libre à

la fin ~10 % de la capacité du disque d'après le logiciel Samsung

Magician, pour un SSD 860 EVO)En principe, puisqu’on boot en EFI on peut enlever sur le clone

Windows sur le SSD les fichiers\bootmgret\Boot\BCDpuisque ce

sont ceux qui étaient utilisés pour un boot en mode BIOS/MBR et que

désormais on est en EFI. Vous pouvez d'abord les renommer et vérifier

que ca ne change rien au prochain boot, plutôt que de les supprimer

tout de suite.

Quelques pistes si ça ne fonctionne pas…

- Faire un chkdsk sur la nouvelle partition

- Recréer le bootsector du NTFS avec testdisk (dispo sur System Rescue CD, mais peut être aussi dans Clonezilla ? Je n'ai pas vérifié)

- Vérifier le BCD:

- On peut vérifier si le Magasin BCD est ok en lançant (en

tant qu'administrateur)

bcdedit /store s:\EFI\Boot\Microsoft\BCD /enum

(Si la partition système n'est pas montée sur S:, lancer

Mountvol s: /s

- Doc BCDEDIT (sur la page, il y a aussi les liens vers bcdboot (initialise BCD et copie fichiers de démarrage sur la partition systeme) et bootsect (pour basculer entre NTLDR et Bootmgr)

- https://msdn.microsoft.com/fr-fr/library/windows/hardware/mt450468(v=vs.85).aspx

- https://docs.microsoft.com/en-us/windows-hardware/manufacture/desktop/bcd-system-store-settings-for-uefi

- On peut vérifier si le Magasin BCD est ok en lançant (en

tant qu'administrateur)

bcdedit /store s:\EFI\Boot\Microsoft\BCD /enum

(Si la partition système n'est pas montée sur S:, lancer

Mountvol s: /s

- Vérifier que la partition EFI est bien initialisée (présence des

fichiers

\EFI,\EFI\Boot\,\EFI\Microsoft\…) Si ce n'est pas le cas, il y a eu un problème avec bcdbootN:\windows /l fr-fr /s S: /f UEFI - Vérifier le boot manager du bios (démarrage en UEFI ou MBR ? Gestionnaire de démarrage par défaut ? Présence du gestionnaire de démarrage de Windows ?)

- A priori, pas utile : Commandes à lancer dans WinPE

- Pour recréer le boot sector de la partition systeme (EFI):

bootrec

/fixboot - Pour chercher les OS sur le disque et les mettre dans le

bootloader

bootrec

/scanos

- Pour recréer le boot sector de la partition systeme (EFI):

bootrec

- Quelques commandes de bcdedit pour modiser la valeur de certains

éléments du magasin BCD. Inutile car le BCD Store qui est utilisé

lorsqu'on démarre en mode EFI n'est pas le même que celui utilisé

dans un démarrage en mode MBR. Donc, pas besoin de chercher à

modifier le BCD. Je garde pour info : les lettres sont celles telles

que définies dans le système où on est (WinPE par ex).

Doc BCDEDIT

- bcdedit /set {bootmgr} device \Device\HarddiskVolume1

- bcdedit /set {default} device \Device\HarddiskVolume3

- bcdedit /set {default} osdevice \Device\HarddiskVolume3

- Ou à la place de \Device\HarddiskVolume1 mettre les lettres de lecteur :

- bcdedit /set {bootmgr} device partition=S:

- bcdedit /set {default} device partition=C:

- bcdedit /set {default} osdevice partition=C:

Documentation, pour aller plus loin…

A propos du EFI/UEFI:

- La procédure de Boot en cas UEFI ou BIOS est bien décrite ici: https://www.boyans.net/RepairWindows/RepairWindowsBCD.html

- La partition Système EFI: https://wiki.archlinux.org/index.php/EFI\_System\_Partition

- Managing EFI Boot Loaders for Linux: http://www.rodsbooks.com/efi-bootloaders/principles.html

A propos de l'entrée MountedDevices du registre:

http://diddy.boot-land.net/firadisk/files/mounteddevices.htmSi on veut y accéder, par défaut les fichiers du BCD sont cachés. Pour

les rendre visibles:- attrib bcd -s -h -r

- mv bcd bcd.bak

- bootrec /rebuildbcd

Documentation bcdedit:

- http://diddy.boot-land.net/bcdedit/

- Concernant les valeurs possibles pour « device » ou « osdevice » dans bcdedit http://www.diddy.boot-land.net/bcdedit/files/device.htm

MBR Partition ID

- NB: Une partition Recovery Windows a un part_id de « 0x27 »: https://www.win.tue.nl/~aeb/partitions/partition\_types-1.html

A propos des disk ID (=Disk signatures):

- http://kb.macrium.com/KnowledgebaseArticle50152.aspx . En principe pas de pb, puisqu’on n’a pas cloné tout le disque mais juste une partition, et que le pb de signature du disque est lié à la copie du MBR (1er secteur du disque {et pas de la partition}). Cela concerne probabement aussi le clonage de la table de partition GPT puisqu'il y a aussi un id dedans…

- Fixing Disk Signature Collisions: https://blogs.technet.microsoft.com/markrussinovich/2011/11/06/fixing-disk-signature-collisions/

Si besoin de supprimer du registre les entrées de disques qui ne sont

pas connectés ou sans lettre assignée lancer:mountvol /R. Ce

programme permet aussi de lister les lettres de volumes avec leur GUID

(GUID pour ce système uniquement, il n’est pas stocké dans la partition,

ni ailleurs sur le disque, il est assigné par windows pour un couple

(signature de disque/partition offset) dans une instance de windows

alors que dans une autre instance de windows la même partition sur le

même disque aura ce GUID différent)Changer le label du volume: commande

LABEL [drive:][label]Historique de révisions

Vous trouverez la dernière version de ce tutoriel sur ma page perso

de tutoriels informatique.

Vous y trouverez aussi la version HTML, PDF et TXT.2018-06-17 : Ajout d'une note indiquant que ce tutoriel utilise des

logiciels libres2018-06-11 : Correction de la forme et de fautes d'orthographe

2018-05-28

Commentaires : voir le flux atom ouvrir dans le navigateur

-

Retour sur la licence de NumWorks

(Journaux LinuxFR)

À la suite du journal précédent, je me demandais, quelle était la protection effective de la licence CC-BY-NC-SA. J'aimerais bien que l'on ne reprenne pas la guerre libre pas libre de l'autre dépêche, j'ai plutôt envie de voir ce qu'ils apportent, plutôt que de réfléchir à ce dont ils nous privent.

Pour rappel, la licence CC-BY-NC-SA permet de :

- Partager — copier, distribuer et communiquer le matériel par tous moyens et sous tous formats

- Adapter — remixer, transformer et créer à partir du matériel

L'Offrant ne peut retirer les autorisations concédées par la licence tant que vous appliquez les termes de cette licence.

Attribution — Vous devez créditer l'Œuvre, intégrer un lien vers la licence et indiquer si des modifications ont été effectuées à l'Oeuvre. Vous devez indiquer ces informations par tous les moyens raisonnables, sans toutefois suggérer que l'Offrant vous soutient ou soutient la façon dont vous avez utilisé son Oeuvre.

Pas d’Utilisation Commerciale — Vous n'êtes pas autorisé à faire un usage commercial de cette Oeuvre, tout ou partie du matériel la composant.

Partage dans les Mêmes Conditions — Dans le cas où vous effectuez un remix, que vous transformez, ou créez à partir du matériel composant l'Oeuvre originale, vous devez diffuser l'Oeuvre modifiée dans les même conditions, c'est à dire avec la même licence avec laquelle l'Oeuvre originale a été diffusée.

Pas de restrictions complémentaires — Vous n'êtes pas autorisé à appliquer des conditions légales ou des mesures techniques qui restreindraient légalement autrui à utiliser l'Oeuvre dans les conditions décrites par la licence.

Les sources de ce système d'exploitation seront toujours disponibles, si l'entreprise décide de changer de licence, elle ne pourra pas revenir sur ce qui existe déjà.

Cela fait donc a minima un excellent objet d'étude d'une solution employant beaucoup de logiciels libres dans sa construction.

Leur parti pris est très intéressant. Ils ont décidé de na pas utiliser d'OS mais de directement coder sur le Cortex-M4, cela permet à leur système de tenir sur 256kB de ram.

Ils ont du recréer tout un environnement, j'imagine que l'investissement en terme de R&D est très important.

Je pense que c'est cet aspect qui rend l'OpenSource (ou libre) difficile. En effet, admettons qu'ils aient mis leur OS et toute la couche applicative en GPL, ils auraient très facilement pu avoir une boite qui récupère tout le code sans apporter aucune amélioration mais en profitant des faibles prélèvements sociaux d'autres pays (Chine par exemple), pour vendre moins cher. De plus il aurait aussi été possible qu'une entreprise ayant plus de capital fasse baisser les coûts par un effet d'échelle, et reprenne le développement en tant qu'acteur majeur. Cela aurait été super pour la diffusion du produit mais aurait mis un coup d'arrêt à leur entreprise.

Le problème est que l'ingénierie logicielle a certes un coût mais les investissements sont majoritairement du salaire alors que le développement d'un matériel entraîne des investissements en prototypes et une industrialisation sur une chaîne de production, qui peut rendre la libre utilisation, des développements précédemment fait, périlleux pour l'entreprise.

Donc oui, à titre personnel, je me questionne sur le fait qu'il existe systématiquement un modèle économique viable libre associable à n'importe quel projet. N'ayant pas la réponse, je serais ravi que l'on m'éclaire sur ce sujet qui dépasse vraiment mon niveau de compétence.

Maintenant, cela montre qu'il est possible d'utiliser des briques libres pour faire une calculatrice, c'est vraiment intéressant.

Quelqu'un a-t-il une idée sur la différence de consommation entre une carte cortex-M4 et une carte raspberry pi zeros ?

Si je trouve leur idée intéressante, je trouve que d'avoir un terminal mobile basé sur une distribution linux minimale avec un environnement de type SageMath avec une version des notebooks Jupyter adaptés aux petits écrans pourrait vraiment être cool ! Quand on voit à quel point des outils tels que JupyterLab permettent de rendre l'accès à des environnements python avec toutes les libs installées, utiliser une raspbian minimale avec un une appli Qt pour le web et un serveur jupyter, permettrait de faire vraiment pas mal de choses ! Sachant qu'en plus Jupyter peut faire plein d'autres choses telles que du SageMath, Octave, maxima, Julia, …

Le problème serait alors l'autonomie … mais bon avec l'arrivée en 2019 de l'advanced color paper display, on pourrait bien avoir accès à une technologie permettant de faire des petits écrans couleurs qui ne consomment pas du tout. Un trois couleurs serait déjà faisable par exemple.

Donc je trouve que leur idée est vraiment top, mais personnellement je préférerais pouvoir conserver mon environnement Linux même sur une calculette. Bon, en même temps, je ne pense vraiment pas être la cible … Cependant je trouve l'analyse d'Aurélien Pierre assez intéressante. Il serait juste sympa d'avoir tout l'environnement dans une machine qui ressemblerait à une TI92 ou une voyage 200, même si ce format n'est plus vraiment d'usage … Avoir un clavier Alpha-numérique physique est tout de même un gros plus. Sachant qu'une calculatrice moderne de chez TI avec des capacités CAS coûte encore 130€, il reste de quoi s'amuser avec les raspberry pi et consort …

Commentaires : voir le flux atom ouvrir dans le navigateur

-

Neatmail: un client mail minimaliste

(Journaux LinuxFR)

Sommaire

- Ali Gholami Rudi

- Ce que Neatmail ne fait pas

- Ce que Neatmail fait

- Le commande ex de neatmail

- Un script shell comme interface

- Conclusion

J’utilise depuis quelque temps un tout petit client mail, qui ne fait vraiment que le minimum, mais a une interface si particulière, qu’il me semble intéressant de vous le présenter. Il s’agit de Neatmail écrit par Ali Gholami Rudi.

Ali Gholami Rudi

Je connais Ali Gholami Rudi pour une implémentation de Troff à la fois pertinente en termes de fonctionnalités et dont le code source est très propre. Il a aussi écrit un compilateur (neatcc), une libc (neatlibc), et une implémentation de vi. C’est un développeur qui, plutôt qu’une éthique, semble défendre une certaine esthétique du logiciel, que je qualifierai de minimaliste: code source compréhensible par une personne seule, logiciel qui fait peu de choses, mais le fait bien, etc.

Neatmail le client mail qu'il s'est programmé, et celui‐ci met en scène toute l’esthétique de son auteur.

Ce que Neatmail ne fait pas

Neatmail ne fait que gérer un fichier mbox (une concaténation de mails). Ainsi, il ne sait ni rapatrier, ni envoyer les mails, il ne sait ni extraire, ni ajouter de pièce jointes, etc.

Mais en vérité, il n’a pas besoin de faire tout cela, car d’autres logiciels le font. Ali Gholami Rudi propose ainsi un pop3 pour rapatrier les mails depuis un serveur pop3, et smtp pour envoyer ses mails à un serveur smtp. Et il existe dans certaines distributions un ripmime pour extraire les pièces jointes d’un fichier mime.

Ce que Neatmail fait

Neatmail se contente donc d’effectuer des actions sur un fichier mbox. Les actions de bases sont:

‐ mk Génère une liste des mails contenus dans la mbox.

‐ ns Génère une liste des nouveaux mails présents dans la mbox.

‐ pg Affiche un des mails contenu dans la mbox.On peut donc l’utiliser ainsi:

# Obtient les mails pop3 # liste les mails, triés par fil de discussion neatmail mk ‐r ‐st ‐0 18from:48~subject: mbox # affiche le 3e mail neatmail pg mbox 3 # prépare une réponse neatmail pg ‐r mbox 3 > draft.eml vi draft.eml # envoie la réponse tail ‐n+2 draft.eml | smtp # garde une copie de la réponse cat draft.eml >> sent rm draft.emlMais en outre, neatmail peut interpréter les commandes ex contenues dans la liste des mails. Autrement dit, l’utilisateur est invité à ajouter des commandes à cette liste de mails, et donner le tout à neatmail qui se chargera de l’exécution:

neatmail mk ‐r ‐0 18from:48~subject > list.nm vi list.nm neatmail ex < list.nmLe commande ex de neatmail

La commande ex de neatmail prend en entrée une liste de commandes, et les exécute sur un fichier mbox. Elle ignore toutes les lignes hormis celles commençant par deux points (commande ex) ou une lettre majuscule (un mail dans la liste). Les lignes commençant par une lettre majuscule de la forme "R100..", modifient le statut du message dont le nombre suit la lettre (ici, 100). Une telle ligne définit aussi le message actuel, celui sur lequel les commandes sont exécutées. Les commandes ex sont les suivantes:

‐ rm supprime le message courant.

‐ cp copie le message courant dans une mbox donnée.

‐ mv déplace le message courant dans une mbox donnée.

‐ hd modifie l’entête donnée du message courant.

‐ ft passe le message courant à une commande donnée.

‐ w écrit les modifications dans la mbox.

‐ tj joint les fils de discussion en modifiant l’entête "Reply‐To".

‐ ch coupe le message à l’offset indiqué.Par défaut, ces commandes agissent sur le message courant, mais il est aussi possible d’utiliser des adresses du type

2,5rmpour effacer les messages 2 à 5. Il est aussi possible d’utiliser des expressions régulières du type/regex/rm, oùregexest recherché dans le sujet des messages. D’autres champs peuvent être spécifiés en utilisant l’expression^field:value.Un script shell comme interface

Vous allez certainement penser que l’interface est un peu rude… À vrai dire, Ali Gholami Rudi n’utilise pas neatmail directement: un script shell (m) lui sert d’interface. Et c’est là que le logiciel brille: pour peu que l’on ait un peu l’habitude du shell, on peut se créer une interface sur mesure. On peut par exemple imiter l’interface de mh (un autre client mail non interactif un peu oublié). On pourrait créer une interface interactive. Bref, on peut faire ce qu’on veut.

J’utilise par exemple l’interface suivante:

m box inbox # liste les messages contenus dans la mbox inbox. m vi 3 # affiche le message 3 m next # affiche le message 4 m repl # ouvre mon éditeur sur une réponse préformatée au message 4 m add f.pdf # joint f.pdf à ma réponse m send # envoie ma réponse. m R # marque le message 4 comme lu. m com # enregistre les changements dans la mbox (ici, change l’entête du message 4)Conclusion

Au jour le jour, je suis plutôt satisfait de l’ensemble. Le fait de travailler sur les mails en local est plutôt agréable: c’est fluide, offre une grande liberté d’organisation, s’associe bien à un système de sauvegarde ou de gestion de version, etc. Le fait que le client ne soit pas interactif apporte un certain confort d’usage: le shell est sous la main si besoin, je retrouve ma session de travail dans l’état où je l’ai laissée d’un jour à l’autre, il est facile d’implémenter des solutions pour revenir en arrière (cp…). Le fait de coupler le tout avec le shell offre une grande liberté dans la création de l’interface utilisateur.

Commentaires : voir le flux atom ouvrir dans le navigateur

-

AlterncCamp c'est dès jeudi 21 juin

(Journaux LinuxFR)

Salut

Ayant déjà fait la dépéche et que le temps est passé, j'en profite pour rappeler que jeudi, vendredi et samedi il est possible d'aider à l'avancée du projet alternc

- https://linuxfr.org/news/alternc-camp-a-paris-du-21-au-23-juin-2018

- https://github.com/alternc/alternc

Commentaires : voir le flux atom ouvrir dans le navigateur

-

Grammalecte, correcteur grammatical [2]

(Dépêches LinuxFR)

Grammalecte est un correcteur grammatical écrit en Python et en JavaScript, dédié à la langue française, disponible pour LibreOffice, Firefox, Thunderbird, ainsi que comme programme autonome, via une interface en ligne de commande ou un serveur. Par ailleurs, d’aimables contributeurs ont apporté leur pierre à l’édifice en concevant des greffons pour Vim et Emacs.

Grammalecte lance une deuxième campagne de financement pour améliorer la correction grammaticale et faire évoluer les intégrations aux navigateurs Web.

Cet article est très long. Plutôt que répéter ce qui a déjà été dit, je vais présumer que vous avez un souvenir à peu près clair du billet précédent sur ce sujet. Cela dit, même sans ça, ce que je vais dire devrait être intelligible.

- lien n°1 : Site officiel

- lien n°2 : Campagne de financement participatif

Sommaire

-

Ce qui a été fait

- Séparation du correcteur d’avec Hunspell et LibreOffice

- Extension pour Firefox & Thunderbird

- Captures d’écran

- Révision du moteur interne du correcteur

- Tests unitaires

-

JavaScript, mon

amourHiroshima - De Writer à Firefox (ou de la littérature au Web) : le choc culturel

- Lexique du correcteur

- C’est toujours perfectible

- L’avenir

- Le mot de la fin

Ce qui a été fait

Séparation du correcteur d’avec Hunspell et LibreOffice

C’était le prérequis à l’indépendance du logiciel, et c’est la première chose qui a été faite. Au lieu de consulter Hunspell, le correcteur orthographique, pour connaître l’étiquetage grammatical des mots, Grammalecte interroge dorénavant son propre dictionnaire indexable. Il s’agit d’un graphe de mots contenant toutes les formes graphiques que peuvent avoir les mots français : les pluriels, les formes féminines et masculines, et les conjugaisons.

Le graphe contient 500 966 entrées, avec 140 caractères différents, 901 codes de suffixation, 6 066 étiquettes grammaticales, et est composé de 110 796 nœuds et 236 744 arcs (liens qui vont d’un nœud à un autre). Tout ça est compressé sous forme d’un dictionnaire binaire indexable pesant environ 1,25 Mio (le fichier texte non compressé pèse environ 18,6 Mio). Mais le principal avantage de ce dernier n’est pas sa petite taille, c’est qu’on peut le parcourir très rapidement et l’interroger sans avoir à le décompresser. Il peut fournir deux sortes d’informations : un mot est‐il présent dans le dictionnaire et, si oui, quelle est sa nature grammaticale.

Grâce à cela, Grammalecte peut fonctionner de manière autonome.

Extension pour Firefox & Thunderbird

Le correcteur a été entièrement réécrit en JavaScript avec une interface pour Firefox, qui s’appuie principalement sur l’API SDK de haut niveau et quelques fonctionnalités de bas niveau. L’interface est faite en HTML/CSS.

L’API de Thunderbird étant complètement différente de celle de Firefox, cette extension est une autre réécriture en JavaScript de l’extension, hormis le cœur du moteur grammatical, bien sûr. L’interface est bâtie avec l’ancienne technologie XUL encore en vigueur sur Thunderbird. La documentation concernant Thunderbird étant en partie tombée en déshérence (liens cassés, pages manquantes, sections disparues, sites Web à l’abandon ou évaporés), j’ai parfois fait emploi de techniques trouvées dans d’autres extensions, mais ça ne concerne qu’une minorité de problèmes, et je me suis contenté autant que possible de suivre ce qui était documenté. Le fonctionnement de l’extension est assez similaire à celle pour Firefox. Votre texte est analysé dans un panneau annexe. En revanche, contrairement à Firefox, les erreurs sont listées en dessous du paragraphe analysé. Hormis cela, tout est relativement semblable, sauf l’allure générale de l’extension, qui fait plus vieux jeu, parce que XUL est d’une conception plus ancienne.

La mauvaise nouvelle, pour Firefox, c’est qu’il faudrait déjà refaire l’interface. Quand j’ai commencé le codage de l’extension, Mozilla préparait une nouvelle API pour les extensions, appelée WebExtension, qui était alors en version alpha. C’est la quatrième API pour Firefox, les trois autres étant XUL, Bootstrapped et le SDK (haut niveau et bas niveau). Il était dit que ces trois API deviendraient obsolètes d’ici quelques années, sauf le SDK de haut niveau, et qu’il fallait utiliser ça en attendant que l’API WebExtension fût finalisée. C’est donc ce que j’ai fait. Grammalecte pour Firefox est sorti à peu près au même moment que WebExtension. Quelques mois plus tard, les trois autres API ont été déclarées obsolètes, y compris le SDK de haut niveau, contrairement à ce qui avait été annoncé, et toutes les trois seront supprimées en novembre prochain avec Firefox 57.

C’est vraiment très irritant, mais l’on n’y peut pas grand‐chose. Ceci découle probablement de la volonté de Mozilla de réécrire tout le cœur de Firefox. Ce qui n’apporte pas que de mauvaises choses, puisque, par exemple, j’ai constaté que le correcteur grammatical fonctionnait plus de deux fois plus vite à partir de Firefox 55…

Le cœur de l’extension, le moteur grammatical, n’est pas à reprogrammer, il ne s’agit « que » de l’enrobage, l’interfaçage… J’ignore si ça réclamera beaucoup de travail, je ne m’y suis pas encore intéressé. L’un des autres soucis, c’est que même si WebExtension est dorénavant le modèle d’extensions conseillé, il semble qu’il ne permette pas encore autant de choses que les API précédentes. Cette API est toujours en développement, Mozilla travaillant encore à étendre les possibilités offertes.

En ce qui concerne Thunderbird, je n’ai rien vu passer… et j’ignore si nous sommes à la veille d’une révolution surprise qui va tout casser.

Mozilla n’a pas encore vérifié le code de l’extension pour Thunderbird : la liste d’attente est très longue. Heureusement, contrairement à Firefox il est possible d’installer une extension non vérifiée et non signée. Il n’y a aucun risque de confidentialité. Le correcteur n’envoie aucune donnée en ligne, absolument rien. Ce que vous écrivez n’est pas transmis, tout se passe sur votre ordinateur.

Pour ceux que ça intéresse de tester, je viens de publier la version 0.5.17 :

- pour Firefox (il faut un Firefox capable d’installer les extensions non signées) ;

- pour Thunderbird (Thunderbird peut installer les extensions non signées).

Captures d’écran

Boîtes de dialogue « À propos » :

Correcteur grammatical :

Conjugueur :

Formateur de texte :

Options grammaticales et orthographiques :

Interface en ligne de commande :

Révision du moteur interne du correcteur

Désambiguïsation

Dans la précédente dépêche, je vous avais expliqué que Grammalecte ne possédait pas de processus de désambiguïsation permettant d’étiqueter les mots en fonction du contexte. Par exemple, un mot comme « porte » peut être un verbe ou un nom féminin, et il est utile, lors de l’analyse d’une phrase, d’avoir procédé si possible à la désambiguïsation de sa nature grammaticale, afin que les règles de contrôle n’aient pas à se poser la question à chaque fois.

Comme expliqué lors de la campagne de financement précédente, Grammalecte intègre désormais des fonctions de désambiguïsation capables d’étiqueter et baliser le texte. Ce désambiguïsateur fonctionne d’une manière similaire aux règles de contrôle et au processeur de texte. Une expression rationnelle déclenche une action de désambiguïsation si elle remplit la condition requise, de sorte que toutes les règles suivantes bénéficient d’un étiquetage plus précis. Il y a trois types d’actions de désambiguïsation : la sélection (qui ne retient que les étiquettes conformes à une expression rationnelle), le filtre (qui supprime les étiquettes grammaticales non conformes), l’étiquetage (qui impose une ou plusieurs étiquettes, quelles que soient celles que le mot possède alors).

Règles multi‐actions

Dans le précédent billet, je vous avais expliqué que Grammalecte fonctionnait selon une succession de passes, dont chacune était précédée d’une transformation du texte par ce que j’appelais le « préprocesseur de texte ». Ce qui permettait de simplifier peu à peu le texte pour faciliter le contrôle des règles grammaticales qui suivaient.

Pour simplifier, cela fonctionnait ainsi :

- Passe 1 (paragraphe par paragraphe) :

- règles du préprocesseur de texte ;

- règles de contrôle.

- Passe 2 (phrase par phrase) :

- règles du préprocesseur de texte ;

- règles de contrôle.

- Passe 3 (phrase par phrase) :

- règles du préprocesseur de texte ;

- règles de contrôle.

- etc.

Dans ce système, chaque règle ne pouvait faire qu’une seule chose (comme dans LanguageTool), et seulement si la condition qui contrôlait sa mise en œuvre était remplie.

Peu de temps après le début de la campagne de financement, il m’est apparu qu’il serait souhaitable de rendre plus souple ce fonctionnement. Il n’était pas prévu au programme de toucher à cela, mais j’ai préféré m’atteler tout de suite à cette tâche plutôt que de regretter plus tard de ne pas l’avoir fait. Donc, à présent, au lieu d’une succession de passes alternant transformation du texte et contrôle de la grammaire, nous sommes revenus à simplement deux passes (une pour le contrôle du paragraphe, une pour le contrôle des phrases), mais chaque règle peut dorénavant tout faire et peut accomplir autant d’actions qu’on le souhaite, chaque action se déclenchant si la condition qui y est attachée est remplie.

Donc, une règle peut dorénavant opérer plusieurs actions de contrôle, plusieurs actions de réécriture et plusieurs actions de désambiguïsation.

Au commencement, je pensais que cette modification du fonctionnement n’aurait que peu de conséquences, car elle n’était pensée que pour me faciliter la tâche dans certains cas épineux, puis il m’est apparu que ça changeait en fait de si nombreuses choses que la transition de l’ancien modèle vers le nouveau n’est toujours pas achevée à ce jour. Ça n’a pas d’importance puisque ça fonctionne aussi bien qu’auparavant, mais la souplesse de ce fonctionnement apporte tellement d’avantages que je suis loin d’en avoir profité encore pleinement.

Cela dit, depuis que Grammalecte fonctionne ainsi, des dizaines de règles complexes ont déjà été fusionnées, et cela a simplifié grandement le déroulement de nombreuses opérations.Prenons un exemple simple. Auparavant, si vous écriviez « les ordinateur », il fallait deux règles de contrôle pour souligner « les » et suggérer « le », et souligner « ordinateur » et suggérer « ordinateurs ». À présent, une seule règle permet de faire les deux choses d’un coup.

Autre exemple. Mettons que nous rencontrons la graphie « militant(e)s ». Une même règle va permettre de faire trois choses :

- suggérer d’écrire ceci autrement (« militants et militantes », « militantes et militants », « militant·e·s ») ;

- étiqueter ce mot inexistant dans le dictionnaire comme « nom ou adjectif épicène pluriel » ;

- réécrire le mot en interne pour ôter les parenthèses gênantes.

Détection des erreurs

De nombreuses règles de contrôle ont été ajoutées… notamment concernant la détection de confusions concernant les mots grammaticaux. La dernière version du correcteur (v0.5.17) contient 21 actions de désambiguïsation, 687 actions du processeur de texte, 1 437 actions de contrôle ; ces actions sont réparties dans 1 939 règles.

À titre de comparatif, la version 0.4.10, qui suivait l’ancienne logique, contenait 540 règles de transformation de texte et 933 règles de contrôle, chacune n’effectuant qu’une seule action.

Ces chiffres ne sont pas nécessairement très évocateurs, parce que rien ne comptabilise les modifications du fonctionnement des règles qui sont les plus nombreuses, ne serait‐ce, par exemple, que sur les méthodes pour faire des suggestions.

En fait, le potentiel du correcteur est encore sous‐exploité, malgré les innombrables améliorations apportées ici et là. Je n’avais pas assez insisté sur ce point lors du dernier journal, alors je vais le répéter encore une fois : les détails sont ce qui réclame le plus de temps, car il faut songer que les possibilités d’erreurs avoisinent l’infini et que les possibilités de faire des faux positifs sont aussi nombreuses. Dans les faits, améliorer le correcteur grammatical, c’est s’occuper sans cesse de micro‐problématiques. Je réécris ici ce que j’ai dit la dernière fois : « Écrire des règles, c’est assez rapide ; détecter les faux positifs, c’est beaucoup plus long ; ceux‐ci ont tendance à survenir là où l’on s’y attend le moins. C’est ce qui est le plus exigeant : maintenir un ensemble de règles, améliorer l’existant, tester, trouver de nouvelles possibilités. Lorsqu’on s’occupe d’un correcteur grammatical, on passe surtout son temps à peaufiner des détails, à ajuster le fonctionnement de l’existant, à arrondir les angles. Oubliez l’idée de concevoir l’algorithme ultime qui saura gérer tous les cas. Même quand on est à peu près sûr d’écrire une petite règle tranquille qui ne générera aucun faux positif, la réalité va très probablement nous rappeler à l’ordre et nous obliger à slalomer sur ce qui paraissait au commencement comme une belle ligne droite. S’occuper de correction grammaticale, c’est marcher sur un chemin pavé d’embûches subtiles. »

C’est pourquoi l’évolution du correcteur se fait pas à pas, en évitant autant que possible les modifications radicales.

Le correcteur fonctionne beaucoup mieux depuis que toutes ces améliorations ont été faites, et j’espère que c’est sensible pour vous, car il m’est difficile de juger si ces améliorations sont visibles pour les utilisateurs.

Parmi toutes les nouveautés apportées, il y a notamment :

- beaucoup de règles pour détecter des confusions entre les mots homonymes (comme ce, se et ceux) ;

- beaucoup d’améliorations pour gérer les cas particuliers, clarifier le texte interne et augmenter le taux de détection ;

- toujours moins de faux positifs ;

- une option pour détecter les erreurs de reconnaissance optique de caractères bien plus développée (désactivée par défaut) ;

- beaucoup de règles de contrôle ont été améliorées.

Le moteur de suggestions

L’amélioration des suggestions est l’un des points qui ont le plus progressé depuis le précédent journal, grâce aux règles multi‐actions qui ont permis de rendre plus systématiques la possibilité de faire deux suggestions différentes lors de la constatation d’un désaccord de genre, de nombre ou de conjugaison ; mais aussi surtout grâce à la création d’une table de correspondance phonétique à partir de laquelle Grammalecte peut choisir des mots à suggérer en fonction de leur nature grammaticale.

La table de correspondance phonétique est un simple fichier qu’il est facile de compléter, c’est une succession de mots homonymes, comme :

- appareil, appareils, appareille, appareilles, appareillent ;

- mec, mecs, Mecque ;

- pouce, pouces, pousse, pousses, poussent ;

- tête, têtes, tète, tètes, tètent.

À partir de cette liste, Grammalecte construit un mini‐dictionnaire avec toutes les natures grammaticales possibles de chaque mot. Puis, au besoin, on peut demander, par exemple, de trouver un mot semblable à « tète » en spécifiant les natures grammaticales acceptables (via une expression rationnelle). Il y a aussi quelques propositions de substitutions automatisées, pas toujours opportunes, ce point reste à améliorer.

Si ça vous intéresse, cette table est consultable ici.

Cette table phonétique ne résout pas tous les problèmes, mais permet dans bien des cas de faire des suggestions de mots sans rapport grammatical avec le terme erroné. Avant cela, le correcteur se contentait de signaler l’erreur, mais ne pouvait rien suggérer. Quelques exemples :

- « Il appareil demain. » → appareille ;

- « La mec. » → Le | Mecque ;

- « Une goulet » → Un | goulée ;

- « Il pouce le bouchon trop loin. » → pousse ;

- « J’en ai marre de ces tètes de nœud. → têtes ;

- « Ils ne son pas idiot. » → sont.

Notez que le moteur de suggestions ne propose des mots ayant une autre racine que lorsqu’il constate une anomalie (si un verbe prend la place de ce qui devrait être un nom, par exemple) ou s’il constate une erreur de genre. S’il y a seulement une erreur de pluriel, il se contente de faire une correction de nombre. Mais il serait aussi possible dans ces cas‐là de suggérer des mots différents. Par exemple « Des homme » → hommes | ohms | heaumes.

Ça m’a semblé superflu de proposer de telles corrections, mais si vous jugez ça utile, dites‐le‐moi.

Modifications diverses

- l’écriture des règles a été modifiée, il est plus aisé de gérer la casse et les marges des motifs des expressions rationnelles ;

- les règles sont regroupées par option, afin de pouvoir ajouter des règles optionnelles sans gréver les performances (l’option de reconnaissance optique de caractères, par exemple) ;

- il est possible d’utiliser pour chaque action des opérateurs logiques (

__also__et__else__) pour écrire des conditions tenant compte du résultat de la condition de l’action précédente ; - toutes les règles ont été nommées, afin de satisfaire aux nécessités du greffon pour Vim (désactivation paramétrable de règles spécifiques) ;

- tout le processus de construction a été revu et des tests ont été intégrés pour éviter certaines erreurs d’écriture des règles ;

- des marque‐pages pour s’y retrouver dans la liste des règles, qui commence à devenir très, très longue (fonctionnalité ajoutée hier).

Capture d’écran

Voici à quoi ressemble le fichier des règles (sous SublimeText) :

Tests unitaires

Auparavant, la situation sur ce point était très mauvaise, puisqu’il n’y avait aucun test unitaire sur le correcteur, seulement des tests « manuels », c’est‐à‐dire un fichier texte que j’ouvrais de temps en temps avec Writer pour vérifier que le moteur fonctionnait comme prévu. Mais c’était loin d’être exhaustif et facile à mettre en œuvre, puisque je vérifiais « à l’œil » si à chaque ligne le correcteur trouvait bien l’erreur qu’il était censé trouver. Pénible et lent au possible.

À présent, à chaque modification, il est possible lors de la construction de tester si rien n’est cassé. Plus de 6 200 tests sont lancés (dont 2 000 repris chez LanguageTool), et chaque règle de détection doit être testée au moins une fois.

Malgré cela, les tests ne sont pas encore exhaustifs (à bien y songer, il n’est sans doute pas possible d’être exhaustif), mais la situation s’améliore indubitablement, et peu à peu le socle du correcteur devient de plus en plus solide. Grâce à cela, de nombreuses erreurs dans le fonctionnement du correcteur ont été détectées et corrigées.

Beaucoup de ces tests sont là pour vérifier qu’une règle fonctionne correctement, mais une grande partie d’entre eux existent pour éviter les faux positifs constatés lors des versions précédentes. Ce sont les tests les plus nombreux, parce que les faux positifs sont légion et qu’il est très fréquent d’en provoquer de nouveaux, quelle que soit la prudence avec laquelle on écrit les règles. Pour les éviter autant que possible, quelques textes courts ont été inclus dans les tests de Grammalecte :

- Le Horla, de Guy de Maupassant ;

- Le double assassinat dans la rue Morgue, d’Edgar Poe ;

- Les vers dorés, de Pythagore ;

- L’épître du feu philosophique, de Jean Pontanus.

Avoir écrit l’extension pour Firefox présente par ailleurs un avantage considérable pour consolider la correction grammaticale : c’est beaucoup plus facile de mettre le correcteur à l’épreuve. Presque tous les jours, je lance des analyses grammaticales sur de nombreux articles de journaux et de blogs divers ; ça me permet de repérer et corriger des faux positifs, ainsi que de nouveaux mots à ajouter au dictionnaire. Auparavant, je faisais des copier‐coller dans Writer, ce qui était bien moins commode et bien plus long.

Ces tests sont faits en Python et en JavaScript. Les deux moteurs les passent tous et fonctionnent de la même manière. Cela dit, il n’est pas malgré cela pas possible de garantir (pour l’instant) que le moteur en JavaScript fonctionne aussi bien qu’en Python.

JavaScript, mon

amourHiroshima

Passer de Python à JavaScript n’a pas été de tout repos. Et si le projet a pris du retard, ce n’est pas tellement, comme je le craignais, à cause de la difficulté de concevoir une extension pour Firefox et Thunderbird. Ce point fut plus facile que je ne le pensais, tout simplement parce que la documentation de Firefox et celle Thunderbird, quoique cette dernière soit en déshérence, sont mieux tenues et plus complètes que celle pour LibreOffice… et surtout l’API est plus simple à utiliser… Quoique… l’API de bas niveau est tout aussi compliquée, de mon point de vue… Mais comme on peut s’en passer… Bref.

La syntaxe de JavaScript ne m’a pas posé de problème. J’ai utilisé toutes les nouvelles possibilités offertes par la norme ES6 :

for … of, les générateurs, les paramètres par défaut, les paramètres du reste, la décomposition, les fonctions fléchées,Map,Set, les classes,letetconst, et même depuis peu les nouvelles commandesasyncetawait. Avec tout ça, JavaScript est un langage pas aussi horrible que je l’avais craint, même assez agréable parfois… En même temps, comme je démarrais un projet à zéro, je n’ai pas eu à me coltiner toutes les bizarreries possibles de ce langage. J’ai évité toute forme de syntaxe tord‐neurones.Ce qui m’a compliqué la vie, c’est plutôt l’écosystème de JavaScript, sa difficulté à déboguer, son comportement étrange, les incohérences et sa bibliothèque standard pauvre.

Difficulté à déboguer

Ni Firefox, ni Thunderbird (ni LibreOffice d’ailleurs) ne signalent quoi que ce soit s’il y a une erreur de syntaxe dans le code. Ça ne fonctionne tout simplement pas, et c’est tout. C’est assez pénible en Python, mais c’est bien pire en JavaScript où il est fréquent d’oublier une virgule ou un point-virgule quelque part. En outre, les messages d’erreur de JavaScript sont longs et souvent abscons, sans compter que selon le contexte d’exécution dans Firefox/Thunderbird, les messages d’erreur sont parfois encore plus imprécis, voire inexistants (le module XYZ plante, mais débrouillez-vous pour le reste, car aucune info ne sera fournie, comme où et pourquoi). Je ne vais pas rentrer dans les détails, parce que j’ai maintenant oublié la plupart d’entre eux… mais à mon avis, Mozilla ferait des heureux en améliorant les rapports d’erreur.

Inutile de s’étendre sur le comportement erratique de JavaScript et son typage faible, cela a déjà été fait par tellement de monde… Quand on vient de Python, il est facile de tomber dans tous les pièges que ce langage tend, dans lesquels même les plus experts chutent encore de temps en temps, j’imagine. La traque aux “undefined” semblant sortir de nulle part m’a particulièrement marqué.

La bibliothèque standard

La bibliothèque standard est, en restant poli, très mauvaise, notamment parce qu’elle est très incomplète, mais aussi assez peu cohérente, me semble‐t‐il. Dans beaucoup de cas, ce n’est pas bien grave, il suffit d’ajouter les fonctions dont on a besoin et c’est ce que j’ai fait, mais on se demande quand même pourquoi cette bibliothèque standard est si pauvre ou si mal foutue. Avec toute la hype autour de ce langage, c’est vraiment très étonnant.

Prenons le cas des expressions rationnelles, parce que la nullité de l’objet

Regexpest navrante… et parce que c’est ce qui est le plus utile à Grammalecte :problème 1 : pas de lookbehind assertions

Les lookbehind assertions permettent de regarder ce qui précède un motif. OK, c’est pénible, mais on peut compenser avec quelques efforts.

problème 2 : les classes de métacaractères ne comprennent que l’ASCII.

Les classes de métacaractères comme

\wet\b, ne comprennent que l’ASCII.

Oui, l’ASCII ! Ce qui donne (vous pouvez essayer dans l’ardoise de Firefox) :/^\w+$/.test("étonnant") ==> false /\bvite\b/.test("évite") ==> trueInutile de vous précipiter sur votre calendrier, nous sommes bien en 2017, et non en 1997. JavaScript est, paraît‐il, un langage moderne, mais seulement quand on n’y regarde pas de trop près.

Heureusement, il est facile de compenser l’absence d’un

\wfonctionnel par[a-zA-Zà-öÀ-Ö0-9_ø-ÿØ-ßĀ-ʯ](du moins, ce sont les plages de caractères que j’ai retenues, on pourrait en ajouter bien d’autres). Ce qui rend les expressions rationnelles un peu plus piquantes à lire…Quant à

\b, eh bien, on peut essayer de compenser avec des lookahead assertions et des lookbehind assertions. Seulement, voilà, ces dernières n’existent pas en JavaScript. Mais en magouillant, on peut simuler ça. Du moins dans presque tous les cas utiles. Tant pis pour les autres… on priera de ne pas tomber sur un caractère non ASCII.Problème 3 : pas de position des groupes capturés

Les groupes capturés n’indiquent pas leur position. Ça, c’était vraiment la mauvaise surprise. Avant de proposer la campagne de financement, j’avais vérifié ce que JavaScript pouvait faire avec les expressions rationnelles, mais je n’avais pas vu que ce point manquait à l’appel, tout simplement parce que je n’avais pas imaginé que JavaScript serait incapable de fournir cette indication.

De quoi s’agit‐il au juste ? C’est très simple. Quand vous écrivez une expression rationnelle avec des groupes de capture, comme

(\w+) (\w+) (\w+), Python vous renvoie les groupes capturés (ce qui est entre parenthèses) avec leur position dans le motif global. JavaScript ne renvoie que le contenu des groupes capturés, mais pas leur position. Débrouillez‐vous pour savoir où ça se trouve, et c’est bien plus épineux que vous pourriez le supposer, si, par exemple, vous capturez des mots comme « a », « le » ou « la », ou si vous capturez des groupes qui ne sont pas des mots entiers.Ce point seul m’a fait perdre beaucoup de temps, sans compter que ce fut un cauchemar à déboguer. J’ai même cru pendant quelques jours que tout le projet allait tomber à l’eau à cause de ça.

Car, à ce moment du développement, alors même que je bataillais pour rendre le moteur fonctionnel, j’ai pris conscience que l’exécution du code en JavaScript était environ douze fois plus lente qu’en Python, au point que lorsqu’on lançait la correction grammaticale, Firefox se figeait pendant de longues secondes… C’était évidemment inacceptable.