Linux (fr)

-

Falkon 3 le nouveau navigateur pour KDE

(Dépêches LinuxFR)

Vous souvenez‐vous de Qupzilla, petit projet commencé par le tout jeune David Rosca pour apprendre Qt, puis devenu un excellent navigateur WebKit ? En juillet 2017, pendant la réunion annuelle du projet KDE, l’Akademy, David Faure a proposé de remplacer Konqueror par Qupzilla.

Après quelques mois d’incubation, le bébé sort des éprouvettes : Falkon 3.01 est disponible depuis le 8 mai 2018. C’est un navigateur moderne, dont les onglets tournent dans des processus séparés, en utilisant QtWebEngine, lui‐même basé sur Chromium pour le rendu.

Il n’y a pas de grosses différences avec la dernière version de Qupzilla 2.2.6, c’est essentiellement une transposition vers le système de construction de KDE. Il faut bien commencer.- lien n°1 : Falkon.org

- lien n°2 : Qupzilla

- lien n°3 : L’annonce de la mutation

- lien n°4 : Journal des modifications

Les utilisateurs de Konqueror seront en terrain familier pour la partie Web et le menu de configuration, en revanche la navigation de fichiers n’est pas encore intégrée. Il faut bien commencer (bis).

Falkon protège bien votre vie privée (gestion des Cookies, de JavaScript, de HTML 5, Do Not Track), vous propose un greffon Flash (Pepper Flash), plusieurs moteurs de recherche (Duck Duck Go par défaut), un gestionnaire de sessions, des onglets avec indicateurs, un traducteur de pages Web, un validateur de code, des thèmes, une page « Speed Dial » facile à gérer, retrouve le contenu du formulaire quand on fait « précédent » — je reprends ma respiration, regardez les images :

Les indicateurs (cliquables) sur les onglets :

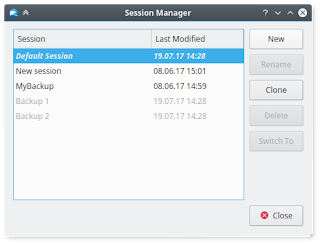

Le (très pratique) gestionnaire de sessions :

Le (sympathique) menu déroulant « clic droit » :

Et comme il est jeune et crashe un peu, Falkon recharge automatiquement tous les onglets ouverts. À ce stade, vous le constatez sans doute, c’est dans l’esprit de KDE : un mélange de simplicité et de « super‐pouvoirs » à portée de configuration.

Quelques extensions disponibles :

- AdBlock, (San Ku Kaï c’est la bataille) contre les pubs ;

- KWallet Passwords, un portefeuille pour les gérer tous ;

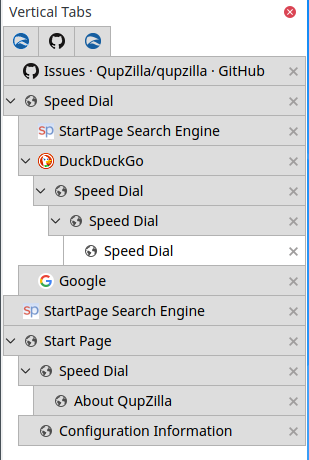

- Vertical Tabs, les onglets bien dégagés sur les oreilles ;

- AutoScroll, pour les claustros qui craignent les ascenseurs ;

- Flash Cookie Manager, protège plus que plus la vie privée ;

- GreaseMonkey, soyez le maîîîître du navigateur (scripts dispos sur http://openuserjs.org/) ;

- ImageFinder, qui recherche par l’image, par l’image trouvera ;

- Mouse Gesture, pour les souriceaux maniaques ;

- PIM, pour jouer dans les formulaires ;

- StatusBar Icons, oh que c’est zouli ces petites friandises là en bas !

- Tab Manager, « Onglets ! Au rapport ! »

Les WebExtensions qui sont déjà gérées par Chrome/Chromium, Firefox, Edge et Opera ont encore un long chemin à parcourir.

L’extension ImageFinder en menu déroulant :

L’extension Vertical Tabs en mode hiérarchique :

D’ores et déjà, Falkon est un navigateur à mon goût : avec toutes les extensions, plusieurs onglets et trois fenêtres ouvertes, il tourne comme un charme sans charger le système ; je n’ai pas de problème sur les sites Web, ou alors tellement mineurs que je fais avec.

Falkon est disponible pour GNU/Linux dans vos distributions et aussi en AppImage et Flatpak (via le dépôt KDE), sous Windows (à partir de Win 7) et macOS (à venir).

Commentaires : voir le flux atom ouvrir dans le navigateur

-

Discourse, plate-forme de discussion atypique

(Dépêches LinuxFR)

Jeff Atwood, connu entre autres pour Stack Overflow, a annoncé la sortie de la plateforme de discussion Discourse en version 1.0 le 26 août 2014 et en version 1.4 le 22 septembre 2015. La devise du projet est « Civilized Discussion. On the Internet. », soit « Discussion civilisée. Sur Internet. ».

En résumé, Discourse fonctionne à la fois comme une liste de diffusion, un forum de discussion et un salon de discussion… Il est développé en Ruby on Rails, avec Ember.js, basé sur du PostgreSQL et du Redis. Il est distribué sous la licence GNU GPL v2.

- lien n°1 : Pourquoi Discourse ?

- lien n°2 : Fonctionnalités

- lien n°3 : Code source sur GitHub

- lien n°4 : Démonstration de Discourse

- lien n°5 : Introducing Discourse 1.0

- lien n°6 : Caricature Geektionnerd sur la sortie de Discourse 1.0

- lien n°7 : Article Wikipédia anglophone

- lien n°8 : Installer Discourse

- lien n°9 : Discourse 1.4 Released!

Sommaire

- Motivations autour du lancement du projet

- Fonctionnalités de Discourse

- Principes d’une discussion civilisée

- Installation

- Technologies

- Modèle économique

Interface principale de Discourse en version 1.3.Motivations autour du lancement du projet

Extrait de l'annonce du lancement du projet en juillet 2013 :

Un des trucs qu'on a appris avec Stack Exchange est que, si ton but est d'améliorer le rapport signal sur bruit, tu dois réfréner les discussions.

Stack Exchange ne permet que le minimum absolu de discussion nécessaire à la production de bonnes questions et réponses. D'où la réorganisation constante des réponses par les votes, d'où les limites de formatage et de longueur des commentaires, le fait que peu s'affichent, et ainsi de suite. Presque toutes nos décisions de conception furent motivées par notre désir de réduire la discussion, de l'inhiber de toutes les façons possibles. Épargne-nous l'étalage kilométrique de ton avis, et réponds juste à la foutue question.

Après quatre années pleines à considérer la discussion comme l'Empire établi et corrompu, et Stack Exchange comme l'Alliance Rebelle, j'ai commencé à me demander - qu'est-ce que ça ferait de changer de camp ? Et si je devenais le champion de la discussion spontanée et impulsive, du genre que j'ai passé quatre ans à combattre aux niveaux conceptuel et spirituel ?

Fonctionnalités de Discourse

Rédigé d'après la FAQ et la page « à propos » :

- 100 % libre : intégration de Discourse dans votre site en totale confiance ; le code appartient à tous ;

- Système de confiance : au fur et à mesure que les utilisateurs deviennent des membres de confiance, ils peuvent devenir des modérateurs de leur communauté ;

- Responsive pour mobiles : conception pensée depuis le premier jour pour les écrans tactiles ; modes d'affichage automatiques qui s'adaptent à votre support mobile et/ou tactile ;

- Modération par la communauté : un système de drapeau permet à la communauté de supprimer les spams et les contenus dangereux et de résoudre amicalement ses propres disputes ;

- Optimisé pour la lecture : pour continuer à lire, faites simplement défiler la page ; quand vous atteignez le bas de page, des sujets suggérés vous amènent à rester dans votre lecture. La discussion n’est pas coupée en plusieurs pages ;

- Likes : exprimez votre accord, votre soutien, et mettez en avant des commentaires intéressants avec le gros bouton ❤ présent sur chaque commentaire ;

- Dégrossir les fil de commentaires : Bouton « Summarize » pour condenser les longs fils de discussions et n'afficher que les commentaires les plus intéressants et populaires ;

- Contexte en ligne : affichage des citations, des réponses ou du fil de discussion qui précédait une réponse ;

- Traductions : disponible dans 17 langues, et plus à venir ; les utilisateurs peuvent configurer la langue de leur choix ;

- Notifications en temps réel : avertissement quand quelqu'un vous répond, vous cite, mentionne votre @nom, vous envoie un message privé, crée un lien vers votre commentaire, modifie votre commentaire, ou re-catégorise votre discussion ;

- Référencement : URL lisible et compréhensible et HTML valide, optimisé pour l'indexation par le moteur de recherche de Google ;

- Greffons : système de greffons en cas de besoin de fonctionnalité spécifique à votre site ;

- Single Sign On : intégration fluide avec le système d'identification du site hôte ;

- Éditeur en surimpression : rédaction des commentaires dans un éditeur qui n'interrompt jamais la lecture, même si vous visitez un autre fil de discussion ;

- Identification via sites sociaux : ajout facile de Google, Facebook, Twitter, Yahoo!, GitHub, et d'autres systèmes d'identification courants ;

- Communautés privées : catégories entièrement ou partiellement privées ;

- Limitations : toutes les actions utilisateurs peuvent être soumises à des contraintes, par exemple très strictes pour les nouveaux utilisateurs ;

- Nettoyage facile du spam : suppression des spams en deux clics, bannissement d'adresse de courriel et d'IP et auto-suppression de tous les contenus associés ;

- Blocage du spam : heuristique uniforme et exhaustive, incluant un sas pour les nouveaux utilisateurs, le blocage par les utilisateurs, et l'utilisation de l'attribut nofollow ;

- Analyses : tableau de bord pour les administrateurs listant les statistiques clés des utilisateurs, les sujets de discussion et toutes les actions des utilisateurs, en incluant les domaines et sujets les plus en vogue ;

- Intégration automatique d'URL : les URL de sites populaires comme Wikipédia et YouTube incluront un résumé. Prise en charge complète de OpenGraph et oEmbed ;

- Gestion avancée des images : téléversement d'images via sélection de fichier, glisser/déposer ou copier/coller ; les grandes images sont automatiquement réduites en miniatures et affichées à l'aide de lightbox ;

- Adjonction de fichiers : inclusion de fichiers de toutes sortes et de toutes tailles ;

- Suivi de liens : les liens externes sont accompagnés d'un compteur de clics ; les liens entrants et sortants vers d'autres sujets sont affichés à coté de chaque commentaire ;

- Sondages : création rapide de sujets sur lesquels la communauté peut voter ;

- Spoilers : étiquettes qui floutent les spoilers (information cruciale qui déflore le sujet central) éventuels, ne se révélant que par un clic ou un appui ;

- Formatage flexible : mélange possible de Markdown, de BBCode et de HTML ;

- Emoji : commencer juste à taper pour avoir accès à une liste complète des emoji courants ;

- API exhaustive : tout ce qui est visible à l'écran est accessible via l'API. Discourse lui-même est une application en JavaScript qui communique avec une API ;

- Avatars locaux : génération d'avatar locaux sans dépendances externes. Possibilité de choisir un Gravatar existant ou de téléverser son avatar ;

- Invitation par courriel : les utilisateurs de confiance peuvent inviter des amis par courriel à rejoindre et participer à une discussion par un simple clic ; les administrateurs peuvent inviter des utilisateurs par groupes en renseignant une liste d'adresses courriel ;

- Brouillon automatique : les réponses et sujets sont automatiquement sauvés sur le serveur en arrière plan pendant leur rédaction ;

- Historique des révisions : suivi des révisions à chaque modification, avec mise en évidence visuelle des différences pour faire apparaître les changements ;

- Commentaires wiki : les commentaires peuvent être déclarés comme modifiables par des membres de confiance de la communauté ;

- Badges : les comportements positifs sont encouragés par un ensemble de badges préexistants ou de votre cru ;

- Notification par courriel : quand vous n'êtes pas activement sur le site web, vos notifications seront envoyées par courriel ;

- Réponse par courriel : répondez aux notifications par courriel pour participer sans visiter le site web ;

- Modération en ligne : outils de contrôle rapide en ligne pour séparer, joindre, fermer, archiver ou re-catégoriser des sujets ;

- File d'attente de drapeaux de modération : très visible, avec notification optionnelle par courriel. Un clic pour exprimer un accord, un désaccord, ou déférer un drapeau (à un autre modérateur).

- Notification sur tout le site : punaiser des sujets localement ou globalement. Affichage d'un sujet pour qu'il soit immanquable par tous les utilisateurs ; alerte permanente pour des situations urgentes ;

- Prise en charge des listes de diffusion : mode spécial pour lequel tous les messages sont envoyés par courriel, comme une liste de diffusion. Démarrage de nouveaux sujets par courriel ;

-

Espace « communauté » : sous-domaine

meta.sitewebpour discuter fonctions, bugs, et demandes d'aide. - Messages privés : envoi de messages privés à un ou plusieurs utilisateurs ;

- Sauvegarde et restauration sur le web : toutes les données du site sont enregistrables et restaurables depuis le navigateur ; changez vos données de serveur en quelques clics ;

- Sauvegardes automatiques : sauvegarde de vos données tous les jours, sur le système de fichiers local ou ailleurs ;

- Prise en charge des CDN : intégration facile de tous les fournisseurs de CDN pour accélérer l'accès au site.

Principes d’une discussion civilisée

- http://blog.codinghorror.com/please-read-the-comments/

- http://blog.codinghorror.com/training-your-users/

- http://blog.discourse.org/2013/03/the-universal-rules-of-civilized-discourse/

- http://try.discourse.org/faq

Installation

Discourse s'installe à l'aide de Docker.

Technologies

D’après le README du dépôt GitHub de Discourse :

- Ruby on Rails

- Ember.js

- PostgreSQL

- Redis

Modèle économique

Le projet Discourse vend des services d'hébergement.

Projet similaire

[NdM] Le cycle de développement est rapide, environ une version tous les quatre mois. La version 1.5 devrait arriver d'ici quelques semaines.

-

Netlibre, un nom de domaine gratuit, facilement administrable

(Dépêches LinuxFR)

Ça y est, l'heure de l'auto-hébergement est arrivée ! La famille a un Raspberry Pi qui sert à partager les montages des plus belles parties de Call of Duty de grand-maman, grand-papa tient un blog de jardinage en milieu urbain, le plus jeune héberge des serveurs de jeu (minetest, xonotic, redeclipse, teeworlds)… le monde est beau !

Ah mais zut, il faut payer chaque année une petite somme d'argent pour avoir un nom sur le grand 'ternet ! Ce n'est pas bien cher, mais si on veut simplement s'essayer à l'auto-hébergement cela peut être un frein. Il existe cependant une solution…

- lien n°1 : Un DynDNS gratuit, libre, et plus encore.

- lien n°2 : Alsace Réseau Neutre - l'association qui gère l'infrastructure

- lien n°3 : La brique Internet

- lien n°4 : Letsencrypt !

- lien n°5 : #arn sur Geeknode pour nous contacter

- lien n°6 : Le code

Le service netlib.re

Netlib.re est un service en ligne, basé sur du code libre, qui vous permettra de gérer une zone (un nom de sous-domaine) gratuitement. L'interface est simplifiée au possible pour ne pas décourager les moins aguerris d'entre-nous. Il est possible également d'utiliser ce service comme remplaçant direct de DynDNS, puisqu'avec un simple script on peut mettre à jour sa zone, ce qui est pratique pour les personnes qui ont une IP dynamique.

Votre nom de sous-domaine ressemblera à "quelque-chose.netlib.re" ou "quelque-chose.codelib.re", en utilisant les deux seuls noms de domaine actuellement disponibles.

Concrètement, une personne loue un nom de domaine auprès d'un bureau d'enregistrement (moi), et permet à tout le monde de créer des noms de sous-domaines à partir de celui-ci, sans limite de nombre. Le service est hébergé sur l'infrastructure d'Alsace Réseau Neutre, le serveur DNS est redondé (un à Strasbourg, l'autre chez Tetaneutral à Toulouse) n'ayez donc pas trop peur d'une coupure de courant malencontreuse.

L'avenir sera automatique ou ne sera pas.

Toujours dans l'idée de conquérir le monde il serait intéressant d'automatiser la création de comptes pour les nouvelles personnes. Dans le cadre de la brique par exemple, on pourrait penser fournir un nom de sous-domaine à chaque personne en même temps qu'on fournit l'appareil. Ainsi, chaque personne souhaitant devenir indépendante pourrait repartir avec un serveur lui permettant de s'héberger à la maison (site web, lecteur de flux rss, galerie d'images, mails, partage de fichiers, torrents…) mais aussi un nom et pourquoi pas bientôt un certificat pour qu'on soit sûr qu'on discute bien avec Gertrude Touchatonq et pas avec un vilain pirate informatique.

Le choix entre deux noms de domaine, c'est peu !

Pour l'instant n'importe qui peut choisir entre avoir un nom de domaine en « .netlib.re » ou en « .codelib.re ». C'est assez peu, mais n'hésitez pas à me contacter (via Alsace Réseau Neutre) pour aider financièrement à ajouter des noms de domaine disponibles.

Le code de netlib.re (section pour dév. et sys/admin)

Le code de netlib.re est hébergé actuellement sur Github, il est fait avec beaucoup d'amour en langage Perl, et utilise le framework Dancer.

Le README évoluera dans les semaines à venir pour y inclure une procédure pour installer le programme, ainsi que tous les logiciels nécessaires au bon fonctionnement.Pour le moment, le service fonctionne avec un serveur maître Bind9 (avec contrôle rndc), un serveur esclave nsd4 (avec contrôle nsd-control en local), et un serveur web qui discute avec les deux précédents via ssh.

Donc si vous avez déjà quelque-chose ressemblant, mettre en place votre propre instance du programme sera un jeu d'enfant, et à vous le partage de nom de domaine ! -

Tutoriel 3D - 2D découpe au laser, le retour du tux

(Journaux LinuxFR)

Sommaire

- Tranche de pingouin

- Au début était le cube

- Il est gros vot manchot ?

- Et si on l’écartelait ?

- Mais quand est-ce qu’on coupe ?

- Et si on l’empalait ?

- On l’empale plus ?

- Parlons peu, parlons kerf

- C’est la lutte finale

- Le petit oiseau va sortir

- TuxOlaser

- Déboitage du tux et montage

- Tadaaaa

- A propos de licences

- Les fichiers

Tranche de pingouin

Chose promise, cause perdue. Voici comment transformer un modèle 3D en tranches de bois pour découpe laser. Et en bonus, mon essai initial de découpe en création originale.

Les outils que j’ai utilisé sont blender et inkscape, et ce juste parce que je les connaissais et donc plus facile pour expérimenter.Note aux amateurs de freecad, j’ai commencé à regarder comment ça marche, au cas où ce serait plus simple avec, si jamais je trouve une idée et le courage de refaire un tuto, ça me fera un zeugma.

Au début était le cube

Ouvrir un nouveau fichier dans blender et mettre la scène en métrique, car sinon les mesures ne sont pas fixées par taille réelle. Notez que à chaque étape du tuto on aura des soucis de conversion de dimensions, donc en fait… mais bon faut pas en profiter pour être négligent.

Retirer le cube et ajouter le Tux à la scène. Vous pouvez le trouver ainsi que toutes les licences à Tuuuuuuux

- Faire face au tux (1 au pavé num)

- Mettre la vue iso (5 au pavé num)

- sélectionner le tux

- passer en editor mode (tab)

- Sélectionner le dessous des pattes (B) qui est rond

- Niveler (SZ0)

- sélectionner les deux centres des pattes, (S) Snap cursor to selected

- rebasculer en object mode (tab) , transform origine to 3d cursor (object/transform)

Maintenant, le tux est calé pour avoir le plancher des pattes en comme origine, à la verticale du pseudo centre de gravité que nous venons de choisir.

mettre la bête en Z 0.

Il est gros vot manchot ?

Il nous faut choisir une taille, suffisamment grosse pour que ce soit cool, et pas trop gros pour limiter le prix. Comme l’objet c’est aussi tester une bonne quantité d’épaisseurs pour voir comment ajuster la taille théorique d’une planche par rapport à sa taille réelle (il reste du vide, la colle ça épaissit, les planches sont pas forcément pile à la taille).

Une planche 2mm chez sculpteo (chez qui je teste la découpe laser) fait 94cm*59cm, il faut aussi essayer de rester dans une seule planche avec tous les morceaux. Le tux est presque aussi large que haut, du coup on cherche une approximation de cube découpé en tranches et étalé fait la même surface en gardant un peu de marge. ça fait 55 tranches, donc une hauteur de 116.875mm

Et si on l’écartelait ?

Il nous faut séparer les pattes du corps du tux (ce sont des objets distincts dans le modèle de base en fait et elles s’interconnectent :

Il faut les réunir par booléen union au corps pour avoir un seul objet avec un intérieur/extérieur propre.

On peut maintenant appliquer une subdivision sur le tux CTRL+3, parce que le tux aime la douceur, et pas que celle angevine.

Lui sculpter des yeux plus sympa, parce que même si tout le monde ne veut pas l’avouer, pour avoir l’air cool faut quand même avoir un peu l’air con.

Mais quand est-ce qu’on coupe ?

Patience, il faut regarder un peu avant de couper. Placer un plan plus grand que le tux au sol, genre 20cmx20cm et lui appliquer un booléen d’intersection avec le tux. Et regarder en bougeant le plan sur Z comment seront les tranches.

On voit deux endroits à problème, les ailes et la queue qui auront des tranches avec plus que un morceau, ce qui est plus complexe à coller.

par ex les ailes :

Ce sera lourd à coller ensuite, on peut mais pourquoi…

autant relier les ailes au tronc le plus légèrement possible, avec un lien de 1mm de large.

idem au niveau de la queue :

J’ajoute un bloc en union au niveau de la queue, le plus ajusté possible par un booléen union.

Cela vous permettra de facilement coller, il sera toujours possible de le limer après collage.

Il faut bien nettoyer le résultat de l’union à l’intérieur du tux, ne pas laisser de cloisons internes, c’est à dire éviter d’avoir des plan à l’intérieur des plans :

Finir de nettoyer en retirant les doublons de vertices, boucher les trous, assurer les normales pour que ce soit clair ce qui est à l’intérieur et à l’extérieur.

Et si on l’empalait ?

Pensons au support central qui va nous permettre de facilement positionner et coller les tranches de tux, il va être en trapèze et ressembler à ça au niveau d’une tranche :

Le choix de la découpe sera donc toujours du côté le plus grand, en bas. Donc notre référence pour le positionnement des plans de découpe doit être la face basse de chaque tranche.

Replaçons le plan à 0.01mm en Z (pour éviter le chevauchement parfait des surface avec les pattes Z=0), pensez à remettre tous les éléments avec scale=1 (Ctrl+A scale and rotation) pour la suite.

Faire une array de 50 plans en Z espacés de 2.125mm, faire le booléen intersection avec le tux. Lors de la réalisation de mon bureau réel avec des tux, j’ai constaté que l’empilage de x tranches de 2mm n’a pas un résultat de x*2mm, mais avec l’air restant et la colle environ 2.125. Je vais affiner avec ce tux cette estimation mais déjà on part de 2.125mm par tranche.

On voit les tranches et on voit des petits problèmes

Une tranche qui manque en haut et le cul qui a une mini tranche en bas.

Diminuer le overlap thresold du booléen pour que le problème du haut disparaisse :

Remonter le point du bas du tux pour supprimer le second problème et non, ce n'est pas lui mettre un doigt dans le cul car ça ne doit pas rentrer :

Nickel !

Simulons une épaisseur des tranches pour avoir un aperçu du résultat réel, ajoutons au plan un modifier solidify 2mm avec l’offfet à +1 (vers le haut) pour suivre le plan d’avoir la face basse comme référence :

Le résultat est conforme, retirez le solidify, il ne doit pas interférer avec l’étape de création du lien central.

On l’empale plus ?

Mais si, mais si. En fait ce n’est pas obligatoire, mais ça facilite le positionnement des étages, et on peut aussi le garde sans le coller. Le lien central doit avoir une forme de trapèze et être parfaitement vertical, car pour l’instant sculpteo ne fait pas de découpe oblique.

Il doit faire une épaisseur égale à celle du bois. Pour mon exemple je suis resté sur mon approximation (2.125mm) mais normalement il faut prendre 2mm et ajuster avec l’épaisseur du kerf qui est la taille du laser laissant un vide de découpe autour du trait de coupe. En pratique lors de mon premier essai j’ai eu des soucis d’épaisseur et j’ai du poncer mon trapèze. Du coup comme ce n’est pas nécessaire d’ajuster. Je surestime cette fois-ci la taille du trapèze.

Il faut ajuster sa position pour qu’il traverse tout le tux, coup de chance c’est possible sur ce modèle en plaçant la traverse au centre de la dernière tranche du tux. Mais sinon on l’aurait simplement fait avec deux trapèzes sur deux hauteurs.

Ajustez la taille en X et la hauteur de la partie haute pour faire joli, elle va dépasser un peu et même arrondir sa tête (note postérieure en pratique le trapèze sera toujours trop court, il faut juger les tranches encore un peu plus grand que 2.125mm).

En dessous ajuster aussi la taille en X pour donner un beau trapèze

On voit que c’est moche au niveau du pied

On va donc remodeler un peu le trapèze pour qu’il soit plus joli à cet endroit.

Parlons peu, parlons kerf

Le kerf c’est la partie du bois éliminée par le laser, en pratique la découpe est plus petite que le plan car le laser à une taille non ponctuelle. la découpe de la traverse dans les tranches sera donc un peu plus grande que prévu, et la traverse découpée plus court aussi que prévu.

Dans ce modèle, on peut ignorer le kerf et accepter les différences, elles seront minimes et les pièces collées seront bien ajustées.

appliquons donc le booléen différence entre le plan des tranches et la traverse

Le résultat est difficile à voir mais en vue fil de fer c’est visible

C’est la lutte finale

On peut passer à la phase finale, on réalise les “modifier” sur les planches, puis on aplati le trapèze en retirant les vertices d’un côté.

En mode éditeur, on sépare toutes les tranches (P+loose parts en mode édition) et on les étale dans le bon ordre en vue du dessus. Attention, les numéros générés lors de la réalisation de l’array ne sont pas forcément dans l’ordre de Z…

Pour ne pas me planter, je me met dans une vue adaptée et je bouge une par une les tranches avec des gx0.1 … Je vérifie bien que tout est dans l’ordre puis je met tout le monde à plat (sélectionner tout A puis SZ0)Nous allons avoir des soucis de conversion de taille entre blender puis Inkscape puis sculpteo… on commence par poser un étalon dans blender, un plan au sol de 1cm sur 90cm

Le petit oiseau va sortir

Enfin presque, il faut encore à faire la photo !

Il existe une option de rendering qui génère du svg.

Mettons la caméra au dessus en mode orthographique, d’abord une résolution 100% sur un ratio approximatif de mon rectangle incluant tout.

puis placer la caméra assez bien au dessus de la scène et changez les paramètres :

L’échelle orthographique est ce qui correspond au zoom, ajustez la valeur pour que tout rentre au plus juste

Tout doit rentrer dans la fenêtre de rendering :

Maintenant depuis les user pref, activez le svg freestyle exporter :

Et activez les deux options freestyle et svg export depuis les options rendering

Pressez F12, une image svg sera générée dans le répertoire indiqué dans output nommé 0001.svg,Ouvrez le dans Inkscape, dégroupez et sélectionnez l’étalon. mettez lui une épaisseur de contour à 0 pour ne pas fausser la taille et regardez sa taille. Dans mon cas je tombe sur 35.719cm.

Je vais donc changer la résolution de l’image pour ajuster la taille d’un facteur de 90/35.719=2.52

Je change dans blender le render pour :

Re F12 et vérification.

Mon étalon fait maintenant 1cm sur 90.01cm.

aller, on essaie avec un pixel de moins en Y :), on tombe sur 89.987. C’est moins bon, retour en arrière.Maintenant que l’on a les bonnes tailles dans Inkscape, il faut nettoyer. Parce que le freestyle a introduit des pixels de temps en temps.

Je prends donc chaque découpe pour la repositionner au mieux et aussi supprimer les traces.

Pour m’aider et aussi servir d’étalon entre Inkscape et sculpteo je place un cadre dans une autre couleur qui délimite ma sélection, 53.5cm de large sur 75cm de haut.

Et je fais tout rentrer dedans.

Je vérifie chaque pièce pour assurer qu’il n’y a pas de défaut, et j’assure les contours à 1px et mon cadre avec une couleur différente

C’est prêt.

Pour ceux qui sont plus observateurs que moi, vous verrez que j’ai oublié de grouper une fente dans une tranche. Moi je vais le voir au montage plus tard…TuxOlaser

J’upload chez sculpteo.

Deux couleurs sont détectées, l"une correspond au noir et l’autre au rouge du cadre. Les mesures n’ont pas été conservées, je ne sais pas pourquoi… mais mon cadre me permet de choisir un ajustement de taille à 26.5% qui me redonne les bonnes dimensions.Je peux alors désactiver le cadre rouge dans sculpteo (style 2 sur aucun et voila !

prêt à couper.Livraison comprise il vous en coûtera 53.33€.

Pour info, les tux du bureau ont coûté moins cher, ils étaient en une seule livraison et un peu plus petits, 72€ les 3.Déboitage du tux et montage

Je hais les video de unboxing, et me voilà moi même à déboiter…

Bon, puisqu’il faut :

la boite est bien protégée

et la planche dans la mousse

Les pièces sont tenues par du scotch, il faudra faire attention en retirant le scotch de ne pas casser les pièces fragiles.

Je numérote mes pièces avant de défaire, c’est moins cher que de faire des numéros au laser.

Ensuite on empile jusqu’à la fameuse pièce 33 qu’il faudra redécouper.

Tadaaaa

A propos de licences

J’ai fouillé pour trouver les licences attachées au modèle de base, les voici :

https://opengameart.org/content/tux

https://opengameart.org/sites/default/files/license_images/gpl.png

http://www.gnu.org/licenses/gpl-3.0.html

https://opengameart.org/sites/default/files/license_images/cc-by.png

http://creativecommons.org/licenses/by/3.0/Les fichiers

Voila les fichiers sources blender et le inkscape (piece 33 corrigée)

fichier blender

fichier svgCommentaires : voir le flux atom ouvrir dans le navigateur

-

Microcontrôleur de DEL basé sur ESP8266

(Dépêches LinuxFR)

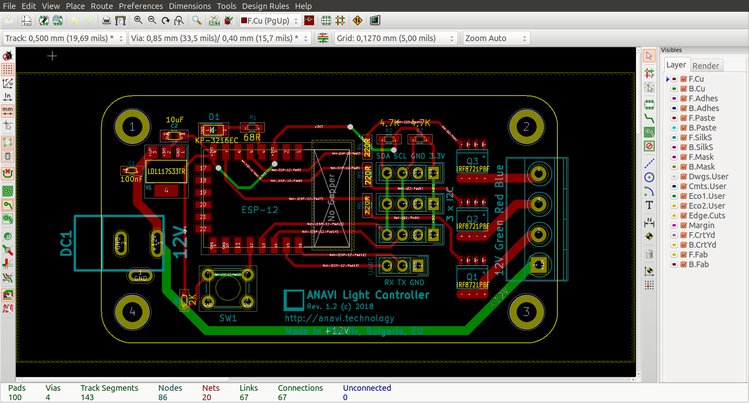

ANAVI Light Controller est une nouvelle carte matérielle libre pour contrôler un ruban de DEL (LED strip RGB). Ce projet est libre et conçu avec KiCAD, et disponible à l’achat à partir de 25 € jusqu’au 27 juin 2018.

La carte peut être utilisée de façon autonome avec le logiciel embarqué de démo en se connectant sur une page Web (MQTT d’Eclipse Paho). Mais passer par Internet via un broker MQTT public n’est peut‐être pas idéal pour tous, donc une autre solution est tout aussi envisageable via une passerelle locale (et optionnellement accessible à distance).Naturellement, ce microcontrôleur (MCU) ESP8266 peut être aussi reprogrammé, c’est une alternative intéressante aux populaires Arduino car un bloc Wi‐Fi (pas libre ?) est intégré au MCU.

- lien n°1 : Commander l’ANAVI Light Controller sur Crowd Supply

- lien n°2 : Vidéo de démo avec Mozilla Web Things

Pour ma part, j’ai eu la chance de tester le produit, ça fait le job comme on dit ! Mais je vous invite à lire la revue en français sur le blog Framboise314.

Pour utiliser une passerelle locale, il faut préalablement installer Mozilla IoT Gateway sur Raspberry Pi et reprogrammer le MCU avec mon implémentation de RGBLamp qui utilise l’API WebThings de Mozilla se connectant ensuite via mDNS, HTTP, REST (voir vidéo)…

Pour ceux qui ne veulent pas faire un pas hors de leur système d’exploitation préféré, considérez le précédent produit de Léon pour Raspberry Pi.

Finalement, si vous utilisez Mozilla IoT, les retours sont bienvenus.

Commentaires : voir le flux atom ouvrir dans le navigateur

-

Pimp my FnacBook

(Journaux LinuxFR)

Cher Journal,

Je t'écris pour la première fois en ce beau jour de Noël pour te parler du cadeau que j'ai trouvé ce matin dans mon petit soulier: un FnacBook, c'est à dire un livre numérique, aka: une liseuse. Ma première réaction fut de m'asseoir en face du père Noël, qui s'était arrêté pour prendre un café, et de lui dire que non, décidément, je n'ai pas l'usage d'un livre numérique. J'ai beau lire beaucoup, je ne vois pas comment un appareil électronique, donc fragile, et qui fonctionne sur batterie pourrait remplacer un livre en papier, que je considère comme un objet absolument parfait, du moins pour l'usage que j'en ai. Le père Noël me dit de réfléchir et repartit par la cheminée.

A l'heure qu'il est, je n'ai donc pas encore déballé mon FnacBook et je me renseigne sur les détails techniques de la bête. Et LÀ, je dois dire que je suis épaté par ce que je vois sous le capot :

1) GNU/Linux

2) Papier électronique

3) Carte micro SD

4) Accéléromètre

5) Wifi

(et roulements de tambours)

6) Carte SIM GPRS/EDGE/3G (réseau SFR)

Je précise qu'il n'y a aucun abonnement lié à la carte SIM. Mon premier réflexe, c'est donc de me demander si je peux installer un navigateur sur la bête ? Car rends-toi bien compte, cher Journal, des capacités qu'offrirait un tel système : on parle là d'avoir un accès internet illimité pour zéro euro, sur un écran à encre électronique qui tient dans la paume de la main avec une autonomie de quinze heures (ok, je fantasme sur l'autonomie annoncée de l'appareil, qui ne prend probablement pas en compte la connexion 3G).

Bon, en gros : soit je parviens à trouver une manière de modifier l'UI et l'OS pour utiliser un navigateur, soit je rends la bête au magasin. Journal, qu'en penses-tu ? Est-ce que ce projet te paraît réalisable ? -

Site web : Wywiwig et drag & drop

(Journaux LinuxFR)

Bonjour nal

Ne m'en veux pas : j'ai lâché des mots techniques et en anglais dans le titre … mais on est bien chez des techniciens ici, non ? ;-)

La recherche

Ca fait un moment, que je me dis qu'il est bizarre qu'il n'existe pas de gestionnaire de site web qui permette d'éditer et modifier facilement des pages (comme savent le faire les strikingly, weebly, wix et consorts) mais en logiciel libre et installable sur mon serveur.

WordPress (et PluXml et Drupal et d'autres) sont des (CMS aka Content Management System aka Gestionnaire de Contenu). Du coup, ils sont très bien pour gérer des pages de contenu (du blog, un site institutionnel avec pas mal de pages et un formatage identique …) mais ils sont compliqués à utiliser dès qu'on veut faire du site one page ou une landing page avec une mise en page sympa.

Alors bien sur, avec WordPress, il y a des thèmes avec un paquet de plugins qui permettent d'arriver à un résultat très sympa … mais quand on voit les manipulations à effectuer (et la lenteur) ce n'est pas très user friendly … même pour des informaticiens ! Tandis qu'avec les logiciels sus-nommés (strikingly, weebly, wix …) on attrape et dépose sur la page les éléments qu'on veut et on les modifie, comme dans un traitement de texte (ou un logiciel de PAO).Le résultat

Après cette longue introduction, voici le résultat de mes recherches.

Dans le monde libre, je ne connaissais que Oddo qui faisait de la création de site web en drag & drop … mais bon, installer Odoo juste pour faire un site de quelques pages, c'est un peu trop.Alors aujourd'hui, j'ai un peu cherché et j'ai trouvé (dans mon ordre de préférence) :

impresspages

Ca fait exactement, ce que je voulais : du drag & drop wysiwig et libre (licence MIT). De plus, l'ecosystème a l'air assez vif : ils ont pas mal de thèmes et encore plus de plugins. Certains thèmes et plugins ne sont pas gratuits … mais il faut bien que tout le monde mange. Très facile à tester sur leur démo en ligne.Respond

Un CMS qui serait classique si l'édition des pages ne se faisais pas directement dans les pages et avec du drag & drop : une solution à explorer ! Par contre, l'écosystème a l'air faible (5 thèmes, pas de plugins).Microweber CMS

Fait ce que je recherche et bien plus : blog, et e-commerce. Peut-être un peu trop : à étudier.BuilderEngine

Il fait des choses mais a l'air un peu complexe et pas très user friendly (d'après les photos d'écrans, ça ressemble aux usines à gaz WordPress).

Vos expériences

Du coup, je suis à la recherche de retours d'expérience sur ces produits ou d'autres similaires (toujours en Open Source pour installer sur son serveur).

… je posterai également mes propres tests : pour le moment, j'ai juste tester la démo de Impresspages, tous les autres nécessitant de donner son adresse e-mail.

-

Migrer Windows 10 d'un disque BIOS/MBR, vers un SSD en mode UEFI/GPT avec des logiciels libres

(Journaux LinuxFR)

Sommaire

- Introduction

- Prérequis

- Nomenclature

- Procédure de base

- Quelques pistes si ça ne fonctionne pas…

- Documentation, pour aller plus loin…

- Historique de révisions

Introduction

Ce tutoriel vous guide pas à pas pour migrer votre installation de

Windows qui est actuellement sur un disque dur de votre PC vers un

nouveau disque, en l'occurrence un SSD. A vrai dire, vous pouvez aussi

bien migrer vers un autre HDD.La spécificité de ce tutoriel est qu'elle utilise les outils fournis par

Microsoft avec Windows ainsi que des logiciels libres (Clonezilla

principalement, mais si quelque chose devait mal tourner vous pouvez avoir

besoin d'utiliser fdisk, gdisk ou testdisk pour ne citer qu'eux). Quand

j'ai voulu faire cette migration je n'ai pas trouvé de tutoriel

expliquant de bout en bout comment faire cette migration juste avec les

outils de Microsoft et des logiciels libres.Typiquement, vous pouvez avoir envie/besoin de faire cela car vous avez

acheté un nouveau disque pour remplacer l'ancien (par exemple car

l'ancien montre des signes de faiblesse, ou vous voulez améliorer la

réactivité de votre système).En plus de la migration du système d'exploitation, ce tutoriel vous

explique comment passer d'un démarrage en mode BIOS/MBR à un démarrage

en mode UEFI/GPT.Succinctement la démarche est la suivante, d'abord installer le nouveau

disque dans le PC, et initialiser la table de partition selon les normes

Microsoft. Puis cloner/dupliquer la partition contenant le système

d'exploitation à l'aide de Clonezilla. Ensuite et avant de redémarrer

dans le clone de Windows sur le SSD, faire quelques modifications dans

le registre pour que la lettre de lecteurC:pointe vers la bonne

partition et éventuellement modifier le mode SATA en AHCI si vous le

modifiez aussi dans le UEFI/BIOS. Après cela, on va préparer la

partition système EFI/ESP pour que le PC puisse démarrer dessus et qu'il

démarre sur le Windows du SSD. Finalement, une fois dans le Windows du

SSD, on va réactiver l'"environnement de récupération de Windows".Mise en garde : Faites une sauvegarde de vos données avant toute

opération. Personne n'est à l'abri d'une mauvaise manipulation ou d'une

erreur.Prérequis

Compétences

Niveau de difficulté : Difficile.

Vous devez être à l'aise au niveau de l'utilisation de la ligne de

commande dans Windows, mais aussi assez à l'aise pour gérer les

partitions de votre disque. Savoir modifier le paramétrage de votre

Firmware UEFI/BIOS et aussi nécessaire. Ce tutoriel guide pas à pas pour

la majorité des opérations. Certaines n'ont pas été détaillées par souci

de simplicité et d'efficacité.Matériel

Le PC où vous voulez installer le SSD. Il faut qu'il soit en état de

marche. De plus il doit avoir un firmware UEFI. S'il n'a que un BIOS

standard, sans UEFI, ce tutoriel n'est pas adapté.Clé(s) USB ou plusieurs CD/DVD sur lequel vous aurez mis

Clonezilla, System rescue

CD et un environnement de démarrage

Windows PE, ou Windows RE, ou le DVD/Disque d'installation de Windows.Le disque SSD (testé avec Samsung SSD 860 EVO 250GB). Il doit avoir une

taille suffisante pour contenir votre partition de Windows. Dans tous

les cas, la taille de la partition qui contiendra Windows sur le SSD

doit être au moins égale à la taille de la partition Windows du HDD que

vous voulez cloner. Au besoin, pour remplir ce critère, réduisez la

taille de votre partition Windows avec le gestionnaire de disque de

Windows par exemple (ou un autre outil de gestion de partition, comme

gparted, sur le System Rescue CD). Cherchez sur internet si vous ne

savez pas comment faire.Logiciel

Windows 10 installé (en version 64 bits) (testé avec Win10 v1709)

Windows 10 PE ou support d'installation de Windows 10 (clé USB ou DVD) -

En Version 64 bits (testé avec un support d'installation de Win10 v1804)System rescue CD (version 5.2.2 par

exemple)Clonezilla installé sur une clé ou un CD.

Bien vérifier avant que votre système arrive à démarrer dessus. (Testé

avec Clonezilla 2.5.5-38)Nomenclature

SSD : désigne le nouveau SSD

HDD : désigne votre disque actuel, sur lequel est installé Windows

WinPE : un environnement de démarrage Windows PE, ou Windows RE, ou le

DVD/Disque d'installation de Windows. Il doit être sur un support

amovible (USB, CD ou DVD)S: La lettre de lecteur affectée à la partition Système EFI qui sera sur

le nouveau SSD (parfois appelée ESP, EFI_System_Partition ou encore

SYSTEM, ou EFI)N: Le clone de Windows, sur le SSD

O: Le Windows cloné, sur le HDD

C: La partition dans laquelle est installée Windows, lorsqu'on est dans

Windows (que ce soit le windows cloné, ou le clone)Les commandes doivent être lancées en tant qu'administrateur.

Procédure de base

Fixer et brancher le SSD dans l’ordinateur

Désactiver Windows FastStart (cf votre moteur de recherche préféré)

-

Initialiser et partitionner le disque à l'aide de Windows

- Démarrer sur le Windows installé ou WinPE

- Pour initialiser le disque, d'abord créer une table de partition,

puis partitionner le disque. Pour ce faire :

- Suivre les instructions de partitionnement UEFI/GPT selon Microsoft. Ci-dessous mon exemple, mais peut-être avez-vous besoin d'une partition "recovery" aussi, ou votre configuration nécessite quelques aménagements. Dans ce cas, voir les instructions de Microsoft et adapter pour vos besoins.

- Par exemple: une partition EFI de 260Mo, une partition

Microsoft Reserved (MSR) de 16Mo, une partition pour Windows

(taille au moins égale à la taille de la partition de Windows

à cloner). Pour informations, dans diskpart, les tailles que

vous donnez en MB/Mo sont en réalité des MiB/Mio (220 =

10242 octets).

- Ouvrir une invite de commande en mode administrateur et

lancer

diskpart

. Et une fois dans diskpart :

- list disk pour lister les disques et connaître le n° du SSD.

- select disk # avec le numéro du SSD à la place de #

- clean Supprime le contenu du disque / l'initialise

- convert gpt Définit que le disque aura une table de partition GPT

- create partition efi size=260 Crée une partition EFI de 260MiB

- format quick fs=fat32 label="System" Formater la partition EFI au format FAT32

- assign letter="S" Lui donner la lettre S

- create partition msr size=16 Créer une partition Microsoft Reserved de 16MiB

- create partition primary

Créer la partition pour Windows (l'équivalent du

C:) - format quick fs=ntfs label="Windows" Formater la partition pour Windows au format NTFS

- assign letter="N" Lui donner la lettre N

- list volume Liste les volumes. Permet de voir la table de partition.

- exit Quitte diskpart

- Ouvrir une invite de commande en mode administrateur et

lancer

diskpart

. Et une fois dans diskpart :

-

Cloner le Windows installé sur le HDD. Ceci sera fait à l'aide de

Clonezilla- Redémarrer dans Clonezilla

- Une fois dans clonezilla, et si vous êtes confortable avec les

lignes de commande Linux, éventuellement supprimer de la partition

Windows du HDD les fichiers

pagefile.sys,hyberfil.sys(désactiver windows faststart avant),swapfile.sys. - Cloner la partition Windows du HDD vers le SSD (de préférence,

partition de même taille, et de toutes façons, la partition de

destination doit être plus grande que la source. Si ce n'est pas

le cas, réduisez d'abord la taille de votre partition Windows

depuis Windows). Dans clonezilla, utiliser le mode Partition vers

Partition, et en mode Export. Utiliser les options

-e1 auto(automatically adjust file system geometry for a ntfs boot partition if exists)-e2(sfdisk uses CHS of hard drive from EDD (for non grub loader)-r(resize filesystem to fit partition size of target)-m(do NOT clone boot loader)-v(verbose) - Optionnellement cacher la partition contenant le windows source de la table de partition du disque source (si vous ne savez pas à quoi ça sert, passez votre chemin). Pour cela modifier le type de partition de la partition NTFS de windows (en principe, NTFS a un id de « 7 ». On peut utiliser id 17 pour la partition cachée : 17 correspond à « IFS Hidden »). Utiliser cfdisk ou fdisk pour faire ce changement (ce sont des programmes linux).

Dans le Firmware UEFI (ou BIOS-UEFI), on peut en profiter pour passer

du mode SATA "IDE" vers "AHCI". Windows n'aime pas ce changement et

il faut donc faire une opération dans le registre qui est

détaillée ci-dessous. Tant que vous ne le faites pas, vous aurez un

écran de plantage bleu de windows au démarrage (BSOD).Si vous voulez être sûr de ne pas faire de bêtise dans le Windows que

vous venez de cloner, je vous conseille d'éteindre l’ordinateur & de

débrancher l’ancien disque. Ainsi vous ne risquez pas de modifier le

mauvais fichier de registre (en l'occurrence celui de votre Windows

sur le HDD)-

Effectuer quelques opérations sur le Windows de destination (celui

sur le SSD) avant qu'on ne démarre dessus. En particulier corriger le

registre pour affecter la lettre de lecteur C: à la bonne partition,

et si le paramétrage du Firmware UEFI (BIOS-UEFI) a été modifié pour

passer de SATA Mode PCI vers AHCI, on va aussi faire ce changement

pour que ca fonctionne.- Redémarrer dans WinPE (en Mode UEFI, pas MBR !)

- Tout d'abord déterminer la lettre de lecteur affectée au clone

de Windows, celui qui est sur le SSD. Ou, s'il n'y a pas de

lettre affectée, lui en donner une, par exemple

N:(lettre utilisée dans les exemples qui suivent)- Pour cela, lancer dans

diskpart

- list volume

Ce qui retourne la liste des volumes avec la lettre de lecteur qui a été affectée à chacun.

- list volume

- Si aucune lettre de lecteur n'est affectée, il faut alors

lui en affecter une. Pour cela, lancer dans

diskpart

- select volume # (avec # étant le numéro du volume qui contient le nouveau windows)

- assign letter=N

S'il n'est pas possible d'utiliser select volume alors faire comme ceci - list disk

- select disk # (# étant le numéro affecté au SSD)

- list partition

- select partition # (# étant le numéro affecté à la partition de Windows sur le SSD, probablement 3)

- assign letter=N

- Pour cela, lancer dans

diskpart

- Faire un CHKDSK /F sur la lettre du nouveau Win

- Pour que la partition

C:utilisée par Windows soit celle du SSD et pas celle de l’ancien disque, modifier une clé de registre du nouveau Windows :- Lancer

REGEDIT

et dans le registre HKEY_LOCAL_MACHINE monter la ruche

N:\Windows\System32\Config\SYSTEM. Lui donner le nom "NewWin" On s’intéresse àHKEY_LOCAL_MACHINE\NewWin\MountedDevices. Ce sont là les valeurs qui sont dans le registre "HKEY_LOCAL_MACHINE\SYSTEM\MountedDevices" lorsqu'on est dans l'installation de Windows.- Dans

HKEY_LOCAL_MACHINE\NewWin\MountedDevicesmodifier la lettre de lecteur C: en renommant \DosDevices\C: par \DosDevices\O: (car la valeur fait référence à la partition de l'ancien Windows sur le HDD et on ne veut pas, en démarrant, utiliser cette partition mais celle de son clone qui est sur le SSD). Ainsi, lorsqu'on démarrera dans le nouveau Windows, la partition contenant le Windows sur le HDD aura la lettre O:, et la partition contenant le Windows sur le SSD aura la lettre C: - Créer une nouvelle valeur binaire nommée \DosDevices\C:

et lui donner comme contenu celui de \DosDevices\N: qui

est renseignée dans le registre WinPE, c'est-à-dire là

HKEY_LOCAL_MACHINE\SYSTEM\MountedDevices(C:étant la lettre qu'utilisait le Windows du HDD comme partition où il y a le dossier \Windows ) - ATTENTION: Bien vérifier que la copie a fonctionné et qu'il y a les bonnes valeurs, car dans mes essais, j'ai du m'y reprendre à 2 fois car le 1er "coller" ne collait pas ce que je voulais.

- En principe c'est tout. Mais d'après certaines sources,

il y aurait une clé \\?\Volume{GUID} ayant le même

contenu que le \DosDevices\O: qu’on vient de modifier.

Chez moi ce n'était pas le cas. Si vous avez une telle

valeur, alors il faut lui donner le contenu de

\DosDevices\N: depuis le registre WinPE

- Dans

- Lancer

REGEDIT

et dans le registre HKEY_LOCAL_MACHINE monter la ruche

- Si en même temps que la migration on veut aussi passer du mode

SATA IDE vers AHCI alors il faut encore faire ceci. Cela a été

repris du site

tomshardware.co.uk

- Toujours dans

REGEDIT

avec la ruche montée en

HKEY_LOCAL_MACHINE\NewWin - Aller à

HKEY_LOCAL_MACHINE\NewWin\ControlSet000\Services\storahci\StartOverride - Changer la valeur DWORD de 3 à 0.

- Au redémarrage, si ça n'a pas été fait, changer la paramétrage du contrôleur SATA de IDE à AHCI. Au redémarrage, Windows devrait directement démarrer correctement et sans plantage (BSOD).

- Toujours dans

REGEDIT

avec la ruche montée en

- Rendre le disque bootable en installant les outils EFI de

microsoft et configurant le Magasin BCD (BCD Store)

- D'abord assigner une lettre de lecteur à la partition ESP

- MOUNTVOL S: /S

Si ca n'a pas fonctionné, faire comme ceci dans diskpart - list disk

- select disk # (# est le numero du SSD retourné par list disk)

- list partition

- select partition # (# est probablement 1)

- assign letter=S

- MOUNTVOL S: /S

- Puis lancer

bcdboot

N:\windows /l fr-fr /s S: /f UEFI- Où

N:\Windowsest le répertoire contenant le clone de Windows sur le SSD) - S: = partition EFI

- Où

- D'abord assigner une lettre de lecteur à la partition ESP

- Tout d'abord déterminer la lettre de lecteur affectée au clone

de Windows, celui qui est sur le SSD. Ou, s'il n'y a pas de

lettre affectée, lui en donner une, par exemple

- Redémarrer dans WinPE (en Mode UEFI, pas MBR !)

Redémarrer, et avant le lancement de Windows vérifier votre UEFI

(ou BIOS-UEFI). Il faut qu'il soit configuré pour démarrer par défaut

en mode UEFI et pas en mode BIOS. Penser aussi à corriger le

paramétrage SATA si cela a été modifié dans le registre de Windows.

Le paramétrage du démarrage avecbcdboot N:\windows /l fr-fr /s S: /f UEFIa normalement créé le

magasin BCD, mis tous les fichiers EFI sur la partition SYSTEME (ESP,

partiton EFI, la 1ère du SSD) et dit au firmware UEFI qu'il doit

automatiquement démarrer avec le gestionnaire de démarrage

(boot manager) de Windows.-

Une fois qu’on a réussi à démarrer dans la copie de Windows

- Réactiver le "FastBoot"

- Réactiver l'environnement de récupération de Windows

en lançant, depuis une ligne de commande avec les droits

administrateur, la commande

reagentc.exe /enable. Vérifier avecreagentc.exe /info. Et s'il y a une erreur essayer avecreagentc.exe /enable /setreimage /path C:\Recovery\WindowsREoùC:\Recovery\WindowsREest le dossier où se trouve le fichierWinre.wim - Vérifier que tout est en ordre. Eventuellement donner un nouveau

nom à votre partition

C:(pour la différencier de celle sur le HDD) en lançant:LABEL [drive:][label] - Redémarrer encore une fois en laissant le processus de démarrage se faire tout seul pour vérifier que tout est ok.

Réinsérer l'ancien disque dur.

Normalement, il devrait être possible de redémarrer dans l'ancien

Windows, du moment que vous savez comment booter en MBR, et sous

réserve de ne pas avoir modifié le mode SATA dans le UEFI/BIOS. SI

c'est le cas, vous pouvez envisager de modifier le registre du

Windows du HDD, ou de modifier le paramétrage du UEFI/BIOS.

Si vous avez aussi Linux d'installé sur le HDD, il devrait toujours

être possible de le démarrer en mode BIOSOn peut diminuer/augmenter la taille de la partition C: du SSD (Pour

un SSD TLC ou VNAND, on peut par exemple laisser de l’espace libre à

la fin ~10 % de la capacité du disque d'après le logiciel Samsung

Magician, pour un SSD 860 EVO)En principe, puisqu’on boot en EFI on peut enlever sur le clone

Windows sur le SSD les fichiers\bootmgret\Boot\BCDpuisque ce

sont ceux qui étaient utilisés pour un boot en mode BIOS/MBR et que

désormais on est en EFI. Vous pouvez d'abord les renommer et vérifier

que ca ne change rien au prochain boot, plutôt que de les supprimer

tout de suite.

Quelques pistes si ça ne fonctionne pas…

- Faire un chkdsk sur la nouvelle partition

- Recréer le bootsector du NTFS avec testdisk (dispo sur System Rescue CD, mais peut être aussi dans Clonezilla ? Je n'ai pas vérifié)

- Vérifier le BCD:

- On peut vérifier si le Magasin BCD est ok en lançant (en

tant qu'administrateur)

bcdedit /store s:\EFI\Boot\Microsoft\BCD /enum

(Si la partition système n'est pas montée sur S:, lancer

Mountvol s: /s

- Doc BCDEDIT (sur la page, il y a aussi les liens vers bcdboot (initialise BCD et copie fichiers de démarrage sur la partition systeme) et bootsect (pour basculer entre NTLDR et Bootmgr)

- https://msdn.microsoft.com/fr-fr/library/windows/hardware/mt450468(v=vs.85).aspx

- https://docs.microsoft.com/en-us/windows-hardware/manufacture/desktop/bcd-system-store-settings-for-uefi

- On peut vérifier si le Magasin BCD est ok en lançant (en

tant qu'administrateur)

bcdedit /store s:\EFI\Boot\Microsoft\BCD /enum

(Si la partition système n'est pas montée sur S:, lancer

Mountvol s: /s

- Vérifier que la partition EFI est bien initialisée (présence des

fichiers

\EFI,\EFI\Boot\,\EFI\Microsoft\…) Si ce n'est pas le cas, il y a eu un problème avec bcdbootN:\windows /l fr-fr /s S: /f UEFI - Vérifier le boot manager du bios (démarrage en UEFI ou MBR ? Gestionnaire de démarrage par défaut ? Présence du gestionnaire de démarrage de Windows ?)

- A priori, pas utile : Commandes à lancer dans WinPE

- Pour recréer le boot sector de la partition systeme (EFI):

bootrec

/fixboot - Pour chercher les OS sur le disque et les mettre dans le

bootloader

bootrec

/scanos

- Pour recréer le boot sector de la partition systeme (EFI):

bootrec

- Quelques commandes de bcdedit pour modiser la valeur de certains

éléments du magasin BCD. Inutile car le BCD Store qui est utilisé

lorsqu'on démarre en mode EFI n'est pas le même que celui utilisé

dans un démarrage en mode MBR. Donc, pas besoin de chercher à

modifier le BCD. Je garde pour info : les lettres sont celles telles

que définies dans le système où on est (WinPE par ex).

Doc BCDEDIT

- bcdedit /set {bootmgr} device \Device\HarddiskVolume1

- bcdedit /set {default} device \Device\HarddiskVolume3

- bcdedit /set {default} osdevice \Device\HarddiskVolume3

- Ou à la place de \Device\HarddiskVolume1 mettre les lettres de lecteur :

- bcdedit /set {bootmgr} device partition=S:

- bcdedit /set {default} device partition=C:

- bcdedit /set {default} osdevice partition=C:

Documentation, pour aller plus loin…

A propos du EFI/UEFI:

- La procédure de Boot en cas UEFI ou BIOS est bien décrite ici: https://www.boyans.net/RepairWindows/RepairWindowsBCD.html

- La partition Système EFI: https://wiki.archlinux.org/index.php/EFI\_System\_Partition

- Managing EFI Boot Loaders for Linux: http://www.rodsbooks.com/efi-bootloaders/principles.html

A propos de l'entrée MountedDevices du registre:

http://diddy.boot-land.net/firadisk/files/mounteddevices.htmSi on veut y accéder, par défaut les fichiers du BCD sont cachés. Pour

les rendre visibles:- attrib bcd -s -h -r

- mv bcd bcd.bak

- bootrec /rebuildbcd

Documentation bcdedit:

- http://diddy.boot-land.net/bcdedit/

- Concernant les valeurs possibles pour « device » ou « osdevice » dans bcdedit http://www.diddy.boot-land.net/bcdedit/files/device.htm

MBR Partition ID

- NB: Une partition Recovery Windows a un part_id de « 0x27 »: https://www.win.tue.nl/~aeb/partitions/partition\_types-1.html

A propos des disk ID (=Disk signatures):

- http://kb.macrium.com/KnowledgebaseArticle50152.aspx . En principe pas de pb, puisqu’on n’a pas cloné tout le disque mais juste une partition, et que le pb de signature du disque est lié à la copie du MBR (1er secteur du disque {et pas de la partition}). Cela concerne probabement aussi le clonage de la table de partition GPT puisqu'il y a aussi un id dedans…

- Fixing Disk Signature Collisions: https://blogs.technet.microsoft.com/markrussinovich/2011/11/06/fixing-disk-signature-collisions/

Si besoin de supprimer du registre les entrées de disques qui ne sont

pas connectés ou sans lettre assignée lancer:mountvol /R. Ce

programme permet aussi de lister les lettres de volumes avec leur GUID

(GUID pour ce système uniquement, il n’est pas stocké dans la partition,

ni ailleurs sur le disque, il est assigné par windows pour un couple

(signature de disque/partition offset) dans une instance de windows

alors que dans une autre instance de windows la même partition sur le

même disque aura ce GUID différent)Changer le label du volume: commande

LABEL [drive:][label]Historique de révisions

Vous trouverez la dernière version de ce tutoriel sur ma page perso

de tutoriels informatique.

Vous y trouverez aussi la version HTML, PDF et TXT.2018-06-17 : Ajout d'une note indiquant que ce tutoriel utilise des

logiciels libres2018-06-11 : Correction de la forme et de fautes d'orthographe

2018-05-28

Commentaires : voir le flux atom ouvrir dans le navigateur

-

Revue de presse de l'April pour la semaine 24 de l'année 2018

(Dépêches LinuxFR)

La revue de presse de l’April est régulièrement éditée par les membres de l’association. Elle couvre l’actualité de la presse en ligne, liée au logiciel libre. Il s’agit donc d’une sélection d’articles de presse et non de prises de position de l’Association de promotion et de défense du logiciel libre.

Sommaire

- [Numéro Magazine] Portrait de l’artiste en hackeur qui détourne les nouvelles technologies

- [France Culture] Que reste‐t‐il du logiciel libre ?

- [RFI] Software Heritage, la grande bibliothèque du logiciel

- [Numerama] Open source : qui sont les bons élèves et les cancres parmi les géants de la tech ?

- [BFMtv] Pourquoi les mèmes sur Internet sont en danger

- lien n°1 : April

- lien n°2 : Revue de presse de l’April

- lien n°3 : Revue de presse de la semaine précédente

[Numéro Magazine] Portrait de l’artiste en hackeur qui détourne les nouvelles technologies

Par Ingrid Luquet‐Gad, le jeudi 14 juin 2018. Extrait :« Algorithmes, codage, datas, hardware… comment les artistes détournent‐ils les nouvelles technologies ? C’est la question vertigineuse à laquelle répond une double exposition au centre Pompidou, avec l’artiste japonais Ryoji Ikeda en invité d’honneur. »

[France Culture] Que reste‐t‐il du logiciel libre ?

Par Hervé Gardette, le mercredi 13 juin 2018. Extrait :« Microsoft vient de racheter la plate‐forme de création collaborative de logiciels GitHub. Est‐ce vraiment une bonne nouvelle pour le logiciel libre ? Et quelles conséquences pour les utilisateurs ? La philosophie du libre a‐t‐elle gagné ou s’est‐elle fait manger ? »

Et aussi :

[RFI] Software Heritage, la grande bibliothèque du logiciel

Par Dominique Desaunay, le mercredi 13 juin 2018. Extrait :« La plupart des activités humaines dépendent exclusivement des programmes informatiques qui permettent, par exemple, aux internautes de consulter leurs réseaux sociaux ainsi que de surfer sur n’importe quelle page Web. Des logiciels fragiles qui contrairement aux hiéroglyphes gravés dans la pierre peuvent s’altérer avec le temps et disparaître à jamais. C’est la raison pour laquelle les informaticiens de l’Institut national de recherche en informatique et en automatique ont développé une immense bibliothèque en ligne dénommée Software Heritage. »

Et aussi :

- [les-infostrateges.com] Software Heritage : une bibliothèque au service de l’archive universelle des logiciels ;

- [Industrie et Technologies] Software Heritage : les logiciels ont leur bibliothèque d’Alexandrie.

[Numerama] Open source : qui sont les bons élèves et les cancres parmi les géants de la tech ?

Par Victoria Castro, le mardi 12 juin 2018. Extrait :« Tout le monde dit aimer l’open source, mais qu’en est‐il vraiment ? Nous avons dressé un classement de 6 géants de la tech, du plus grand sympathisant de l’ouverture au plus propriétaire d’entre eux. »

[BFMtv] Pourquoi les mèmes sur Internet sont en danger

Par Elsa Trujillo, le lundi 11 juin 2018. Extrait :« L’article 13 d’un projet de directive européenne sur le droit d’auteur entend limiter drastiquement la réutilisation de contenus protégés. »

Et aussi :

- [Usbek & Rica] Adieu mèmes et parodies ? Pourquoi « l’article 13 » menace Internet ;

- [RTL.fr] Un projet de loi européen voté le 20 juin va‐t‐il changer la face du Web ? ;

- [Konbini France] Les gifs et les mèmes sont‐ils en danger de mort ?.

Voir aussi :

- Sauvons le partage de code ! Appel à signature de la lettre ouverte « Save Code Share » ;

- Campagne « Save Your Internet » (agir avant le 20 juin 2018).

Commentaires : voir le flux atom ouvrir dans le navigateur

-

Tracim sera à l'honneur aux RPLL (dans le cadre des RMLL)

(Journaux LinuxFR)

Bonjour à toutes et tous,

Comme vous le savez sans doute, Saint-Étienne accueille dès samedi les Rencontres Mondiales du Logiciel Libre 2017. Mais comme vous ne le savez peut-être pas, les mardi 4 et mercredi 5 juillet se tiendront au même endroit les Rencontres Professionnelles du Logiciel Libre.

Tracim, logiciel libre pour la mise en place d'extranet professionnels, dont j'ai déjà parlé à plusieurs reprises dans les colonnes de LinuxFR, sera mis à l'honneur par la société algoo (dont je suis le dirigeant).

Mercredi 5 juillet de 10h à 10h40, j'animerai un atelier intitulé : « Venez découvrir Tracim, le logiciel libre d'extranet professionnel développé par algoo, à travers quelques cas client. »

En attendant Tracim 1.0 prévue pour septembre 2017 — et la dépêche LinuxFR qui accompagnera bien évidemment cette sortie, cet atelier sera l'occasion de découvrir des cas d'utilisation réels, de se faire une idée de la mouture à venir de Tracim, ou tout simplement de se rencontrer.

A noter que la société algoo aura un stand aux RPLL : celles et ceux qui rodent sur LinuxFR et qui me connaissent à travers mes interventions virtuelles, n'hésitez pas à passer sur le stand algoo : ce sera l'occasion mutuelle de mettre (enfin!) des visages sur tous ces avatars :)

Note : le stand algoo et l'atelier tracim sont dans le cadre des RPLL et non des RMLL (c'est le bâtiment d'à côté si j'ai bien compris)

-

PyConFR 2018, du 4 au 7 octobre à Lille : appel à contributions

(Dépêches LinuxFR)

La PyConFR, c’est le rassemblement annuel francophone de passionnés et curieux du langage Python. Cette année, on invite la communauté à se retrouver à Lille du 4 au 7 octobre.

Pour ceux qui ne connaissent pas la formule, les deux premiers jours (jeudi et vendredi) sont dédiés à des sprints (hackathons), et le week‐end sera rempli de conférences et d’ateliers découverte.

Contribuez à cette édition et aidez‐nous à la rendre mémorable en proposant du contenu : conférences, ateliers, sprints !

Quelques idées de sujets : enseignement du langage, montée en charge (scaling), sécurité, science des données, apprentissage automatique (machine learning), retour d’expérience, empaquetage, présentation d’une bibliothèque, Internet des objets (IoT), asynchrone, communauté, diversité, pyre-check, 2to3, PyPy, Python vs Go, intégration et livraison continues (CI/CD), stockage de données, agents conversationnels (chatbots), Python magic, Ansible vs SaltStack et tellement d’autres…

- lien n°1 : PyConFR 2018

- lien n°2 : AFPy

- lien n°3 : L’appel à proposition

- lien n°4 : Soumettre une proposition

- lien n°5 : Suivez‐nous sur Twitter

- lien n°6 : Meetup Python Lille

- lien n°7 : Martine découvre Python

Commentaires : voir le flux atom ouvrir dans le navigateur

-

Tutoriel Code_Aster

(Dépêches LinuxFR)

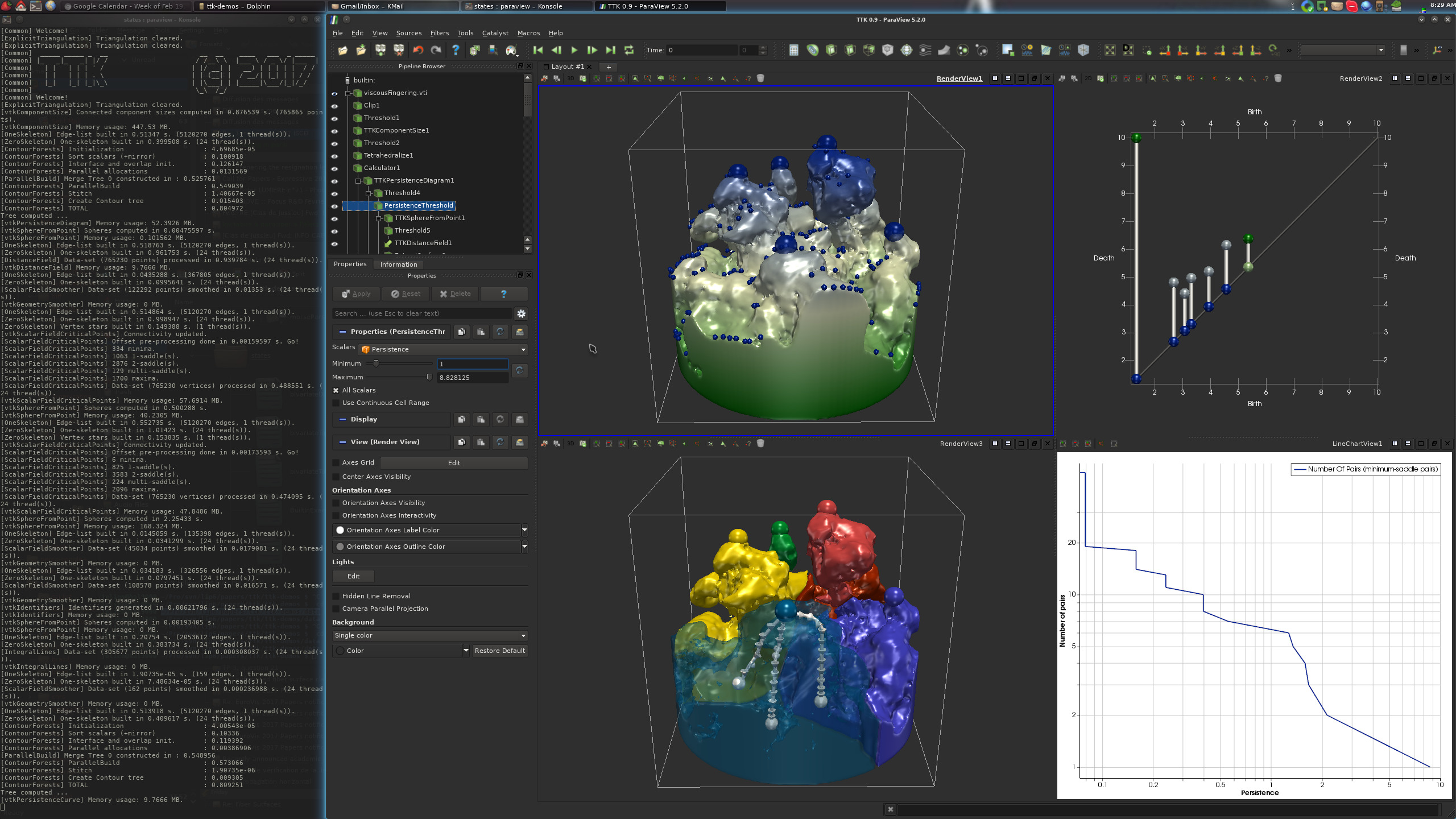

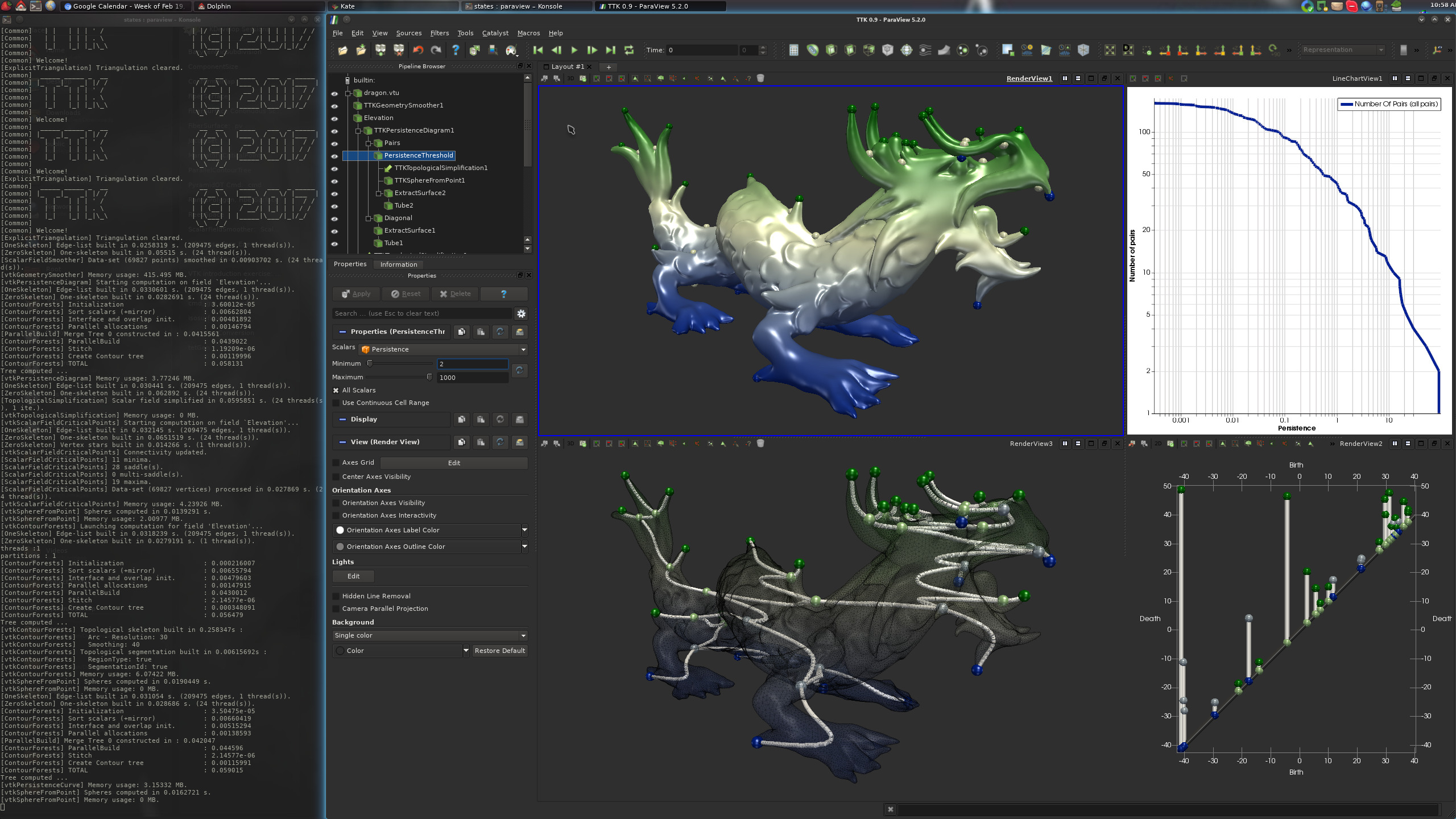

Une fois n’est pas coutume, il pleut en Haute‐Garonne ! Alors j’ai tué le temps jetant un œil à Code_Aster, qui est un code de calcul de structure thermomécanique par la méthode des éléments finis isoparamétriques. Il est développé par EDF sous licence GNU GPL v3. Il permet de faire à peu près tout ce qui est imaginable en mécanique, voir à ce propos la plaquette de présentation (PDF).

Ce code de calcul est intégré à la suite de logiciels libres Salomé‐Méca, qui contient un préprocesseur, Code_Aster, et un post‐processeur/visionneur pour voir les résultats. Aujourd’hui, nous allons utiliser le code en version autonome (stand alone) et nous utiliserons notre éditeur de texte préféré, gmsh, astk, puis de nouveau gmsh pour voir les résultats de nos calculs.

- lien n°1 : Journal à l’origine de la dépêche

- lien n°2 : Code Aster, sur Wikipédia

- lien n°3 : Code Aster, site officiel

Sommaire

Installation

Cela se passe ici. Deux options :

- soit on compile code_aster ;

- soit on n’aime pas compiler et l’on télécharge le binaire de Salomé‐Méca qui contient Code_Aster de façon préinstallé et quelques Gio d’outils dont nous ne nous servirons pas.

La compilation se passe assez bien, et les paquets prérequis (voir les instructions de compilation sur leur site) se trouvent assez facilement.

Calcul de poutre

Nous allons étudier le comportement mécanique d’une poutre encastrée d’un côté et soumise à un effort ponctuel de l’autre côté :

Nous allons le faire de trois façons :

- En modélisation poutre 1D ;

- En modélisation plaque 2D ;

- En modélisation complète 3D.

Création de la géométrie avec Gmsh

Pour fonctionner, Code_Aster a besoin d’un fichier de commandes, et d’un fichier décrivant un maillage : une liste de nœuds et une liste d’éléments reliant ces nœuds. On pourrait lui fournir un fichier texte contenant les coordonnées géométriques de chaque nœud du maillage, mais vu qu’on a la flemme et que cela peut être assez ennuyeux pour des problèmes complexes, on va demander à Gmsh de le faire pour nous.

On crée tout d’abord la géométrie de notre problème à l’aide de points, de lignes, surfaces et volumes, on doit aussi définir des groupes d’intérêts (la poutre entière, la partie encastrée et la partie sur laquelle on applique la force). On peut jouer cinq minutes avec la partie interface graphique de Gmsh, pour lequel on trouvera de nombreux tutoriaux sur le Web, mais on en revient vite à un fichier texte.

Voici donc

poutre1d.geo://== paramètres == //taille maillage autour des nœuds. 2,5 mm entre deux nœuds. cl__1 = 2.5; // == géométrie == //points Point(1) = {0,0, 0, cl__1}; // extrémité encastre de ma poutre Point(2) = {100,0, 0, cl__1}; // extrémité libre de ma poutre, soumise à une force //lignes Line(1) = {1, 2}; // on crée la ligne entre Point1 et Point2 //== groupe == Physical Point("encastr") = {1}; // on encastrera le nœud correspondant à ce point Physical Point("force") = {2}; //on appliquera la force sur le nœud correspondant à ce point Physical Line ("poutre") = {1}; // notre poutre sera constituée de tous les nœuds et éléments correspondant à cette ligneUne fois ce fichier

poutre1d.geocréé, on l’ouvre avec gmsh (terminal :gmsh poutre1d.geo). On clique sur Mesh → 1D, le maillage est fait, mais on ne le voit pas, car seule la géométrie est affichée ! Donc, Tools → Options, onglet Visibily de Geometry, on décoche Points et Lines, et dans Mesh, on coche Nodes et Lines. Cela donne ceci :

Notez qu’avec Tools → Options, dans l’onglet list bowser, on peut visualiser ou masquer (taper la touche

Entréeau clavier après avoir cliqué sur le nom du groupe dans la fenêtre) les groupes que nous avons créés et leurs affectations. C’est très pratique. On voit par exemple bien que notre groupe « poutre » est constitué de tous les éléments de la poutre.Pour sauvegarder notre maillage, on fait File → Export et l’on choisit le format de maillage appelé

.MED, on obtient donc un beaumesh1d.med. Surtout, on veille à ce que tout soit décoché dans la fenêtre surgissante qui apparaît et l’on clique rapidement sur OK.De même, voici poutre2d.geo, qu'on maille en 2D avec gmsh:

//== paramètres: == //taille maillage autour des nœuds. 2,5 mm entre deux nœuds. cl__1 = 2.5; L=100; //longueur poutre de 100 mm R=5; // ratio longueur/largeur l=L/R; //== géométrie == //points Point(1) = {0, 0, 0, cl__1}; Point(2) = {L, 0, 0, cl__1}; Point(3) = {L, l, 0, cl__1}; Point(4) = {0, l, 0, cl__1}; Point(5) = {L, l/2, 0, cl__1}; //lignes Line(1) = {1, 2}; Line(2) = {2, 5}; Line(3) = {5, 3}; Line(4) = {3, 4}; Line(5) = {4, 1}; //surface Line Loop(1) = {1, 2, 3, 4, 5}; //on crée une boucle de lignes Plane Surface(1) = {1}; // on crée une surface à partir de la boucle //== groupe == Physical Line("encastr") = {5}; // on encastrera cette ligne Physical Point("force") = {5}; // lieu application force Physical Surface("poutre") = {1}; // notre poutre 2D

Et

poutre3d.geoqu’on maille en 3D avec gmsh ://== paramètres: == //taille maillage autour des nœuds. cl__1 = 5; L=100; // longueur poutre R=5; // ratio longueur/largeur l=L/5; //== géométrie == //points Point(1) = {0,0, 0, cl__1}; Point(2) = {L,0, 0, cl__1}; Point(3) = {L,l, 0, cl__1}; Point(4) = {0,l, 0, cl__1}; Point(5) = {L, l/2, 0, cl__1}; //lignes Line(1) = {1, 2}; Line(2) = {2, 3}; Line(3) = {3, 4}; Line(4) = {4, 1}; //surface Line Loop(1) = {1, 2, 3, 4}; Plane Surface(1) = {1}; Point{5} In Surface{1}; // pour que le point 5 soit contenu dans la surface //volume Extrude {0,0,-3}{Surface{1};Layers{3}; Recombine;} //on extrude la surface 1 de -3 mm selon l’axe Z //en créant 3 éléments dans l’épaisseur avec l’aide de calques //== groupe == //on sait que c’est la surface 25 parce qu’on le visualise sous gmsh en affichant « surface label ». //il peut y avoir une erreur lors de l’importation si le numéro de la surface créée par l’extrusion n’est pas 25. // C’est pas grave, on regarde à quoi correspond la surface à encastrer, on trouve son label, et mon modifie les lignes ci-dessous. Physical Surface("encastr") = {25}; // on encastrera cette surface Physical Point("force") = {5}; // lieu application force Physical Volume("poutre") = {1}; // notre poutre 3D //== maillage == Transfinite Line{1,3}=8*R+1; // 8*R élém dans la longueur = 41 nœuds entre lignes 1 et 3 Transfinite Line{4,2}=8+1; // 8 élém dans la largeur = 9 nœuds entre lignes 4 et 2 Transfinite Surface "*"; // on veut un maillage propre Recombine Surface "*"; // on veut un maillage quadra

Nous voici maintenant avec trois maillages au format

.med. Il nous faut maintenant créer notre fichier de commandes !Fichier de commandes

#U1.03.02 DEBUT(); #on charge le fichier de maillage .MED, unité logique 20 mesh=LIRE_MAILLAGE( INFO=2, INFO_MED=2, UNITE=20, FORMAT='MED', ); #on a importé le maillage et ses groupes, on crée d'autres groupes: mesh=DEFI_GROUP( reuse =mesh, INFO=2, MAILLAGE=mesh, #on crée un groupe nommé TOUT qui contient toutes les mailles du maillage. #on ne va pas s'en servir, mais ça peut être utile CREA_GROUP_MA=_F(NOM='TOUT',TOUT='OUI',), #on crée un groupe de nœuds qui contient tous les nœuds de toutes les mailles. # Il faut le faire quand le maillage provient de Gmsh, car Gmsh transforme les nœuds en maille, on les retransforme ici en nœuds CREA_GROUP_NO=_F(TOUT_GROUP_MA='OUI',), ); #on affecte au groupe de mailles 'poutre' créé avec gmsh, # des éléments finis de types Poutre, ici POU_D_T model=AFFE_MODELE( MAILLAGE=mesh, AFFE=( _F( GROUP_MA=('poutre',), PHENOMENE='MECANIQUE', MODELISATION='POU_D_T', ), ), ); #on définit un matériaux, ici de l''acier: # Module d'Young' E = 210000 N/mm2 # Coefficient de Poisson, nu = 0.3 # masse volumique = 8e-9 tonne/mm3 steel=DEFI_MATERIAU(ELAS=_F(E=210000.,NU=0.3,RHO=8e-9),); #U4.43.03 #on assigne notre matériaux à nos mailles du groupe 'poutre' material=AFFE_MATERIAU( MAILLAGE=mesh, AFFE=_F(GROUP_MA=('poutre',), MATER=steel,), ); #U4.42.01 #On assigne à nos éléments poutre POU_D_T une section rectangulaire de largeur 20 mm et d’épaisseur 3 mm elemcar=AFFE_CARA_ELEM( MODELE=model, INFO=2, POUTRE=( _F( GROUP_MA=('poutre',), SECTION='RECTANGLE', CARA=('HY','HZ',), VALE=(3,20), ), ), ); #on interdit toute rotation et translation aux nœuds du groupe 'encastr' (1 seul nœud ici). # cela simule l'encastrement encast=AFFE_CHAR_MECA( MODELE=model, DDL_IMPO=( _F( GROUP_NO=('encastr',), DX=0,DY=0,DZ=0,DRX=0,DRY=0,DRZ=0, ), ), INFO=1, ); # on applique 500 N selon la direction -Z au nœud de notre groupe 'force' force_f=AFFE_CHAR_MECA( MODELE=model, FORCE_NODALE=_F( GROUP_NO=('force',), FZ=-500, ), INFO=2, ); #U4.51.01 #on compile les précédents concepts pour le calcul stat=MECA_STATIQUE( MODELE=model, CHAM_MATER=material, CARA_ELEM=elemcar, EXCIT=( _F(CHARGE=encast,), _F(CHARGE=force_f,), ), ); # Par défaut, sont calculés uniquement les déplacements et les réactions nodales aux points de Gauss des éléments, je crois. # du coup on enrichit le concept "stat" pour lui demander d'autres choses. # SIEF_ELNO: ici, efforts théorie des poutres au niveau des nœuds des éléments # SIPO_ELNO: ici, contraintes dans la poutre, au niveau des nœuds des éléments # SIPM_ELNO: ici, contrainte max dans la poutre # REAC_NODA: forces/moments aux nœuds limites stat=CALC_CHAMP( reuse =stat, RESULTAT=stat, CONTRAINTE=( 'SIEF_ELNO','SIPO_ELNO','SIPM_ELNO', ), FORCE=('REAC_NODA',), ); #on imprime ça dans un fichier de sortie .med, unité logique 80. #on n'imprime que les déplacements et les contraintes # (on n'affiche pas tout ce qu'on a calculé, genre SIPM_ELNO ou REAC_NODA pourquoi pas !) IMPR_RESU( FORMAT='MED', UNITE=80, RESU=_F( RESULTAT=stat, NOM_CHAM=( 'DEPL', 'SIPO_ELNO', 'SIPM_ELNO', ), ), ); FIN();Notez que les #U4.51.01 ou autres renvoient à la documentation.

On enregistre ce fichier texte en1d.comm, par exemple, et nous allons lancer le calcul à l’aider d’astk.Astk

Astk est l’outil permettant de mener à bien un calcul, on le lance via

/opt/code_aster/bin/astk(si vous avez installé Code_Aster dans/opt).On cherche à obtenir une fenêtre qui a cette allure :

Ensuite :

- File → New ;

- on choisit notre dossier de travail (path) ;

- dans la colonne d’icônes au milieu à droite, on clique sur l’icône en forme de dossier bleu, pour aller chercher son

mesh1d.medet son1d.comm; - on clique sur l’icône du dessus pour ajouter deux lignes, puis dans type pour la ligne, on choisit mess et rmed, dans name on les appelle

./log1d.messet./resu1d.rmed; File → Save_As →

1d.astk.File -> New

on choisit notre path / dossier de travail

dans la colonne d'icônes au milieu à droite, on clique sur l’icône en forme de dossier bleu, pour aller chercher son mesh1d.med et son 1d.comm

on clique sur l’icône du dessus pour ajouter deux lignes, puis dans type pour la ligne, on choisit mess et rmed, dans name on les appels ./log1d.mess et ./resu1d.rmed

File -> Save_As -> 1d.astk

La colonne LU correspond à Logical Unit ou Unité Logique, c’est l’endroit de la mémoire où je ne sais quoi où l’on s’attend à trouver le fichier ; dans

fichier.comm, on a précisé que l’unité logique était 20 pour le maillage.medet 80 pour le résultat.med. Les colonnes DRC veulent dire Données, Résultats, Compressé.Une fois que cela est fait on clique sur Run ! Le calcul est lancé. Il se termine, on va voir le

log1d.messqui a été créé, il contient toutes les infos relatives au calcul. L’information la plus importante étant la dernière ligne.Chez moi j’ai :

EXECUTION_CODE_ASTER_EXIT_13223-localhost=0. Si le code renvoie 0, c’est que cela a fonctionné ! S’il renvoie 1, c’est que ça a planté et qu’il faut déboguer…Résultat

Normalement tout a fonctionné, nous avons un beau

resu1d.rmedque nous ouvrons avec gmsh (terminalgmsh resu1d.rmed).On peut donc voir les déplacements et la contrainte, tout ce dont a besoin un mécanicien pour dimensionner des systèmes mécaniques !

Voici les paramètres sur lesquels agir pour afficher le déplacement multiplié par 10. Il faut afficher des Vectors et non pas l’Original Field. Comme ci‐dessous :

Pour les contraintes, SIPO_ELNO contient la contribution de chaque force ou moment aux contraintes de la poutre.

C’est grosso modo un vecteur de six composantes que voici :

Pour les afficher une par une, on se place dans Options → Visibility et, en bas, la première case à droite de la liste déroulante Original Field/Scalar Force/Vector/Tensor. Zéro correspond à SN et cinq correspond à SNT, par rapport au tableau ci‐dessus (je ne sais pas trop ce que présente SIPO_ELNO par défaut).

SIPM_ELNO, quant à lui, représente par défaut la contrainte maximum selon XX.

Voici d’autres visualisations avec les modèles 2D et 3D :

Aller plus loin