Linux (fr)

-

Les sources de données système sous Linux avec NSS

(Laboratoire Linux SUPINFO)

Les sources de données système sous Linux avec NSS

Note: ce document est le premier d'un cycle de trois articles sur l'authentification sur les systèmes Linux. Les suivants se trouvant ici et là.

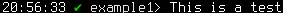

On utilise souvent la commande cat

/etc/passwdpour connaitre la liste des utilisateurs d'un système Linux. Bien que le résultat renvoyé soit correct dans la grande majorité des cas, ce n'est pas la méthode que l'on devrait utiliser. En effet l'affichage du fichier/etc/passwdrenvoie la liste des utilisateurs locaux uniquement. Mais si le système est relié à un serveur LDAP, les utilisateurs de ce serveur n’apparaîtront pas, bien qu'il soit possible de se connecter avec sur la machine.Name Service Switch

La bonne méthode pour afficher la liste des utilisateurs est l'utilisation de la commande

getentsuivie du paramètrepasswd. Celle-ci va interroger les différentes sources d'utilisateurs définies pour le système. Ces sources sont gérées par le mécanisme NSS (pour « Name Service Switch »). Et NSS ne s'occupe pas seulement des sources d'utilisateurs, mais aussi de leurs mots de passe, des groupes d'utilisateurs, des noms d'hôtes, des protocoles et services connus du système, etc.Cependant, bien que NSS permette de choisir les sources de données depuis lesquelles le système ira chercher les informations dont il a besoin, ce n'est pas lui qui défini les connexions vers ces sources de données.

Voici la liste des bases de données (présentes habituellement sous la forme de fichiers plats) que l'on a l'habitude d'interroger en général et que NSS est capable de gérer :

Bases de données Description Fichier correspondant aliases Alias des adresses e-mail /etc/aliases ethers Numéros Ethernet /etc/ethers group Groupes d'utilisateurs pour l'accès aux fichiers /etc/group hosts Correspondances entre les noms d'hôtes et les adresses IP /etc/hosts netgroup Groupes d'utilisateurs pour l'accès aux ressources réseau /etc/netgroup networks Noms et masques de réseau /etc/networks passwd Utilisateurs système /etc/passwd publickey Clés publiques utilisées par NFS et NIS+ /etc/publickey rpc Correspondances entre les noms et les numéros de RPC connus /etc/rpc services Correspondances entres les numéros de ports et les services réseau connus /etc/services shadow Mots de passes chiffrés des utilisateurs /etc/shadow Ces bases de données ne sont pas utilisées sur tous les systèmes, comme par exemple les

aliasesplutôt réservés aux serveurs mail, mais on retrouve les bases standard commepasswd,shadowougroup.Pour chacune de ces bases de données on va pouvoir demander à NSS d'interroger les fichiers plats locaux listés ci-dessus ainsi que diverses sources externes. Par exemple pour les noms d'hôtes, on va pouvoir configurer NSS pour interroger le fichier

/etc/hostspuis les serveurs DNS.Le fichier nsswitch.conf

La configuration de l'ordre d'interrogation des sources se fait très simplement à l'aide du fichier

/etc/nsswitch.conf. Voici un fichier d'exemple issue d'un système Ubuntu :passwd: compat group: compat shadow: compat hosts: files mdns4_minimal [NOTFOUND=return] dns mdns4 networks: files protocols: db files services: db files ethers: db files rpc: db files netgroup: nis

Sur chaque ligne de celui-ci, est décrit une base de données et les sources depuis lesquelles on va chercher ces données. Chaque ligne aura donc cette forme :

base_de_données: source1 [STATUT=action] source2 source3

NSS ira interroger chaque source une par une dans l'ordre dans lesquelles elles sont inscrites. Chaque interrogation d'une source renverra un statut parmi ceux listés ci-dessous et sera suivie par l'action par défaut :

Statut Description Action par défaut success Succès de la récupération de la donnée recherchée. return notfound Accès au service de donnée réussi mais donnée non trouvée. continue unavail Le service est indisponible de manière permanente. Cela peut indiquer que le fichier nécessaire n'est pas lisible, ou, pour les services réseau, que le serveur n'est pas disponible ou n'accepte pas les requêtes. continue tryagain Le service est temporairement indisponible. Cela signifie qu'un fichier est verrouillé, et qu'un serveur ne peut pas actuellement accepter davantage de connexions. continue Il est possible de demander à arrêter ou continuer le processus entre deux sources suivant ce statut grâce à une mention du type

[STATUT=action]. Cela permet d'exécuter l'action de son choix et non celle par défaut.L'action peut être l'une des deux suivantes :

- return : s'arrêter ici et renvoyer les résultats trouvés

- continue : interroger le service suivant

Les sources de données disponibles

Pour obtenir les données recherchées, on peut interroger différents services locaux ou distant comme par exemple les fichiers plats, un annuaire LDAP, une base de données SQL, etc. Par défaut les services disponibles sont

files,db,nisetnisplusainsi quecompatpour les basespasswd,groupetshadow. De plus, la base donnéeshostsdispose de la sourcednsqui n'est utilisable que sur elle.Mais pour se connecter à des services plus évolués il faut disposer des bons modules. Ceux-ci se trouvent le plus souvent dans le répertoire

/libet ont un nom de la formelibnss_XXX.so.Y. AvecXXXpour le nom du service etYle numéro de version de la glibc dans laquelle il s'intègre. Ces modules sont en grande partie installables depuis le gestionnaire de paquet de votre distribution.Et en voici une liste des plus courants :

Nom du module Description files Utiliser les fichiers plats du système local. compat Similaire à filesmais permet en plus d'utiliser un annuaire NIS inclus directement dans les fichierspasswd,groupsetshadowet non dans le fichiernsswitch.conf. Pour plus d'informations, voir le lien correspondant à la fin de cet article.db Utiliser les fichiers au format Berkeley Database File. nis Connexion à un annuaire NIS (ancêtre de LDAP). nisplus Connexion à un annuaire NIS+ (version plus sécurisée de NIS). dns Connexion aux DNS. Utilisable seulement pour la base de données hosts.mdns Résolution en Multicast-DNS. Utilisable seulement pour la base de données hosts.ldap Connexion à un serveur LDAP winbind Connexion à un serveur Samba (ou Active Directory). cache Utilisation des fichiers de cache des noms de domaines de nscd(Name Service Cache Daemon).extrausers Utilisation des fichiers passwd,groupetshadowsitués dans le dossier/var/lib/extrausers. Ce dossier permet d'accueillir les fichiers précédemment cités venant d'autres systèmes sans copier leur contenu dans les fichiers locaux situés dans/etc.sshsock2 Connexion à un autre système via un socket ssh afin d'utiliser les utilisateurs de celui-ci. Valable seulement pour les bases de données passwdetgroup.lwres Lire le cache fournit par lwres (lightweight resolver). Utilisable seulement pour la base de donnnées hosts.mysql-bg Utilisation d'une base de données MySQL. pgsql2 Interrogation d'une base de données PostgreSQL. sss Interrogation d'un démon SSSd. La commande getent

La commande

getentcitée au début de cet article permet quand à elle d'effectuer une requête pour une base de données sur les services inclus dans NSS.La commande est de la forme suivante :

getent base_de_données [clé]

La

base_de_donnéesest un nom parmi ceux listés dans le premier tableau de cet article. Laclén'est, elle, pas obligatoire. Si elle est présente, la commande n'affichera que la ligne concernant le nom recherché. Au contraire, si elle est absente,getentlistera tous les éléments lorsque la base permet l'énumération.Par exemple, un annuaire LDAP permet l'énumération, et s'il est utilisé pour l'authentification sur votre système, vous pourrez lister tous les utilisateurs disponibles. À l'inverse, les services DNS ne permettent pas l'énumération (il est impossible de lister tous les noms de domaines existants) et vous serez obligés de fournir une clé (ici un nom de domaine) pour avoir son adresse IP correspondante.

Conclusion

On l'a vu au travers de cette article, NSS est un mécanisme qui nous permet de choisir les sources de données nécessaires au système. Il permet d'utiliser les fichiers locaux ou de déléguer la gestion de ces données à des services externes. Il est donc nécessaire lors de l'intégration d'une machine à un système centralisé.

Ressources supplémentaires

- La page de manuel nsswitch.conf :

http://manpagesfr.free.fr/man/man5/nsswitch.conf.5.html - La page française de Wikipédia sur NSS :

https://fr.wikipedia.org/wiki/Name_Service_Switch - La page de manuel de getent :

http://man.cx/getent%281%29/fr - Plus d'informations sur la source de données compat :

http://serverfault.com/questions/331440/what-do-compat-mean-in-name-service-switch

-

darktable 2.4.0

(Dépêches LinuxFR)

Le logiciel de développement d’images brutes darktable est sorti en version 2.4.0. Comme chaque année, la liste des changements est considérable : près de 3 000 commits sur darktable et la bibliothèque rawspeed sous-jacente, 244 pull‐requests traitées et plus de 320 bogues fermés.

Dans les nouveautés majeures, on trouve la prise en charge de Windows (introduite dans une section « Hell Froze Over », « l’enfer a gelé », dans les notes de sorties officielles !), un nouveau module « suppression de la brume », et un nouveau mode « filtre laplacien local » dans « contraste local » qui permet non seulement de jouer sur le contraste local, mais aussi de traiter les ombres et lumières avec un rendu très propre et sans halos.

Comme d’habitude, pensez à faire une sauvegarde de votre base de données (répertoire

~/.config/darktable) : les anciennes versions de darktable ne pourront pas ouvrir les images traitées avec la 2.4.Quelques rappels sur ce que permet de faire darktable, et surtout, les détails des nouveautés dans la suite de la dépêche.

- lien n°1 : darktable 2.2.0 sur LinuxFr.org

- lien n°2 : darktable 2.0.0 sur LinuxFr.org

- lien n°3 : darktable 1.6.0 sur LinuxFr.org

- lien n°4 : Communauté francophone darktable : darktable.fr

- lien n°5 : Site officiel de darktable

- lien n°6 : raw.pixls.us, le remplaçant de rawsamples.ch

- lien n°7 : Visualisation gource (vidéo) de l’historique de développement entre la 2.2 et la 2.4

- lien n°8 : Les notes de sortie officielles sur GitHub

Sommaire

- Introduction

- Changements majeurs

-

Des petits détails qui peuvent changer la vie

- Possibilité de choisir la couleur de fond de l’interface via CSS

- Curseur « biais d’exposition » dans le mode « fusion d’exposition » du module « courbe de base »

- Amélioration de la fonction « annuler » en chambre noire

- Une brosse transparente

- Mode « absolu » dans la table de correspondance des couleurs

- Profils OpenCL

- Autres changements

- Prise en charge de nouveaux boîtiers et types d’images

- Nouveau site darktable.org

- Nouvelle collection d’échantillons de fichiers RAW

- Et après ?

Introduction

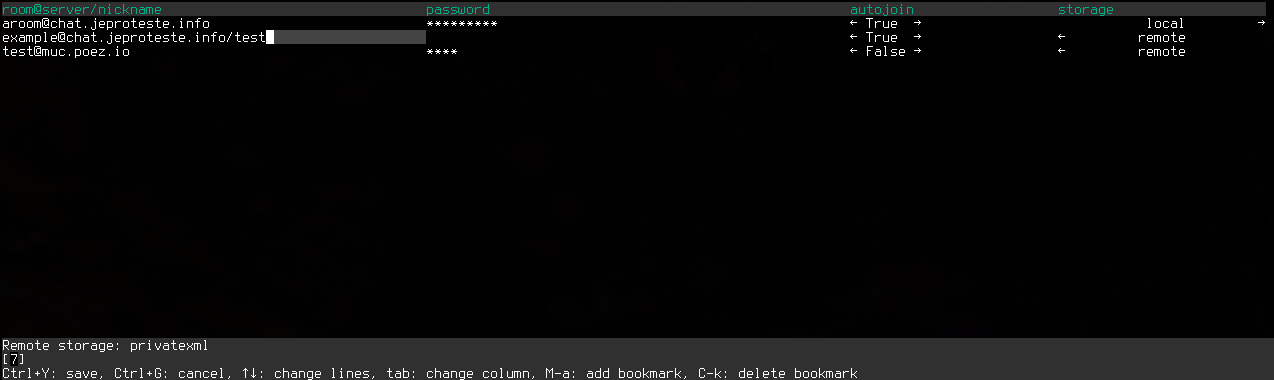

Darktable est un logiciel libre développé depuis 2009 par Johannes Hanika, puis Tobias Ellinghaus et désormais 215 contributeurs, auteurs de 20 191 commits à ce jour. Il s’agit d’un logiciel de catalogage et de développement de photos brutes de capteur (RAW), basé sur Rawspeed, qui embarque une gestion complète de la colorimétrie (profils d’entrée, de sortie et d’écran, softproofing et visualisation du gamut), ainsi que la gestion de nombreux formats RAW (plus de 550 boîtiers gérés, dont les capteurs Fuji X-Trans et Leica Monochrome), la correction des déformations optiques via la bibliothèque Lensfun (902 objectifs gérés), et le calcul sur processeur graphique via OpenCL.

Au fil du temps, il s’est doté de fonctionnalités périphériques, comme la possibilité de générer ses propres profils de couleur cLUT à partir de mires (type ColorChecker) ou de JPG boîtier, de scripter des modules d’import‐export avancés en Lua (par exemple, fusion HDR via Enfuse, exportation vers Hugin, création automatique de planches‐contacts et de diaporamas). Il comporte aussi un module d’impression permettant d’appliquer des profils de couleur, pour les imprimantes prises en charge par CUPS. Il est également interfaçable avec GIMP en tant que greffon. Peu à peu, il s’enrichit de fonctions qui relèvent davantage de la retouche non destructive que du simple développement de « négatifs » numériques (voir plus bas).

Souvent comparé à Adobe Lightroom en raison des similitudes de l’interface, il s’en distingue par :

- la possibilité de créer des masques complexes (paramétriques et/ou dessinés, avec opérations booléennes) afin de restreindre la zone d’application des modules ;

- la possibilité native d’émuler le rendu couleur de la pellicule ou les JPG boîtier ;

- la possibilité de dupliquer, cloner ou empiler la plupart des modules ;

- la gestion native du HDR et de la correspondance des tonalités (à partir d’une ou de plusieurs photos) et la prise en charge en entrée et sortie de formats d’images échantillonnés jusqu’à 32 bits par canal ;

- une approche souvent plus « bare‐metal », avec des options plus proches de l’algorithmique sous‐jacente et parfois moins intuitives ;

- une communauté de développeurs où la présence significative d’universitaires garantit l’ajout régulier d’algorithmes issus de la recherche récente.

Fait rare pour un « dérawtiseur », il comporte également un module Liquéfier, qui permet de déplacer des pixels de la même manière que le filtre Fluidité de Photoshop, mais de façon non destructive, en entrant les vecteurs. Son usage est cependant un peu plus complexe et moins réactif que la version Photoshop, qui n’agit pas sur les données brutes.

Sous le capot, darktable est codé en C/C++ avec la bibliothèque graphique GTK 3 pour l’interface et publié sous licence GNU GPL v3. Il effectue le traitement interne des images avec des nombres à virgule flottante sur 32 bits.

Changements majeurs

Nouveau module « suppression de la brume » (haze removal)

Les photos de paysages sont souvent pâlies par un voile atmosphérique ou de la brume. Parfois, cette brume participe à l’ambiance et l’on peut vouloir l’exploiter dans le traitement, mais on peut aussi vouloir l’éliminer ou au moins l’adoucir. Vu que la brume désature l’image et lui enlève du contraste, les ingrédients pour retrouver manuellement une image bien équilibrée sont « contraste local » (ou « renforcer la netteté » avec un rayon très grand : faire un clic droit sur le curseur de rayon et entrer au clavier par exemple 20, pour dépasser le rayon maximum du curseur) et le curseur de saturation de « contraste lum. saturation ». Le voile atmosphérique ajoute souvent un peu de bleu, en particulier sur les tons sombres, ce qu’on peut rectifier avec le module « balance des couleurs ». Voir par exemple le tutoriel darktable Voile atmosphérique de Jean‐Pierre Verrue.

Ces traitements manuels posent deux problèmes : d’une part, il faut souvent combiner plusieurs modules et donc passer relativement longtemps sur chaque image et, d’autre part, les paysages brumeux sont souvent composés de plusieurs plans, de plus en plus atteints par la brume au fur et à mesure qu’on s’éloigne du photographe. Inutile de tenter de retrouver du contraste dans un arrière‐plan totalement gris (on ne ferait qu’amplifier les artefacts de l’image), mais masquer les effets sur le premier plan n’est pas forcément évident non plus. C’est là qu’intervient le nouveau module suppression de la brume de cette nouvelle version, écrit par Heiko Bauke sur la base d’un article de chercheurs de l’université de Hong‐Kong.

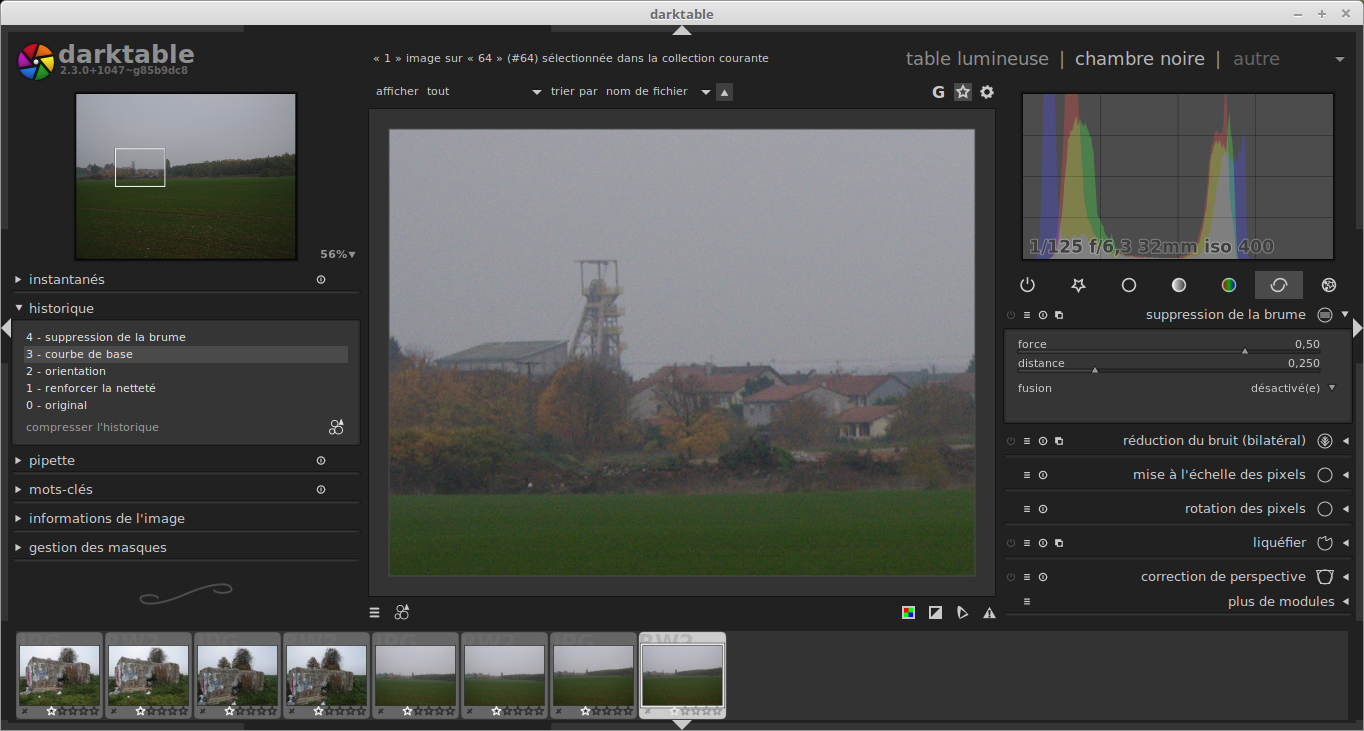

Le module se trouve dans l’onglet modules d’amélioration :

Il a deux curseurs :

- la force permet de contrôler le voile atmosphérique (plus on l’augmente, plus le bruit devient important) ;

- la distance permet d’agir plus ou moins sur les différents plans de la photo.

Voici le résultat sur une photo, extraite d’une série prise pour tester les algorithmes de suppression de brume :

Et après l’activation de la « suppression de la brume » avec les paramètres par défaut :

Aucune autre correction que celles faites par darktable à l’ouverture d’un fichier RAW n’a été faite sur cet exemple, comme on peut le voir dans l’historique.

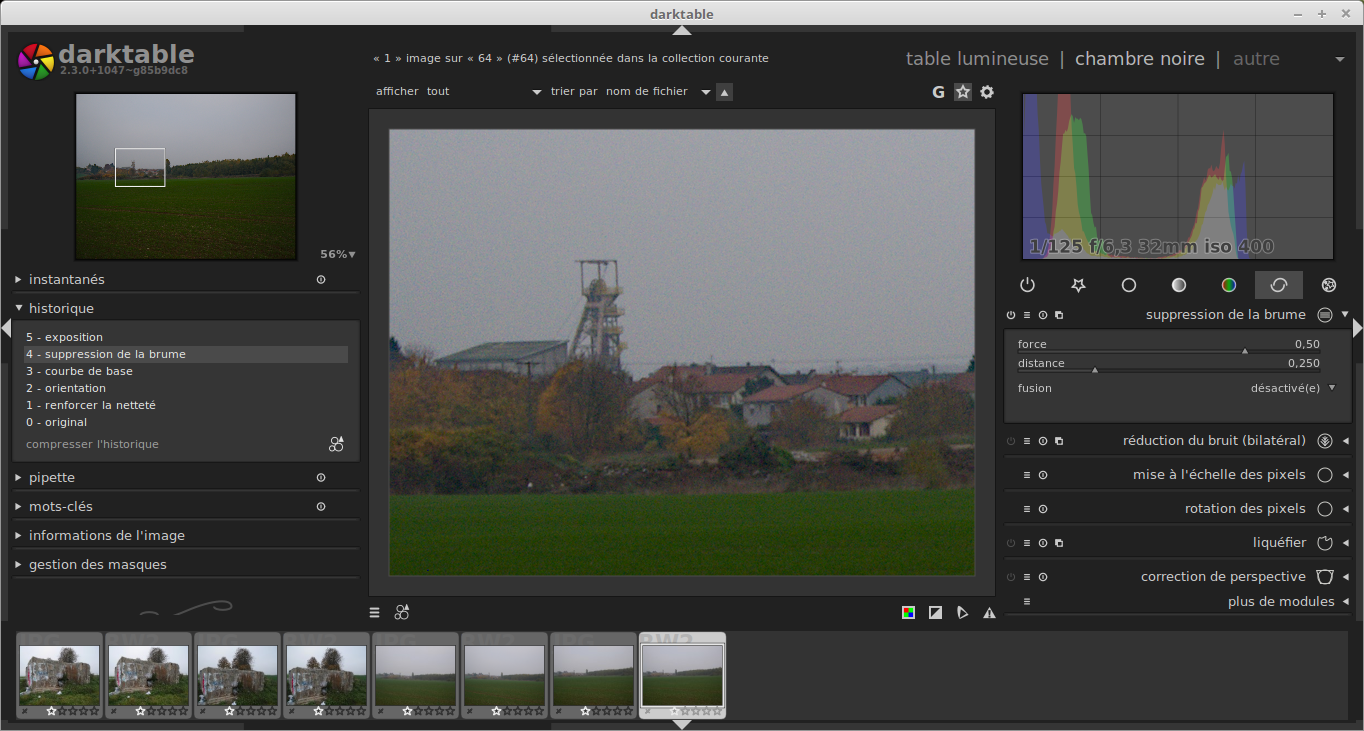

Regardons maintenant les deux curseurs :

- la force permet de contrôler le voile atmosphérique. Comme on peut s’y attendre, la valeur 0 signifie qu’on n’applique pas d’effet, et la valeur 1 tente de supprimer la totalité de la brume, donc de rétablir une image correctement contrastée et colorée. Bien sûr, plus on augmente cette valeur plus on risque d’amplifier les défauts de l’image, en particulier le bruit ;

- la distance permet d’agir plus ou moins sur les différents plans de la photo. Par défaut, darktable va tenter de supprimer la brume du premier plan, mais pas de l’arrière‐plan. En jouant sur ce curseur on peut choisir à partir de quelle distance on arrête cet effet.

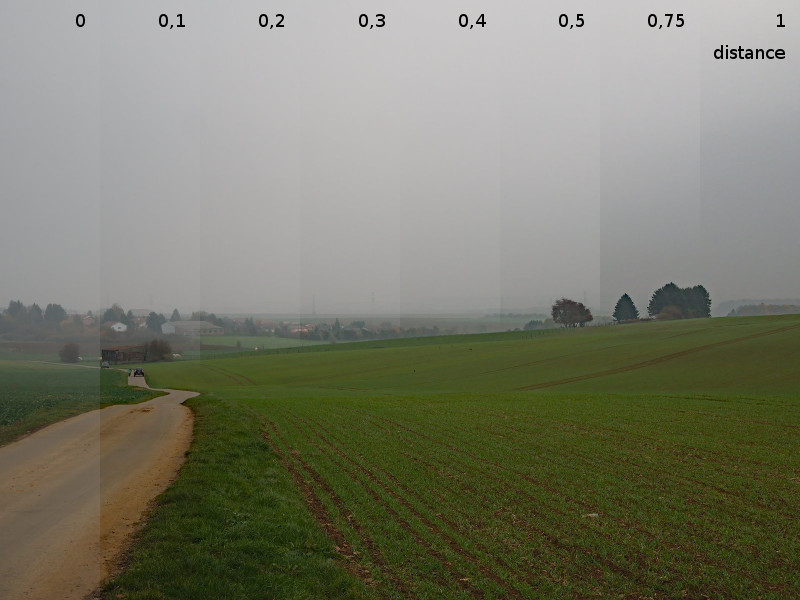

Voici ce que donne ce second curseur sur une autre image de la même série. Le curseur de force est sur 0,6 (sur cette photo, au‐delà, on voit de vilains artefacts) et l’on fait varier la distance :

À distance 0, le module ne modifie pas l’image. En passant de 0 à 0,1, on voit clairement que le premier plan est restauré, mais le curseur a peu d’effet sur l’arrière‐plan et le ciel. Les maisons au fond de l’image sont encore assez pâlies par le brouillard. Sur les tranches suivantes l’effet ne change plus sur l’herbe au premier plan : le module considère qu’il a supprimé la brume et ne cherche pas à enlever plus que ce qu’il a déjà fait. En revanche, les maisons sont de moins en moins pâles. Arrivé à 0,5, le curseur ne change plus beaucoup le paysage mais l’effet s’applique sur le ciel, ce qui n’est pas forcément du meilleur effet : il est sans doute préférable de s’arrêter avant !

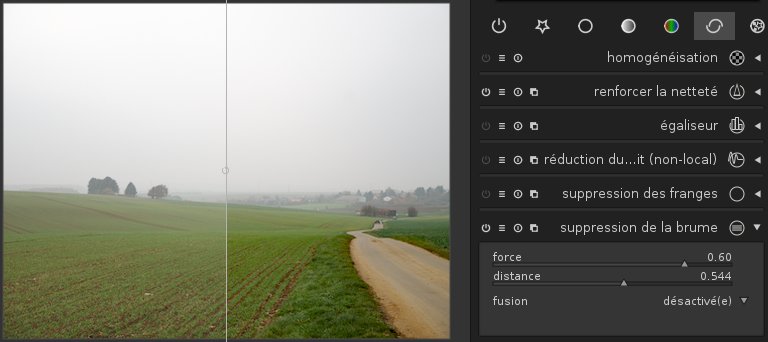

La suppression de la brume a réduit la luminosité de l’image (qui était déjà relativement sombre au départ). On peut terminer le travail en rectifiant l’exposition avec les modules exposition et niveaux. Au final, on obtient ceci (seul le module suppression de la brume diffère entre les deux côtés) :

En appliquant une force négative, on peut aussi « ajouter » de la brume. Dans ce cas, le curseur de distance est ignoré.

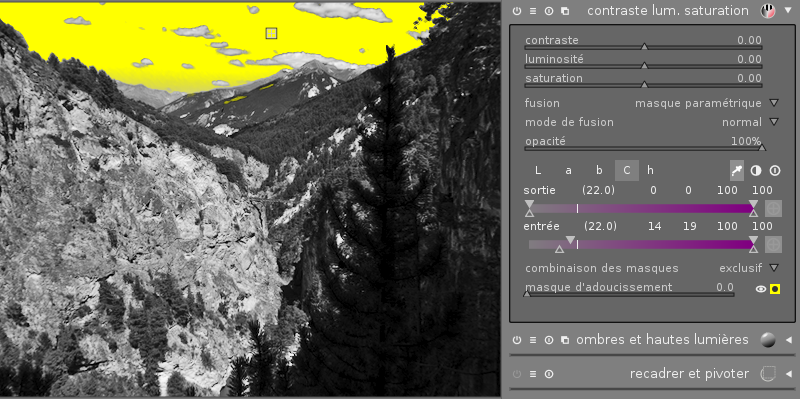

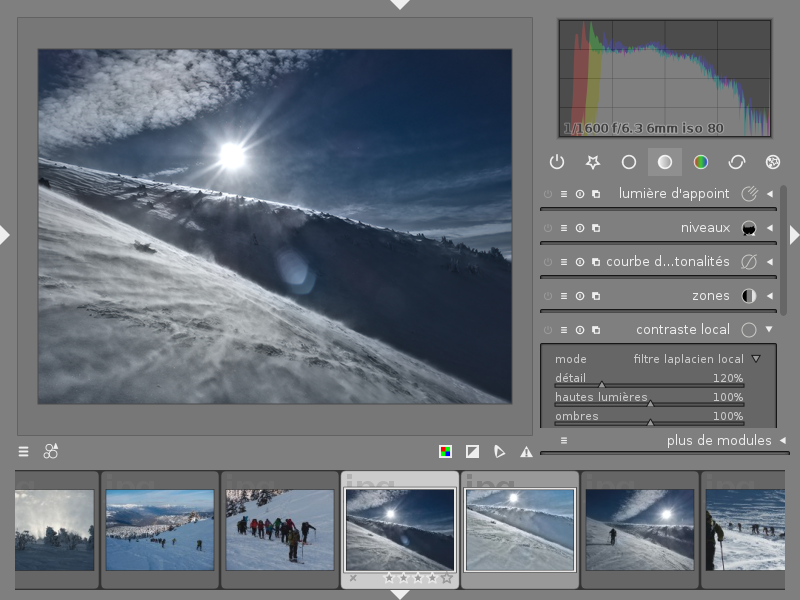

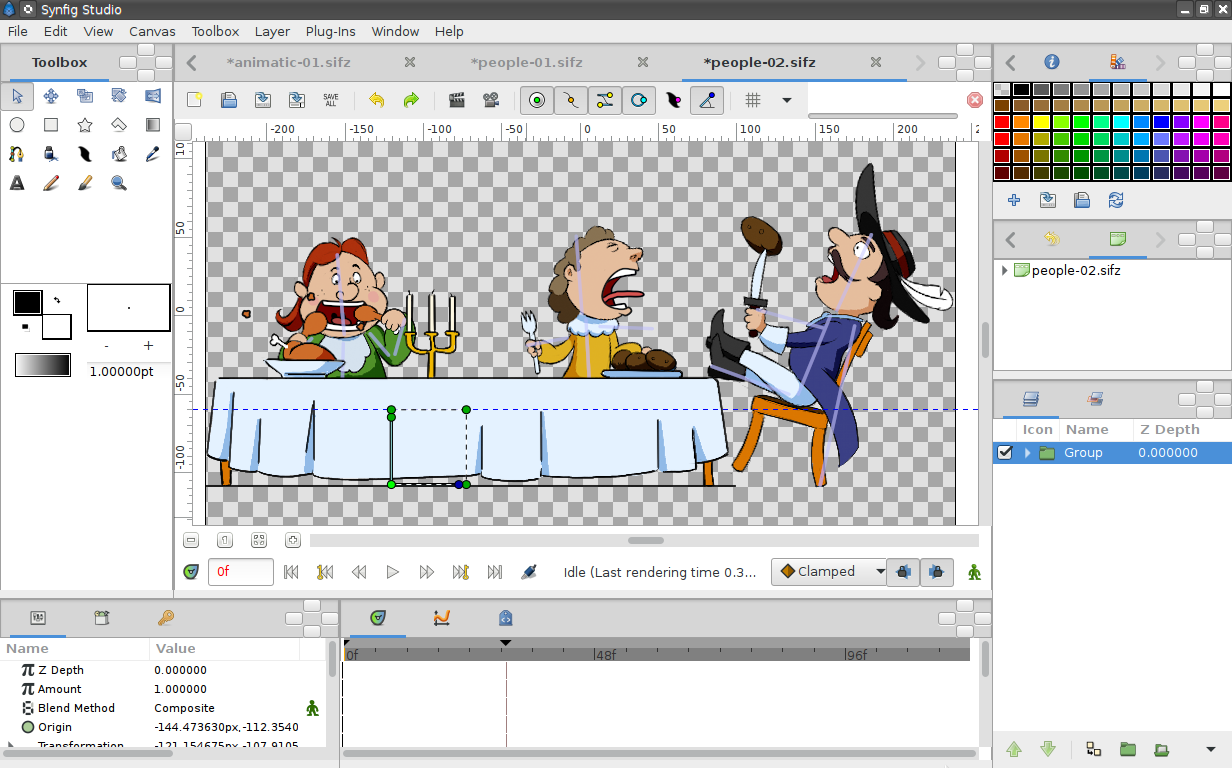

Nouveau mode « filtre laplacien local » (local laplacian filter) dans « contraste local »

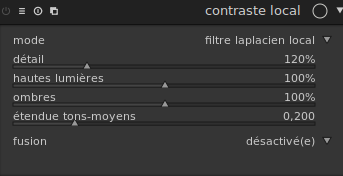

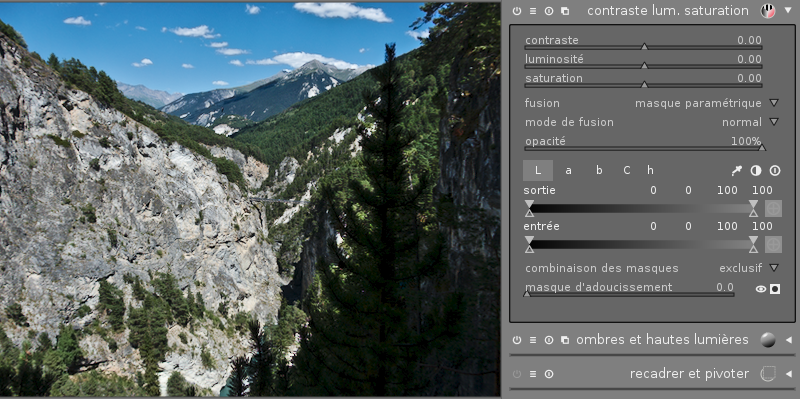

Le module contraste local se voir doté d’un nouveau mode filtre laplacien local :

Jusqu’à présent, ce module utilisait un filtre bilatéral (toujours disponible, également connu sous le nom de flou de surface) pour créer un masque flou. Le filtrage laplacien donne un résultat plus subtil, en permettant une meilleure récupération des détails sans altérer le contraste local de façon aussi marquée.

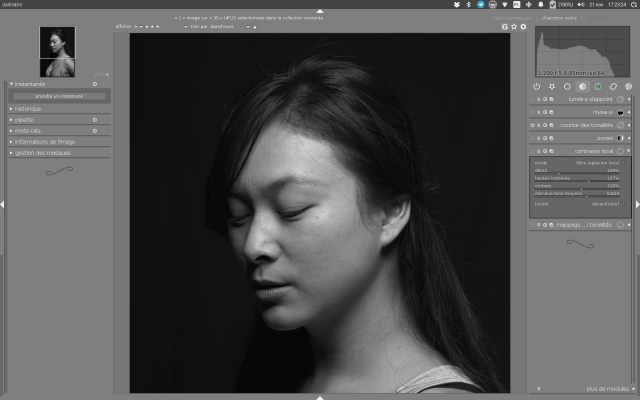

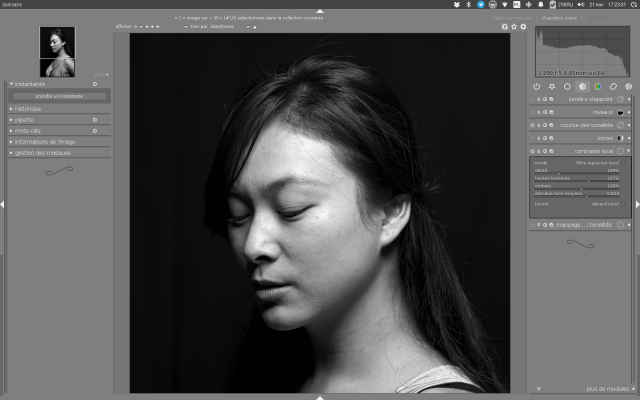

La possibilité de piloter séparément le contraste dans les hautes et basses lumières le rend aussi intéressant pour ajouter du modelé dans un portrait :

Dans ce contexte, l’effet se rapproche de l’utilisation d’un bol beauté (ou beauty dish, modificateur de flash rond de 30 à 45 cm de diamètre qui donne une lumière relativement ponctuelle utilisée pour découper le dessus des joues, l’arrête nasale et marquer le relief du visage).

Comme leur nom l’indique, les curseurs ombres et hautes lumières permettent d’augmenter ou de diminuer la luminosité dans les zones sombres et claires, et le curseur étendue des tons moyens permet de décider sur quelle étendue de luminance on veut appliquer l’effet des différents curseurs : 0 revient à désactiver l’effet du curseur détail, mais applique les effets des curseurs ombres et hautes lumières, respectivement sur la moité d’image la plus sombre et la plus claire (c’est donc équivalent à désactiver le module si l’on laisse ces deux derniers curseurs sur 100 %). La valeur 1 fait l’inverse : les curseurs ombres et hautes lumières n’ont plus d’effet mais le curseur détails modifie l’ensemble de l’image. Les autres valeurs, par exemple 0,5, font un intermédiaire.

À l’inverse, en retirant du contraste, on obtient un effet de tone‐mapping (compression de la plage dynamique) très naturel, qui peut se substituer au module Ombres et hautes lumières, en retirant du contraste global sans casser le contraste local (donc la sensation de netteté) :

Ce module remplace aussi Renforcer la netteté, basé sur un masque flou gaussien, et dont un intérêt est d’inverser l’effet des filtres passe‐bas présents sur les capteurs d’appareils photo afin de limiter le moiré. Les constructeurs faisant progressivement disparaître les filtres passe-bas, ce module devient progressivement moins utile, d’autant qu’il est enclin à créer des halos sur les bords durs contrastés (transitions ciel‐bâtiments, par exemple).

Les détails sur ce module (mathématiques sous‐jacentes, exemples d’applications) sont décrits dans l’article de blog Local laplacian pyramids sur le site de darktable.

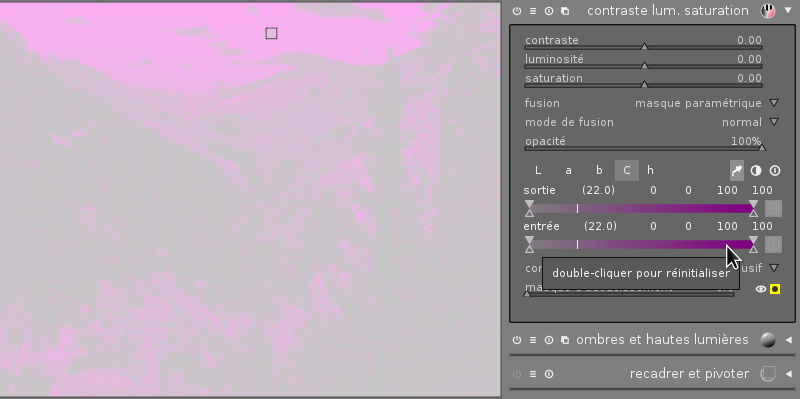

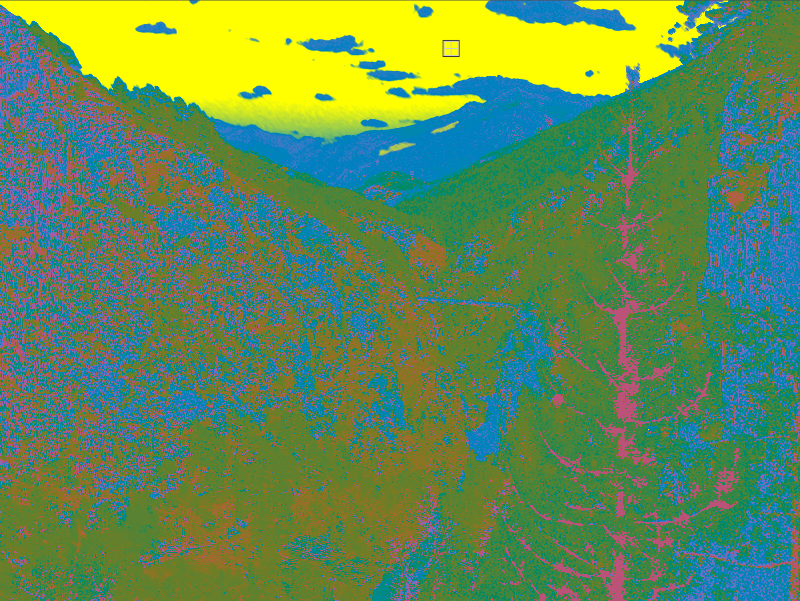

Affichage des canaux et des masques en pseudo‐couleurs

La quasi‐totalité des outils de darktable permettent de cibler des parties d’images (bouton fusion en bas de chaque module). On peut au choix dessiner un masque ou bien construire son masque en sélectionnant les pixels selon la valeur des canaux qui constituent ce pixel (L, a, b, saturation, couleur). Dans le second cas, la méthode classique consiste à utiliser la pipette pour trouver les caractéristiques de la zone à cibler, puis à entourer cette valeur avec les curseurs. Mais cette méthode suppose que l’on sache déjà sur quels canaux il est pertinent de filtrer. Bien souvent, l’encadrement de la valeur cible sera trop précis (et on ne sélectionnera pas toute la zone voulue), ou bien au contraire pas assez et on appliquera le traitement à une zone de l’image qu’on souhaitait exclure.

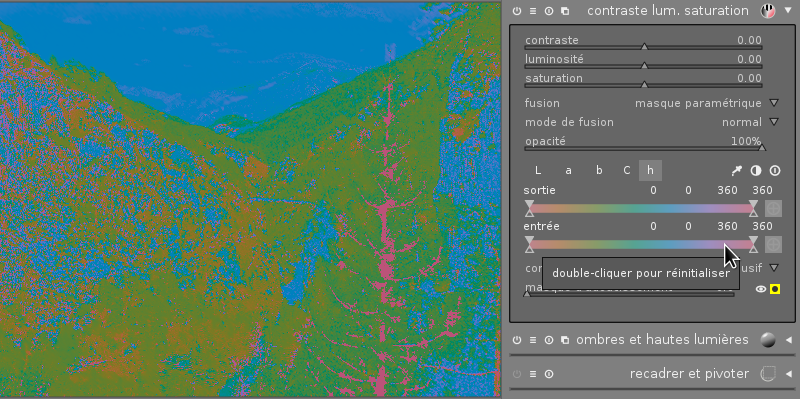

On peut maintenant visualiser non seulement le masque actuel (clic ou contrôle clic sur le bouton en bas à droite de la partie masque paramétrique), mais aussi la valeur de chacun des canaux sur lesquels on fait la sélection (

Maj+ clic sur le même bouton). Voyons ceci sur un exemple. Notre objectif est d’appliquer une transformation sur le bleu du ciel (par exemple le rendre un peu plus foncé) :

Vu que l’on cherche à masquer du bleu, un réflexe assez naturel serait de filtrer sur le canal h (hue, ou teinte). On peut visualiser ce canal en faisant un

Maj+ clic sur le bouton de visualisation du masque, puis en passant la souris sur la réglette correspondant au canal à visualiser. Voici le résultat :

L’image est affichée uniquement par sa teinte : tous les pixels ont la même saturation (la même « intensité de couleur ») et la même luminance.

Cette visualisation fait apparaître une mauvaise nouvelle : il y a du bleu un peu partout dans notre image (mais en général, il est très sombre ou très peu saturé et on ne le voit pas forcément comme du bleu). On peut tout de même encadrer la valeur cible bleue, mais ce n’est pas la peine de chercher à éliminer les autres pixels bleus avec cette réglette : nous venons de voir qu’ils ont la même teinte :

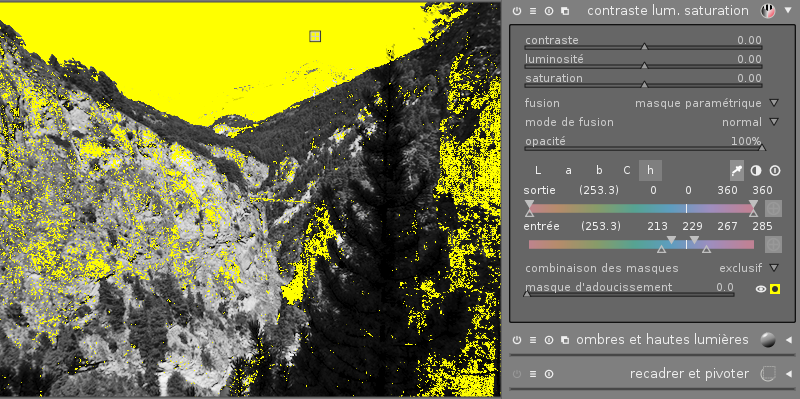

On peut parcourir les autres canaux et les visualiser pour chercher celui qui est le plus discriminant afin d’éliminer nos pixels parasites. Le canal de saturation semble être un bon candidat :

La couleur utilisée dans l’image est la même que celle de la réglette : blanc (ou gris) pour les pixels peu saturés, violet pour les pixels les plus saturés. Clairement, le ciel est plus saturé que le reste de l’image (ce qui n’était pas nécessairement évident à l’œil sur l’image originale). On peut exclure les pixels les moins saturés :

Il reste quelques zones sélectionnées hors du ciel, mais ces zones sont plus sombres que le ciel, on peut facilement les éliminer sur l’un des deux canaux L ou g.

On peut aussi afficher les deux informations (masque et canal) en faisant un

Ctrl+Maj+ clic sur le bouton :

En résumé :

- clic, ou

Ctrl+ clic : affichage du masque ; -

Maj+ clic, puis survol d’une réglette : affichage d’un canal ; -

Ctrl+Maj+ clic : affichage combiné.

Version Windows

Lors de la sortie de darktable 2.2, on avait déjà parlé en octobre 2016 de la demande d’intégration de Peter Budai qui ajoutait la prise en charge de Windows. Cette pull request a été bien accueillie, longuement discutée (avec 241 commentaires) et après des mois de travail sur l’amélioration du code, intégrée à darktable en avril. En août, darktable annonçait sa première version Windows pré‐alpha, mais déjà utilisable. Cette version 2.4.0 apporte la prise en charge officielle de Windows. Il reste quelques limitations (pas de module d’impression, pilotes spécifiques requis pour pouvoir prendre des photos directement à travers USB, et sans doute encore beaucoup de bogues), mais elle est utilisable et considérée comme une version officielle au même titre que les versions GNU/Linux et macOS.

Coïncidence intéressante, la prise en charge de Windows arrive au même moment qu’un changement de politique de licence pour Adobe Lightroom. Beaucoup d’utilisateurs de Lightroom cherchent un remplacement (voir ici ou là, par exemple) et darktable a déjà satisfait plus d’un ancien utilisateur de Lightroom. On peut donc s’attendre à une explosion du nombre d’utilisateurs de darktable.

Avec l’arrivée de nombreux nouveaux utilisateurs sur une version Windows, pas encore aussi stable que la version GNU/Linux, on peut craindre que les forums et les systèmes de suivi de bogues soient inondés de plaintes non constructives. C’est ce que les développeurs redoutaient avec une version Windows. Espérons que les nouveaux venus seront constructifs et permettront au contraire d’agrandir la communauté et au final d’améliorer la qualité du logiciel. Voir par exemple quelques conseils à l’attention des nouveaux utilisateurs de darktable. Après tout, plusieurs développeurs actuels de darktable sont des anciens utilisateurs de Lightroom !

Des petits détails qui peuvent changer la vie

Possibilité de choisir la couleur de fond de l’interface via CSS

L’interface de darktable suit le principe « les photos, rien que les photos ». Tout est fait pour éviter d’attirer l’œil vers les autres zones de l’écran. Un point important : il y a très peu de couleurs, ce qui permet à l’œil d’avoir une référence du gris non coloré. Il serait difficile d’ajuster correctement la balance des blancs sur un fond coloré par exemple.

Un défaut potentiel de l’interface par défaut, c’est que le gris sombre peut avoir tendance à habituer l’œil aux couleurs sombres, et donc à encourager le photographe à sous‐exposer les images. Dans une de ses vidéos, Aurélien Pierre part de ce constat et propose une interface plus claire, correspondant au point gris d’une image. L’interface donne alors non seulement une référence de balance des blancs, mais aussi de luminosité. Malheureusement, pour obtenir ce résultat il fallait non seulement éditer le fichier de configuration

darktable.css, mais aussi changer quelques valeurs qui étaient restées codées en dur dans le code source de darktable, et le recompiler.Dans la version 2.4, ces valeurs sont devenues configurables et l’on peut donc obtenir le même résultat sans recompilation. Voici un exemple de fichier, à placer dans

~/.config/darktable/darktable.css:@import '/usr/share/darktable/darktable.css'; @define-color bg_color #7F7F7F; @define-color plugin_bg_color #333; @define-color fg_color #eee; @define-color base_color #444; @define-color text_color #eee; @define-color selected_bg_color #666; @define-color selected_fg_color #eee; @define-color tooltip_bg_color #BEBEBE; @define-color tooltip_fg_color #111; @define-color really_dark_bg_color #595959; @define-color darkroom_bg_color #777777; @define-color darkroom_preview_bg_color shade(@darkroom_bg_color, .8); @define-color lighttable_bg_color @darkroom_bg_color; @define-color lighttable_preview_bg_color shade(@lighttable_bg_color, .8);Et voici le résultat sur l’interface :

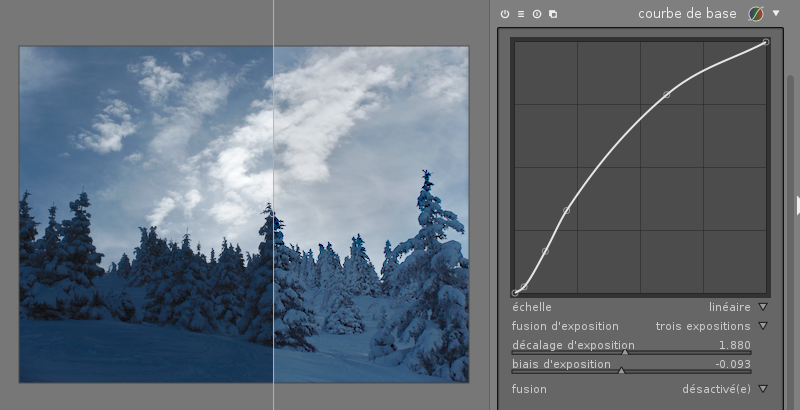

Curseur « biais d’exposition » dans le mode « fusion d’exposition » du module « courbe de base »

Souvenez‐vous : la version 2.2 avait vu arriver une option fusion d’exposition dans le module courbe de base. C’est un des meilleurs moyens de réduire le contraste global d’une image en préservant le contraste local et sans introduire de halo, et cela permet de faire le même genre de traitement qu’en exportant plusieurs images et en les fusionnant avec enblend, mais sans quitter darktable. Mais obtenir les bons réglages n’était pas toujours facile : le seul curseur disponible agissait à la fois sur la force de réduction du contraste et sur l’exposition globale de l’image. On devait donc souvent combiner le module courbe de base et exposition, et faire plusieurs allers‐retours entre les deux pour trouver la combinaison gagnante.

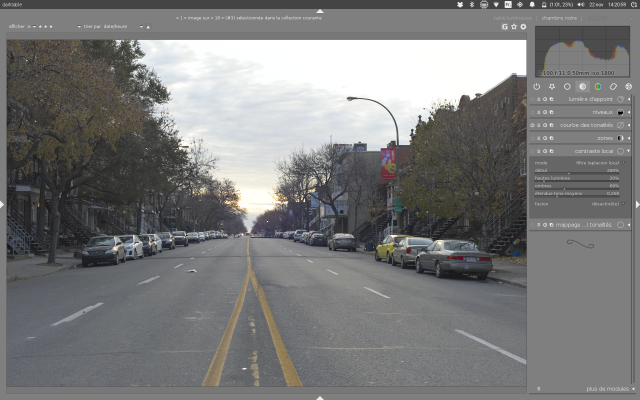

Fatigué de ces allers‐retours, votre serviteur a ajouté un curseur de « biais » au module courbe de base qui permet de modifier la signification du curseur décalage d’exposition. Le principe reste de créer plusieurs images avec une exposition différente et de les fusionner. Par défaut, on crée des images surexposées et on les fusionne avec l’image d’origine. C’est adapté quand on a réglé l’exposition sur les zones les plus claires de l’image : le résultat est de déboucher les zones sombres. Mais bien souvent, le résultat est de surexposer l’ensemble de l’image. Avec le curseur de biais, on peut choisir entre fusionner avec des images surexposées (biais de 1), des images sous‐exposées (biais de -1), ou un intermédiaire, par exemple un biais de 0 avec une fusion de trois expositions fusionnera l’image d’origine avec une version surexposée et une version sous‐exposée.

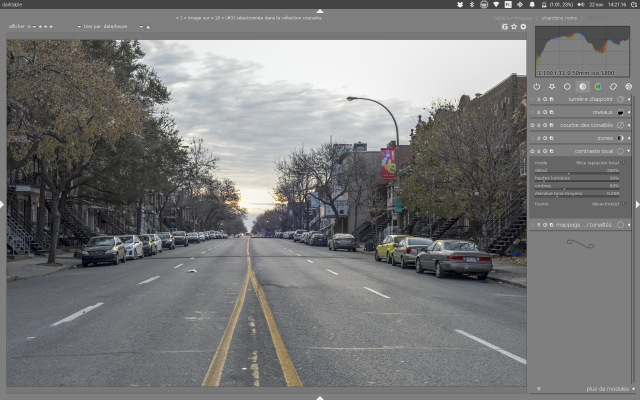

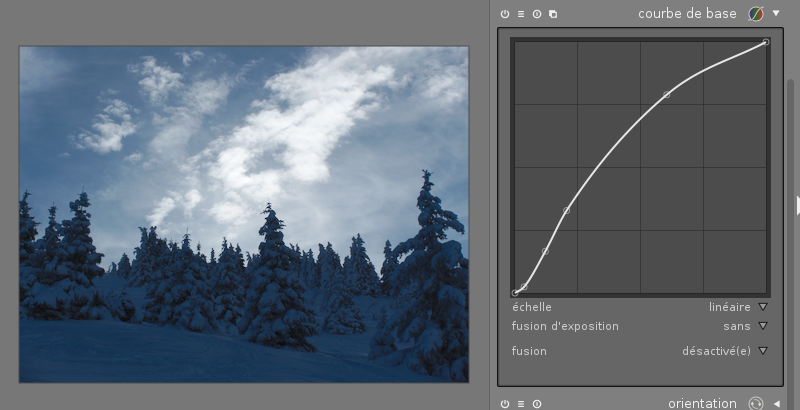

Voyons cela sur un exemple :

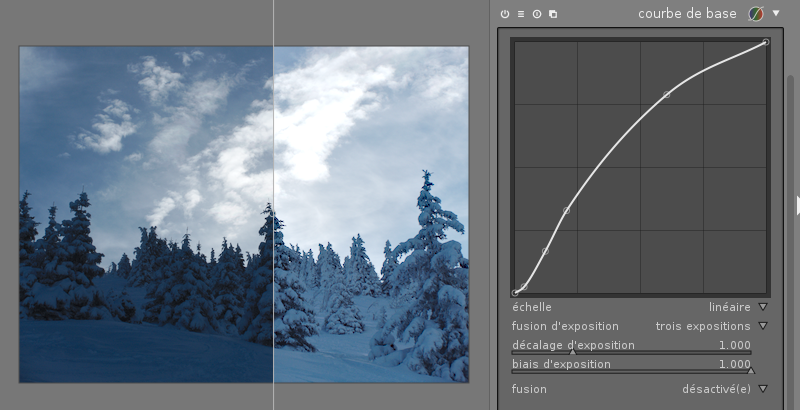

L’écart de contraste entre le ciel et les arbres est important. Essayons de le réduire pour que les arbres soient moins bouchés, mais sans surexposer le ciel. Première étape : prendre un instantané et afficher l’image avant/après, cet affichage va servir à régler le curseur de biais. Puis, application de la fusion d’exposition. Avec les paramètres par défaut pour trois expositions, on obtient ceci :

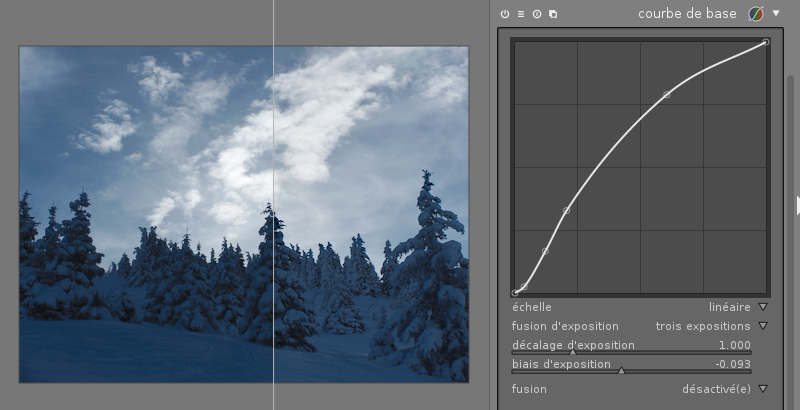

Comme on s’y attendait, le résultat a globalement surexposé l’ensemble de l’image. La photo est prise au lever du soleil, on souhaite garder cette ambiance matinale, donc cette version ne convient pas. On règle maintenant le biais pour retrouver une exposition correcte sur l’ensemble de l’image. Une solution pour faire cela est de prendre une partie de l’image qui était à l’origine dans les tons moyens (ici le ciel en dehors des nuages) et de s’arranger pour que la fusion d’exposition ne modifie pas cette partie de l’image. Avec notre instantané avant/après, c’est assez facile à faire :

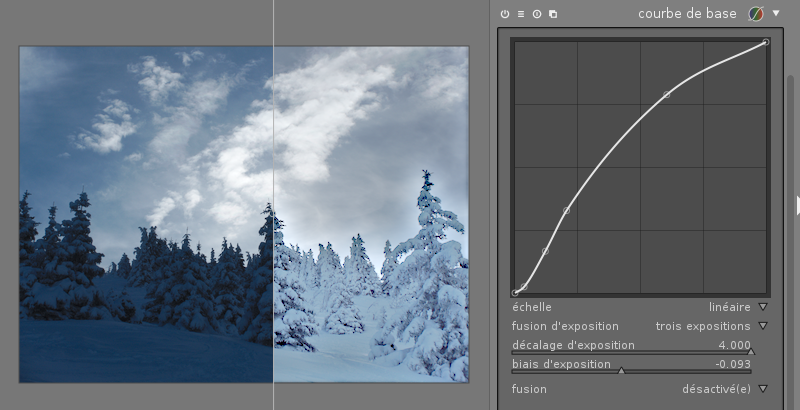

Finalement, on se rend compte que le principal effet de la fusion d’exposition a été de surexposer l’image, mais la réduction de dynamique entre les zones claires et les zones sombres n’était pas si forte. Voyons ce qu’il se passe si l’on pousse le curseur « décalage d’exposition » plus loin (sans toucher au curseur de biais) :

Ce n’est pas très joli, mais la bonne nouvelle est que, même en poussant ce curseur au maximum, on n’a ni surexposé ni sous‐exposé l’image : une fois le curseur de biais bien placé, le curseur de décalage d’exposition agit uniquement sur la dynamique de l’image. On peut donc choisir la force de l’effet en agissant sur ce curseur. Par exemple, avec une valeur un peu en dessous de 2, on obtient une image relativement équilibrée :

Le premier plan n’est plus bouché, on retrouve du contraste dans la neige alors qu’il était quasi‐invisible dans l’ombre, mais le ciel reste correctement exposé. Il reste beaucoup de marge de manœuvre pour la suite du traitement, le photographe va pouvoir jouer sur le contraste local sans risquer de surexposer ou sous‐exposer par exemple.

Amélioration de la fonction « annuler » en chambre noire

La version 2.2 avait vu arriver une fonction « annuler » en chambre noire : les raccourcis clavier

Ctrl+ZetCtrl+Ypermettent d’annuler ou de refaire les dernières actions. Ceci vient en complément de l’historique (dans la barre latérale de gauche) et permet de gérer les actions à annuler avec une granularité plus fine.La version 2.4 apporte les touches finales à cette fonctionnalité :

- une meilleure gestion des groupements d’actions : en version 2.2, la granularité était en fait un peu trop fine, certaines actions à annuler correspondaient à des changements internes non pertinents pour l’utilisateur ; le résultat : parfois rien ne se passait sur un

Ctrl+Zet il fallait taper plusieurs fois cette combinaison pour avoir un effet ; - la gestion des masques, qui était absente jusqu’ici : un

Ctrl+Zpermet maintenant d’annuler une action sur un masque dessiné (création, déplacement, suppression de formes), ceci est primordial puisque les masques ne sont pas dans l’historique et leCtrl+Zest alors la seule manière de revenir sur les accidents de déplacement.

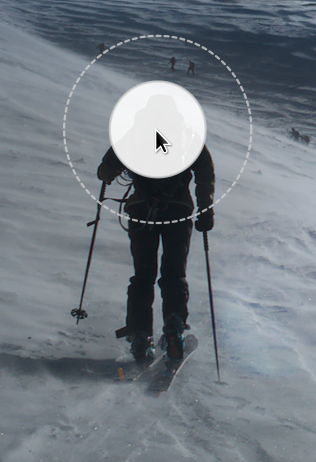

Une brosse transparente

Beaucoup d’utilisateurs se plaignaient du fait que l’outil brosse, pour dessiner un masque à la souris, était opaque : une fois une zone couverte, plus moyen de savoir ce qu’il s’y trouvait, et même le curseur était opaque.

Avec la nouvelle version, on a maintenant une légère transparence :

Si ce n’est pas assez transparent, pas de panique : c’est configurable en CSS. Avec ceci dans le fichier

darktable.css:@import '/usr/share/darktable/darktable.css'; @define-color brush_cursor alpha(white, .5); @define-color brush_trace alpha(black, .4);On obtient ce résultat :

L’opacité du masque est toujours réglable avec la molette de la souris. Pour vous indiquer quand l’opacité du masque atteint 100 %, l’épaisseur du contour du curseur change quand c’est le cas.

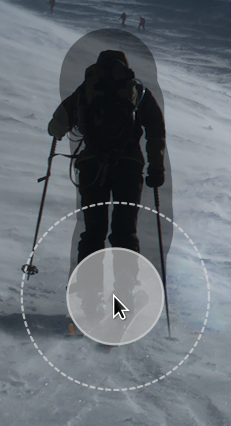

Mode « absolu » dans la table de correspondance des couleurs

La table de correspondance des couleurs permet de modifier sélectivement les couleurs d’une image. Une utilisation type est de prendre en photo une mire dont on connaît la couleur de chacune des pastilles (patch).

On pouvait régler la couleur cible de chaque pastille avec des curseurs permettant de rendre les pastilles plus vertes, plus rouges, plus bleues, plus jaunes, plus claires ou plus foncées. Mais pour forcer une couleur en particulier (celle attendue pour une pastille donnée), on était obligé de procéder à tâtons en bougeant les curseurs et en regardant la valeur de couleur à l’aide de la pipette. C’est maintenant réparé, on peut entrer directement les valeurs cibles en Lab :

Profils OpenCL

Il est désormais possible de choisir comment répartir la charge de calcul entre le processeur et le processeur graphique, en utilisant plusieurs profils de planification OpenCL. Les trois options proposées sont :

- standard : le processeur calcule les prévisualisations (version réduite de l’image affichée en haut à gauche), le processeur graphique calcule l’affichage principal et l’exportation ;

- GPU rapide : tout le calcul est effectué par le processeur graphique, pour une retouche beaucoup plus réactive ; en revanche, exporter une image en arrière‐plan pendant la retouche d’une autre image devient pratiquement impossible ;

- GPU multiples : prévisualisations et exportations sont réparties entre les différents processeurs graphiques.

On peut aussi forcer l’utilisation d’OpenCL en préfixant une entrée d’un

+dans la variable de configurationopencl_device_priority.Autres changements

Dans les modules courbe de base et courbe des tonalités, les coordonnées du point courant sont affichées pendant l’édition. On peut faire un clic droit sur un point pour le supprimer (même action que pour supprimer des formes de masques).

On peut maintenant créer une nouvelle instance de module en cliquant avec le bouton du milieu sur l’icône multi‐instances (au lieu de faire un clic gauche et de choisir l’entrée nouvelle instance du menu).

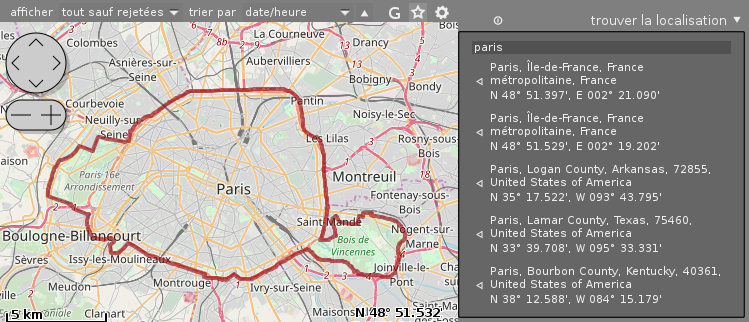

Une recherche dans le module carte affiche un contour autour de la zone au lieu de colorer toute la zone :

Un clic sur le bouton réinitialiser les paramètres du module trouver la localisation du mode carte efface la liste des résultats et le contenu de champ texte de ce module.

Avec une version d’osm-gps-map récente, des informations de copyright sont affichées.

Les variables utilisées par l’exportation et le module filigrane ont maintenant une syntaxe de substitution inspirée de celle de Bash. Par exemple,

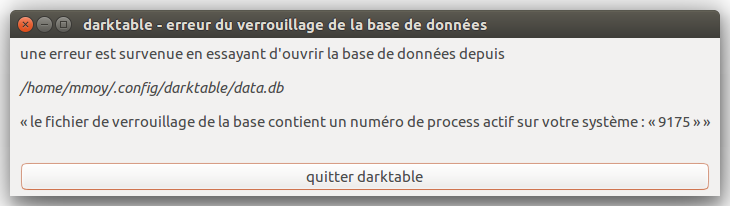

$(TITLE-Mon titre par défaut)sera étendu avec le contenu de la variableTITLEsi elle est définie, et « Mon titre par défaut » sinon.Quand on tente d’ouvrir darktable alors qu’une instance tourne déjà, darktable affiche maintenant une boîte de dialogue expliquant la situation :

Les opérations d’import‐export affichent maintenant une barre de progression dans le dock si l’environnement de bureau le permet :

Le curseur de détail du module contraste local, dans le mode grille bilatérale (l’ancien mode), peut maintenant être poussé plus loin qu’avant.

L’utilisateur peut choisir d’avoir une confirmation avant de supprimer un répertoire vide.

Le module balance des couleurs est maintenant plus rapide grâce à une optimisation utilisant du code SSE.

Le niveau de compression des images PNG est maintenant réglable.

Sous macOS, on peut ouvrir des images individuellement en ligne de commande ou via glisser‐déposer.

Une option permet de supprimer la hiérarchie intermédiaire et de n’exporter que le dernier niveau de chaque mot clef.

Dans le module filigrane, la liste des fichiers SVG est maintenant triée et omet l’extension.

Le profil XYZ est maintenant disponible dans les options d’épreuvage.

-

Deux nouveaux scripts sont fournis avec darktable :

-

purge_from_cache.shpour supprimer du cache (~/.cache/darktable/mipmaps-*) les images absentes de la base de données ; -

watch_folder.shqui utilise inotify pour surveiller un répertoire et ouvrir les nouveaux fichiers dans darktable.

-

Un nouvel algorithme de dématriçage (demosaic) « chroma de domaine fréquentiel » (Frequency Domain Chroma), applicable aux capteurs X-Trans (et seulement à ceux‐là), qui produit moins d’effets de moiré dans certains cas. Attention, il n’est pas toujours meilleur que l’algorithme de Markesteijn utilisé par défaut sur ces capteurs (voir par exemple cette discussion, comparatifs à l’appui). Une bonne stratégie est d’essayer chaque algorithme pour voir quel algorithme est le meilleur sur les images problématiques et de garder la valeur par défaut dans le cas général.

De nouveaux modes de fusions sont apparus pour fusionner spécifiquement sur un canal (RGB canal rouge/vert/bleu et Lab canal a/b). L’exemple qui a justifié cette introduction est celui d’une image bruitée sur un canal et moins sur les autres : on peut maintenant appliquer un « débruitage » violent sur le canal problématique et laisser les autres canaux intacts. Sur le module courbe de base, en instanciant le module une fois sur chacun des canaux rouge, vert et bleu, on peut obtenir un réglage par courbes RVB, qui manque à certains sous darktable.

Le module courbe des tonalités a maintenant un mode de mise à l’échelle des canaux a et b automatique RGB, qui produit l’équivalent d’un réglage par courbe dans l’espace de couleur ProPhoto RGB.

Les fichiers

.xmpne sont maintenant plus écrits sur le disque quand leur contenu n’a pas changé. Ceci évite des sauvegardes inutiles aux outils de sauvegarde incrémentales et permet d’éviter une latence inutile sur des disques réseaux lents par exemple.Sur un ordinateur disposant de plus de 8 Gio de mémoire vive, la configuration par défaut utilise maintenant la moitié de cette mémoire pour chaque module.

La limite supérieure d’ISO dans l’interface a été remontée (elle était à 51 200 ISO).

Les modules courbe de base et reconstruire hautes lumières peuvent maintenant être instanciés plusieurs fois et peuvent utiliser la fusion.

Dans la table lumineuse, la touche

1bascule par défaut de zéro à une étoile (appuyer deux fois revient à la situation initiale). Cette fonctionnalité ne plaisait pas à tout le monde et est maintenant configurable (dans options d’interface, option appliquer une étoile deux fois ne supprimera pas l’étoile).On peut demander une confirmation avant de réinitialiser l’historique d’une image depuis la table lumineuse.

Le module grain a été modifié pour donner un rendu plus proche de celui des photos argentiques, en appliquant plus de grain dans les tons moyens et moins dans les zones d’ombre et de lumière.

Le module table correspondance couleurs permet maintenant de faire un passage en noir et blanc selon l’effet Helmholtz‐Kohlrausch, qui tient compte de la sensibilité de l’œil dans les différentes couleurs pour obtenir un rendu le plus naturel possible.

Les traductions ont été mises à jour pour le catalan, le tchèque, le danois, le néerlandais, le français, l’allemand, le grec, l’hébreu, le hongrois, l’italien, le japonais, le russe, le polonais, le slovaque, le slovène, l’espagnol, le suédois et l’ukrainien.

L’API Lua a reçu quelques modifications mineures (voir les notes de sorties officielles pour les détails).

Il faut maintenant au moins CMake 3.1, GCC 4.9 ou clang 3.4 (GCC 5.0 fortement recommandé) et Lua 5.3 pour compiler darktable. La bibliothèque zlib est maintenant requise.

Les couleurs primaires et le point blanc sont maintenant lus en ouvrant les fichiers

.hdret ils sont utilisés dans le profil de couleur d’entrée.

Prise en charge de nouveaux boîtiers et types d’images

Désormais, darktable est capable de lire les images RAF Fujifilm compressées, les fichiers DNG en virgule flottante produits par HDRMERGE.

Et, comme d’habitude, la prise en charge de nouveaux boîtiers se poursuit avec une grosse soixantaine d’appareils en plus : voir les notes de sorties officielles pour la liste complète.

Nouveau site darktable.org

Le site darktable.org fait peau neuve. L’ancien site, basé sur Wordpress, est remplacé par un site statique généré via Python/Pelican. On peut y contribuer via des pull‐requests sur le projet GitHub dtorg. Un gros intérêt du site statique est qu’il pose beaucoup moins de problèmes de sécurité que les sites dynamiques. Voir l’article A new website pour les détails. Le nouveau site marque aussi un rapprochement avec pixls.us, le site de la communauté libriste sur la photographie. Les commentaires sont de retour sur darktable.org via une intégration des forums de pixls.us. En bref : comme le dit maintenant chaque page du site, « pixls.us ♡’s darktable » !

Nouvelle collection d’échantillons de fichiers RAW

Aujourd’hui darktable gère plus de 550 boîtiers. On peut remercier les développeurs, car même si beaucoup codent sur darktable pour leurs besoins personnels, énormément d’efforts sont faits pour gérer un maximum de boîtiers, y compris ceux qu’aucun développeur ne possède. La mauvaise nouvelle étant que pour chaque boîtier, il peut y avoir des variantes du format de fichier, des paramètres différents, etc. Ajouter la prise en charge d’un boîtier représente du travail et tester que cette prise en charge continue à fonctionner de versions en versions est un travail gigantesque. Un outil indispensable pour le faire est d’avoir une image pour chaque boîtier et pour chaque format d’image RAW possible (par exemple, 12 bits, 14 bits, compressée ou non…).

Le site de référence était jusqu’à l’année dernière rawsamples.ch. Le site a été victime d’une attaque (injection SQL), et l’absence de sauvegarde n’a pas aidé à sa remise en route… Heureusement, la communauté pixls.us, très active, a lancé un nouveau site pour remplacer le défunt : raw.pixls.us. Une différence est la licence : raw.pixls.us publie les fichiers sous licence CC0 (qui s’apparente au domaine public) pour éviter les éventuelles incompatibilités de licences entre ces images et les logiciels qui les utilisent. L’ensemble des images des rawsample.ch a servi de point de départ pour raw.pixls.us, mais le but est de couvrir un maximum de boîtiers avec des images sous licence CC0.

Si vous avez lu jusqu’ici, filez donc sur le site pour vérifier que tous les échantillons sont disponibles pour votre boîtier, et sinon soumettez le vôtre. Pas besoin d’être un artiste, ni un informaticien : n’importe quelle photo convient.

Pour plus d’information, lire les articles New Year, New Raw Samples Website, Keep the Raws Coming et Raw Samples Wanted sur pixls.us.

Et après ?

Rêvons un peu pour la prochaine version. Qui n’a jamais raté une photo (mise au point ratée, flou de bougé…) importante, et qui n’a jamais espéré un module magique qui retrouve l’image nette tout seul ? Un tel module est envisageable, Aurélien Pierre travaille sur une implémentation de plusieurs articles de recherche récents, en cours d’intégration dans darktable. Voir la discussion Possible module de déconvolution sur le forum darktable.fr. Le module possède déjà un prototype fonctionnel (quoique peu utilisable).

Il s’agit d’apprentissage machine supervisé réalisant une optimisation par descente de gradient, basé sur une déconvolution aveugle (cours en anglais) par l’algorithme de Richardson‐Lucy. Cette déconvolution est connue pour générer des artefacts au niveau des bordures et pour amplifier le bruit, mais ici, elle est régularisée par une méthode statistique et une analyse des gradients (variation totale). Au final, la méthode peut récupérer aussi bien du flou de bougé que d’objectif, à la manière de l’outil Lens softness de DXO, Netteté optimisée de Photoshop ou piccure+. Le vrai défi est la gestion des temps de traitement et donc l’efficacité du code (révisions et contributions bienvenues, notamment sur la partie OpenCL).

Voici un exemple, zoomé à 100 % sur une photo originale de 4 Mpx :

Image floutée (flou gaussien de 5 px) :

Image défloutée (réglages exagérés pour l’exemple) :

Image source :

Un autre outil très attendu est un outil de suppression des taches plus intelligent. Le module correction des taches actuel fait simplement un clone d’une zone de l’image vers une autre, mais cela suppose qu’il existe une autre zone de l’image ayant les mêmes couleurs (par exemple, il est assez délicat à utiliser dans un ciel dégradé). Bonne nouvelle : Edgardo Hoszowski (qui travaille aussi avec Aurélien sur la déconvolution) planche sur la question, il a proposé un morceau de code qui combine le module actuel de darktable, le greffon wavelet decompose de GIMP, et l’outil correcteur (heal) de GIMP dans un module retouche.

Le module est opérationnel mais pas encore intégré à darktable, il reste du travail de revue et de nettoyage de code. S’il est intégré, le nouveau module permettra par exemple d’effectuer des retouches de portrait avancées de manière non destructrice et sans quitter darktable. Pour l’instant, ce genre de peaufinage demande de passer par GIMP, voir par exemple ce tuto sur la retouche par séparation de fréquence ou celui‐ci en anglais qui utilise le greffon GIMP Wavelet decompose.

Comme d’habitude, c’est plus le temps que les idées d’améliorations qui manque.

-

Lister rapidement les liens d'une page web

(Journaux LinuxFR)

Il y a quelques jours je suis tombé sur une page web cul-de-sac. Pas un rongeur pour se la rat-comté.

J'ai donc tenté une inspection du HTML pour tenter d'y voir plus clair, et là j'me suis dit qu'une petite formule de JavaScript me donnerait une réponse limpide quant à la présence de lien dans la page :

javascript:document.querySelectorAll('a').forEach(console.log)J'ai ajouté la formule à mon http://www.grimoire-command.es/post/2018/List-web-page-links-in-Firefox

-

Présentation d'iPXE, un chargeur d'amorçage en PXE

(Dépêches LinuxFR)

Il est parfois nécessaire de faire démarrer une machine sur le réseau (par exemple, une machine sans disque dur) : la technologie la plus courante utilisée sur x86 s'appelle PXE et permet l'amorçage depuis un serveur TFTP. La plupart des cartes réseau modernes intègrent une implémentation de PXE, cependant la spécification ne décrit que le protocole susnommé dont les limitations se font vite sentir sur des configurations un peu complexes.

Heureusement pour nous, il existe depuis 1995 un projet libre qui a pour but le développement d'un firmware de carte réseau bien plus flexible que ce que l'on peut trouver actuellement, il s'agit d'iPXE.

Dans la suite de cette dépêche, vous trouverez une explicitation détaillée de l'étape d'amorçage d'une machine ainsi qu'une présentation des possibilités offertes par iPXE.

Merci à Nÿco, Sébastien Koechlin, ZeroHeure, Xavier Teyssier, Nils Ratusznik, tankey, Xavier Claude, oinkoink_daotter et Benoît pour avoir participé à la rédaction de cette dépêche.

- lien n°1 : Site du projet

- lien n°2 : Screenshots

- lien n°3 : Etherboot/gPXE, l'ancêtre d'iPXE

- lien n°4 : Présentation de gPXE lors d'un Google Tech Talk

- lien n°5 : Le support d'UEFI par iPXE

- lien n°6 : La spécification PXE d'Intel et SystemSoft

Sommaire

Rappels historiques

Lors de l'apparition des machines sans disque, un certain nombre de protocoles, parfois propriétaires, ont dû être développés pour permettre l'assignation d’adresses à celles-ci. Le premier à être normalisé par l'IETF se nomme (RARP), pour Reverse-ARP, qui ressemble beaucoup, dans sa forme, au protocole ARP. Il n'offre cependant que la possibilité d'assigner une adresse à une machine et ne permet pas de communiquer d'autres informations essentielles comme la localisation d'une image à charger. Pour pallier ces limitations, le protocole BootP a ensuite été mis au point, il a finalement été rendu obsolète par l'apparition de DHCP, qui est beaucoup plus flexible.

En 1999, Intel et SystemSoft mettent au point Wired for Management (WFM), un système permettant la gestion de machines sans système d'exploitation, WFM décrit également une technique d'amorçage par le réseau, qui est alors nommée Preboot Execution Environment (PXE), et qui permet de télécharger un chargeur d'amorçage et d'offrir à celui-ci une API pour qu'il puisse charger facilement un noyau via le réseau. De nombreux constructeurs de cartes réseau se sont mis à embarquer des ROM d'extensions sur leurs cartes pour permettre l'amorçage par le réseau.

Bien que six architectures matérielles soient décrites par la spécification, à ce jour seule x86 possède une couverture complète. Cependant, les stations sans disque dur étant un concept assez ancien, on retrouve des solutions rendant un service similaire sur de nombreuses architectures et pour de nombreux systèmes. À noter aussi que l'Unix Libre NetBSD fournit et documente des solutions pour un grand nombre d'architectures. Enfin, SUN Solaris propose un service similaire dans son OpenROM pour son service Jumpstart.

L'amorçage d'une machine

L'amorçage d'une machine de type PC à base de processeur x86/x86-64 se fait généralement en plusieurs étapes, chacune ayant pour but de récupérer un exécutable de plus en plus évolué pour enfin arriver à charger le noyau d'un système d'exploitation.

Amorcer depuis un disque dur

Pour bien comprendre comment l'amorçage par le réseau fonctionne, il convient de savoir comment se passe l'amorçage « classique », c'est à dire depuis un disque dur.

Lors de l'initialisation de la machine, le BIOS détecte les périphériques amorçables (disque dur, disquette, CD-ROM…) et tente de les démarrer l'un après l'autre selon l'ordre configuré. Pour cela il charge en mémoire le premier secteur du périphérique (soit ses 512 premiers octets), et vérifie que les deux derniers octets correspondent bien aux valeurs hexadécimales

AA 55. Si ce n'est pas le cas, il considère que les données chargées ne sont pas destinées à être exécutées et passe au périphérique suivant.

Une fois qu'un programme valide est chargé en mémoire, un certain nombre de valeurs sont placées dans les registres du processeur, comme le numéro du périphérique courant par exemple. Enfin, la première instruction du programme est exécutée.Dans le cas d'un système Linux, le programme en question est généralement un stage1 de GRUB dont le but va être de lire le contenu de la partition

/bootpour en extraire un stage2, qui est un programme bien plus évolué. Il ne faut pas oublier que le stage1 est limité à 510 octets (512 moins les deux derniers octets), ce qui est vraiment peu pour faire quoi que ce soit d'un tant soit peu avancé, d'où la nécessité d'aller chercher un stage2. Heureusement, pour faciliter la vie des concepteurs de chargeurs de démarrage, le BIOS fournit une fonction pour charger un ou plusieurs secteurs d'un périphérique en mémoire. Cette méthode est basée sur une interruption logicielle et le passage des paramètres se fait en utilisant les registres du processeur, la plupart des chargeurs d'amorçage étant écrit en assembleur, ce type d'opération est très facile à réaliser et permet de ne pas avoir à écrire un pilote pour disque-dur, ce qui est très appréciable quand on est limité en taille.Le stage2 est alors lancé. Celui-ci peut configurer plus largement la machine (disposition de la mémoire, mode de fonctionnement du processeur, clavier, écran…). Il peut présenter un menu pour permettre de choisir certaines options; et finalement il va récupérer les éléments de l'étape suivante: le noyau d'un système d'exploitation et un éventuel initramfs pour leur passer la main. (Note: Dans le cas de Grub, celui-ci dispose d'une étape intermédiaire, le stage1.5 qui permet de charger des drivers pour les différents systèmes de fichiers et évite d'avoir à réinstaller GRUB à chaque modification de la configuration)

Amorcer depuis le réseau

Pour amorcer la machine depuis le réseau, le principe général reste le même, mais, le BIOS n'ayant pas été conçu pour démarrer depuis une carte réseau, il est un peu détourné. La carte va embarquer une ROM d’extension qui sera mise à disposition du BIOS à une certaine adresse. Lors de l'étape du Power-On Self-Test, le BIOS va reconnaitre une séquence d'octets spécifiques indiquant la présence de l'extension. Cette extension de la carte réseau va s'enregistrer comme périphérique amorçable auprès du BIOS qui sera alors capable de démarrer dessus.

Cette ROM contient un micrologiciel qui est divisé en plusieurs modules :

- le premier est une pile PXE qui implémente une partie de la spécification PXE et dont le comportement sera détaillé plus bas;

- le second est une série de fonctions respectant l'API UNDI pour Universal Network Device Interface permettant d'utiliser la carte réseau sans avoir à fournir un pilote. Ces fonctions pourront être utilisées par la pile PXE et par le programme que celle-ci chargera.

Reprenons le processus de démarrage avec l'exécution de la pile PXE. Son objectif est de récupérer sur le réseau un Network Bootstrap Program (NBP) pour l'exécuter. Pour cela, il faut obtenir une adresse IP afin de pouvoir communiquer sur le réseau, puis localiser, récupérer et exécuter ce NBP. La spécification PXE adresse ces questions en faisant d'une pierre deux coups : le protocole DHCP est utilisé avec deux options particulières :

next-serveretfilename. DHCP est en effet un protocole flexible qui permet de spécifier de nombreux paramètres personnalisés, aussi bien dans la requête que dans la réponse. La norme PXE demande que dans la réponse, le serveur DHCP spécifie dans le paramètrenext-serverl'adresse IP d'un serveur TFTP et dans le paramètrefilenamele chemin du fichier NBP sur ce serveur. UNDI proposant dans son API un client TFTP, la pile PXE n'a plus grand-chose à faire, elle va charger le NBP en mémoire puis l'exécuter à son tour.Ici les choses varient en fonction du NBP choisi par l'utilisateur. Très souvent il s'agit de PXELINUX, qui fait partie du projet SYSLINUX et qui est en quelque sorte l'équivalent du stage2 de GRUB. Il est capable de chercher à son tour sur le serveur TFTP un fichier de configuration, puis un noyau et un initramfs.

iPXE

Historique du projet

Etherboot

Le projet Etherboot vu le jour en 1995, avant l'apparition de la spécification PXE donc, il avait pour but développer un microgiciel embarquable dans une ROM d'extension pour BIOS afin de permettre l'amorçage par le réseau, le principe est alors sensiblement le même que celui qui sera retenu par PXE plus tard, la différence principale entre les deux approches étant qu'Etherboot récupérait directement un noyau tandis que PXE passe par un NBP.

gPXE

En 1999, Intel publie la spécification PXE, la question de savoir si Etherboot doit abandonner son approche actuelle pour implémenter une pile PXE divise alors les développeurs du projet. Trois développeurs, Marty Connor, H. Peter Anvin et Michael Brown prennent alors la décision de forker le projet, donnant naissance à gPXE. Marty Connor en profite pour créer rom-o-matic.net qui permet de générer des images gPXE facilement et qui connaît un succès rapide.

Entre temps, le mainteneur d'Etherboot n'ayant plus de temps à y consacrer abandonne le projet qui est donc réintégré dans gPXE.

En 2006, gPXE participe à la seconde édition du Google Summer of Code, sous l'égide de la fondation linux, à cette occasion, une pile TCP complète est implémentée par un étudiant indien. gPXE participera à tous les Google Summer of Code suivant jusqu'en 2011.

iPXE

En 2011, un différend oppose Marty Connor et Michael Brown conduisant à un fork du projet par ce dernier et donnant naissance à iPXE, gPXE ne donnant plus de signe de vie depuis presque un an, il est considéré comme mort à l'heure actuelle.

En 2012, iPXE participe à la septième édition du Google Summer of Code, prenant la place de gPXE.

Utiliser iPXE

Il est possible, à partir des sources d'iPXE, de générer un grand nombre d'images différentes, chacune répondant à une utilisation précise du programme. Cette partie recense les utilisations les plus courantes et les images qu'il faudra utiliser.

Chainloading

iPXE peut être chargé depuis une implémentation de PXE existante, il faudra donc utiliser une image de type NBP, c'est le cas d'

undionly.kpxepar exemple. Il est également possible de charger iPXE depuis un autre chargeur d'amorçage comme GRUB ou LILO, dans ce cas de figure, une image de type bzImage est nécessaire, il faudra donc utiliseripxe.lkrn.Démarrer sur CD-ROM, disquette ou clé USB

Il existe également des images spécifiques chacun de ces supports,

ipxe.iso,ipxe.dsketipxe.usbpour l'amorçage depuis, respectivement, un CD-ROM, une disquette ou une clé USB.Flasher la ROM de sa carte réseau

Les plus téméraires d'entre vous pourront flasher la ROM de leur carte réseau afin de disposer d'iPXE de façon permanente. Ceci permet d'éviter le chainloading et économise donc une étape, sans parler du gain évident en sécurité si vous embarquez une clé privée dans iPXE : avoir une clé qui se balade en clair sur le réseau, ce n'est jamais une très bonne chose. Dans ce cas de figure, vous devez compiler une image de type

.romou.mromet il vous faudra connaître le pilote précis utilisé par votre carte réseau.Fonctionnalités

iPXE, en plus du respect de la spécification PXE, propose un grand nombre de fonctionnalités qui ne sont pas décrites par celle-ci.

Protocoles

Là où la spécification PXE ne se limite qu'aux protocoles TFTP et Multicast TFTP, iPXE intègre un certain nombre d'autres protocoles. Les plus utilisés étant bien sûr HTTP et FTP, mais sont également disponibles :

- Scalable Local Area Multicast protocol (SLAM) : un protocole conçu pour être plus efficace que Multicast TFTP et qui n'est à ma connaissance implémenté que dans iPXE.

- HTTPS : HTTP sécurisé qui offre un certain nombre de possibilités combiné avec l'intégration de certificats dans iPXE, voir la partie Cryptographie.

- iSCSI / AoE / FCoE : permet l'amorçage depuis un SAN, voir la partie Sanboot ci-dessous.

- NFS : implémenté cette année dans le cadre d'un Google Summer of Code par l'auteur de cette dépêche. Devrait être intégré dans la branche principale sous peu.

Sanboot

iPXE permet l'amorçage sur un SAN, il va procéder exactement comme le BIOS pour un amorçage sur disque classique, sauf qu'il va intercepter les interruptions utilisées pour demander la lecture de secteurs afin d'émuler un disque physiquement présent dans la machine. Le chargeur d’amorçage de la cible distante sera donc tout à fait capable de faire son travail et de charger un noyau. Pour poursuivre l'amorçage, il faudra bien évidemment que le système d'exploitation ait des pilotes chargés pour le protocole utilisé (iSCSI, AoE ou FCoE). Cette technique permet d'installer et amorcer des stations Windows sans disque.

Cryptographie

iPXE possède une implémentation de TLS, qui est utilisée pour le support d'HTTPS, et permet lors de la compilation d'embarquer une ou plusieurs Autorités de certification. Il est donc possible d'amorcer une machine avec des images téléchargées depuis l'Internet en toute sécurité. Si une autre solution qu'HTTPS est choisie, il est également possible de signer l'image et de demander à iPXE de ne la charger que si la signature est valide. Pour permettre l'authentification des clients, iPXE permet aussi d'embarquer un certificat et la clé correspondante.

Scripting

L'une des fonctionnalités les plus appréciables d'iPXE est probablement la possibilité qui est offerte de le scripter. En effet, il embarque un petit interpréteur qui, bien que rudimentaire, offre des possibilités que ne fournissent pas les autres chargeurs d'amorçage. Ces scripts peuvent être soit embarqués dans l’exécutable à la compilation, soit exécutés comme des images classiques.

La syntaxe ressemble beaucoup à du shell édulcoré, les boucles y sont absentes mais peuvent être construite à partir de

goto, de même pas d'instructionifmais une alternative un tout petit peu moins intuitive. Ces choix s'expliquent par le fait que l’interpréteur doit rester le plus petit possible, faisant partie du cœur du programme, il n'est pas possible de le désactiver à la compilation contrairement à la plupart des autres fonctionnalités.Le classique

hello world:#!ipxe echo Hello World!Un script qui demande à l'utilisateur d'entrer une valeur et envoie cette valeur ainsi que son adresse MAC à un serveur HTTP, ce script a été utilisé par l'auteur de cette dépêche à plusieurs reprises pour s’épargner le relevé fastidieux des adresses MAC d'une centaine de machines :

#!ipxe # Effectue une requête dhcp dhcp # Affiche "Nom de la machine : " et attends une entrée de l'utilisateur pour continuer, la valeur saisie est placée dans la variable 'name'. echo -n Nom de la machine : && read name # Exécute l'image renvoyée par le serveur HTTP tout en lui transmettant la saisie de l'utilisateur et l'adresse MAC de la machine. chain http://${next-server}/?name=${name}&mac=${mac}Une boucle qui effectue une requête dhcp tant qu'une réponse n'a pas été reçue :

#!ipxe # Déclare le label 'retry_dhcp' :retry_dhcp # Effectue une requête DHCP puis 'isset' teste si la variable 'filename' contient une valeur, ce qui est le cas quand une réponse DHCP valide à été reçue. # Si 'isset' renvoie faux, le goto nous renvoie au début du script. dhcp && isset ${filename} || goto retry_dhcp # La commande 'chain' télécharge l'image dont l'URI est passé en paramètre et l’exécute. chain ${filename}iPXE embarque aussi un shell où toutes ces commandes, à l'exception de

goto, sont disponibles.Menu graphique

Si PXELINUX et GRUB offrent la possibilité d'afficher des menus depuis longtemps, l'implémentation de cette fonctionnalité dans iPXE date seulement de quelques mois. Contrairement à ce que l'on peut trouver ailleurs, il n'y a pas de fichier de configuration pour décrire le menu, il faut utiliser le langage de script intégré à iPXE et en particulier les commandes

menu,itemetchoose.Un exemple simple :

#!ipxe menu item linux Boot Linux item shell Enter iPXE shell item exit Exit to BIOS # Affiche le menu à l'utilisateur et place le nom de l'élément choisi dans la variable 'target' choose --default exit --timeout 3000 target && goto ${target} :linux # Amorce sur Linux chain ftp://${server}/bzImage :shell # Propose un shell iPXE à l'utilisateur shell :exit # Termine la session iPXE exitL'affichage d'un menu plus complet, avec des séparateurs :

DNS

Contrairement à une implémentation classique de PXE, iPXE est capable de comprendre des URI passé par l'option DHCP

filename, dans cet URI, la cible peut être un nom de domaine. Afin de pouvoir les résoudre, iPXE intègre un petit client DNS. Ceci ouvre un certain nombre de possibilités, comme la répartition de charge par round-robin DNS qui est particulièrement utile quand on veut amorcer un très grand nombre de machines.VLAN

Enfin, iPXE est capable de configurer une interface comme un VLAN trunk c'est à dire qu'il peut générer des interfaces virtuelles, une pour chaque VLAN, qui se retrouveront sur des segments Ethernet différents. Pour que ceci fonctionne, il faut bien sûr que la machine soit reliée à un commutateur capable de comprendre le protocole IEEE 802.1Q.

Alternatives à iPXE

Je ne connais pas d'alternative libre à iPXE en tant que microgiciel embarquable, en revanche il existe d'autres chargeurs d'amorçage qui peuvent être utilisés comme NBP :

- PXELINUX du projet SYSLINUX

- pxegrub du projet GRUB

-

Agility Training - Un site internet pour créer et partager des parcours d’agility

(Dépêches LinuxFR)

Agility Training est un site internet permettant aux utilisateurs de créer et partager des parcours d’agility : http://agility-training.fr/fr/.

L'agility consiste à réaliser un parcours composé d'agrès avec son chien. Les agrès sont divers : saut, passerelle, tunnel… Le maître doit guider le chien afin qu'il réalise le parcours. Cette discipline est connue pour créer une grande complicité entre le maître et le chien.

- lien n°1 : Agility Training

- lien n°2 : Le dépôt du code source

- lien n°3 : Définition de l'agility sur Wikipedia

- lien n°4 : Des vidéos d'agility sur youtube

source de l'image: WikipediaLa discipline est de plus en plus populaire, il y a de plus en plus de compétiteurs et de concours. Les compétiteurs créent régulièrement de nouvelles méthodes d'entraînement et de nouveaux parcours. C'est ce dernier point qui nous intéresse.

Tous les jours de nouveaux parcours sont créés et partagés sur Internet, le partage se fait par le biais d'un fichier image qui est un dessin du parcours. L'idée est donc de créer un site internet permettant de créer des parcours en ligne, de les partager, les modifier et permettre de faire des recherches.

La première étape consistait à permettre la création et le partage d'un parcours. C'est aujourd'hui fini et utilisable sur le site internet Agility-Training.

La seconde étape va consister à permettre la recherche dans la bibliothèque de parcours, allant de la recherche par nom ou par tag jusqu'à la recherche sur des critères tels que le nombre d'obstacles. Beaucoup de personnes possèdent des obstacles chez eux à la maison mais sont limités ( 3 sauts, 1 tunnel, …), il est donc intéressant de leur permettre d'utiliser ce type de critères lors des recherches.

Informations techniques

Le site internet est écrit en Python avec le framework Django. L'éditeur de parcours est écrit en Javascript. Le code source et les médias sont sous licence Apache Version 2.

Le site internet Agility-Training est exactement le code disponible sur github, vous pouvez donc allez dessus pour voir l'application.

-

Microcontrôleur de DEL basé sur ESP8266

(Dépêches LinuxFR)

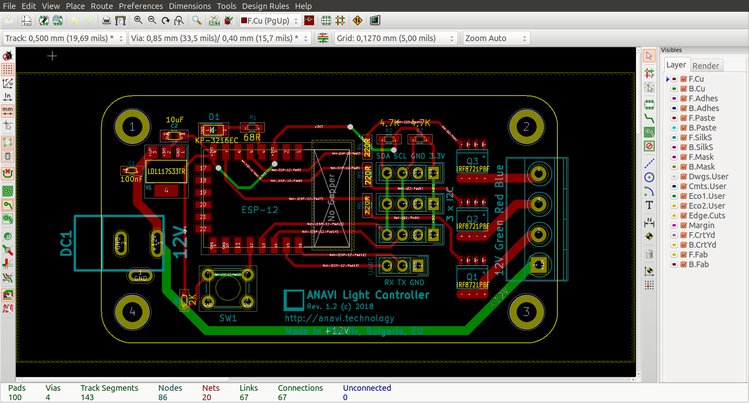

ANAVI Light Controller est une nouvelle carte matérielle libre pour contrôler un ruban de DEL (LED strip RGB). Ce projet est libre et conçu avec KiCAD, et disponible à l’achat à partir de 25 € jusqu’au 27 juin 2018.

La carte peut être utilisée de façon autonome avec le logiciel embarqué de démo en se connectant sur une page Web (MQTT d’Eclipse Paho). Mais passer par Internet via un broker MQTT public n’est peut‐être pas idéal pour tous, donc une autre solution est tout aussi envisageable via une passerelle locale (et optionnellement accessible à distance).Naturellement, ce microcontrôleur (MCU) ESP8266 peut être aussi reprogrammé, c’est une alternative intéressante aux populaires Arduino car un bloc Wi‐Fi (pas libre ?) est intégré au MCU.

- lien n°1 : Commander l’ANAVI Light Controller sur Crowd Supply

- lien n°2 : Vidéo de démo avec Mozilla Web Things

Pour ma part, j’ai eu la chance de tester le produit, ça fait le job comme on dit ! Mais je vous invite à lire la revue en français sur le blog Framboise314.

Pour utiliser une passerelle locale, il faut préalablement installer Mozilla IoT Gateway sur Raspberry Pi et reprogrammer le MCU avec mon implémentation de RGBLamp qui utilise l’API WebThings de Mozilla se connectant ensuite via mDNS, HTTP, REST (voir vidéo)…

Pour ceux qui ne veulent pas faire un pas hors de leur système d’exploitation préféré, considérez le précédent produit de Léon pour Raspberry Pi.

Finalement, si vous utilisez Mozilla IoT, les retours sont bienvenus.

Commentaires : voir le flux atom ouvrir dans le navigateur

-

Comment taper les accents sur un clavier QWERTY?

(Journaux LinuxFR)

Tout lien avec mon journal d'hier serait bien entendu purement fortuit.

Comment taper les caracteres accentues sur un clavier QWERTY standard sans (trop) se casser les cHpieds?

On m'a propose "setxkbmap fr" mais franchement je ne me rappelle plus trop bien la disposition fr. En plus, cette disposition n'offre meme pas tous les caracteres speciaux (comme l'e-dans-l'o et les caracteres accentues majuscules).

On m'a aussi propose des outils d'accentuation automatique, mais cote grammaire ils en sont a peu pres au niveau CP.

Ce qui me conviendrait bien, ca serait une touche "compose". Par exemple, compose+apostrophe+e = é

Y a-t-il une telle solution, pas trop difficile a mettre en oeuvre, sous linux+x11 ?

-

Sauvegarde incrémentiel de container lxc sous proxmox

(Journaux LinuxFR)

Introduction

Proxmox c'est bon, c'est libre et ça marche bien.

Par contre il a une faiblesse, ce sont les sauvegardes.

Ils vous pond un gros .lzo par sauvegarde, certes on dit dans l'espaces de sauvegarde combien nous voulons garder de sauvegardes, et

il effacera les vielles sauvegardes.C'est suffisant pour des petits containers ou vm par exemple, mais pour un gros container ça ne va pas le faire.

Ma solution

Description de ma situation

Pour faire simple prenons mon cas.

J'ai une instance de proxmox qui tourne dans ma cave, dessus il n'y a que des containers lxc, j'ai quelques petits containers et un gros qui s'appelle NAS et qui fait dans les 300Go.

Mais le problème c'est mon NAS. Dedans il y a toutes notre musique, toutes nos photos/vidéos, bref toute notre vie, qu'il faut bien sauvegarder.

Par contre je me vois mal me prendre 300Go par nuit, ma machine de sauvegarde va vite être saturée.A côté du serveur il y a un petit serveur (un vieux microcube proserv d'hp), il a 4 disques de 2to en raid 5. Dessus tourne une debian qui offre un partage nfs

au proxmox.

J'ai également une instance de rsnapshot sur mon hp qui sauvagarde le contenu de mon container NAS.Cela fonctionne bien, mais je me suis dit si je pouvait prendre tous le container par passage de rsnaphot, histoire que si un jour le proxmox casse il n'y aurait plus qu'a recopier l’intégralité du contenus sur le nouveau proxmox (ça marche j'ai fait le test avec un container d'essai le week-end passé).

Ce qui est cool c'est que avec rsnapshot on peut remplacer les sauvegardes de proxmox pour les containers (attention que ceux qui sont dans des rpool zfs ou dans des lv de lvm).

Un bout de mon fichier de configuration

Comme c'est plus facile avec un exemple, voici un bout de mon fichier de config qui permet de sauvegarder un container, au préalable il faut que la machine de sauvegarde puisse se connecter au proxmox en ssh avec identification par clé.

Dans l'exemple notre container est le 202 et l'adresse du proxmox est 192.168.2.190

Dans le fichier de configuration il vous faut passer ce argument sinon il risque d'être bizarre votre container avec le temps qui s'écoule.rsync_long_args --deleteen ZFS

La section pour la sauvegarde du container 202:

#NAS backup_exec ssh root@192.168.2.190 "zfs snapshot rpool/data/subvol-202-disk-1@backup" backup root@192.168.2.190://rpool/data/subvol-202-disk-1/.zfs/snapshot/backup/ nas-202/ backup_exec ssh root@192.168.2.190 "zfs destroy rpool/data/subvol-202-disk-1@backup"C'est vraiment simple après il faut pas oublier de prendre les fichiers de configuration de votre container sur l'hyperviseur, mais à la limite vous en foutez vous recréer un container avec la même id et même capacité de disque et vous passer la commande rsync dans l'autre sens.

Voilà vous avez des sauvegardes incrémental de vos containers et si vous avez un mysql dedans il devrait pas y avoir de problème vu que vous copiez un snapshot.

en LVM

Si vous avez vos containers dans des lv sous lvm ça marche aussi, voici un exemple que vous pouvez adapter à rsnapshot, je l'ai pas encore adapté mais j'ai testé les commandes à la main sur la grappe de proxmox de mon employeur.

lvcreate -n backup-308 -l 10%ORIGIN -s /dev/pve/vm-308-disk-1 mount /dev/pve/backup-308 /snapshots/308 rsync ... umount /snapshots/308 lvremove -f /dev/pve/backup-308Pour les VM ? Je n'ai pas encore penché la dessus, si quelqu'un à une idée.

-

Du reverse tethering sur Android (sans root)

(Dépêches LinuxFR)

Je vous présente un outil que j’ai développé, qui permet aux appareils Android d’utiliser la connexion du PC sur lequel ils sont branchés. On appelle ça du « reverse tethering ».

Je l’ai appelé gnirehtet (

rev <<< tetheringen bash).Il ne nécessite pas d’accès root, que ce soit sur le téléphone ou sur le PC. En revanche, il nécessite Java 8 et les Android tools (adb).

- lien n°1 : Journal à l’origine de la dépêche

- lien n°2 : Projet sur GitHub

- lien n°3 : Page développeurs

- lien n°4 : Présentation en français

- lien n°5 : Présentation en anglais

- lien n°6 : Reddit

- lien n°7 : Hacker News

Comment l’utiliser ?

Il suffit de télécharger la dernière publication, de l’extraire et d’exécuter la commande suivante sur le PC :

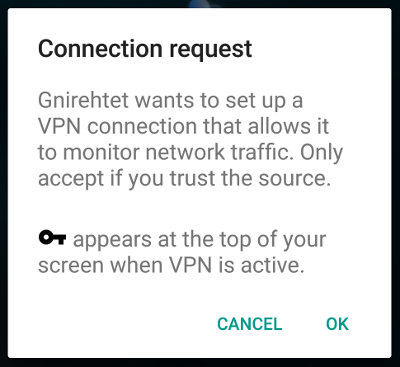

./gnirehtet rtLa première fois, Android demande une confirmation :

Une fois activé, un logo en forme de clef apparaît dans la barre de statut du téléphone :

Pour l’arrêter :

Ctrl+C.Le fichier README donne plus de détails.

Comment ça marche ?

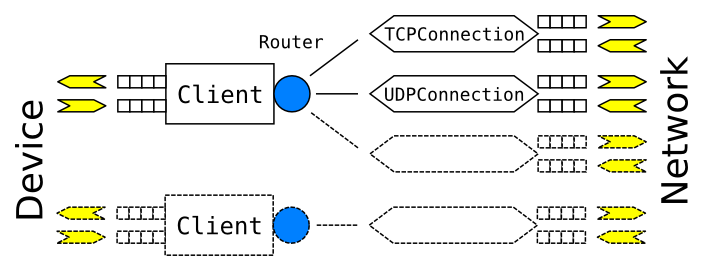

Très succinctement, l’application s’enregistre en tant que réseau privé virtuel (VPN) pour intercepter tout le trafic réseau du téléphone, qu’il transmet à un serveur tournant sur le PC, qui ouvre les connexions et relaie le contenu dans les deux sens.

Voici un beau dessin pour faire joli (c’est l’architecture du serveur relais) :

Vers l’∞ (et au‐delà)

Notez qu’il est possible d’activer en même temps le tethering (de manière à ce que le PC utilise la connexion du téléphone), et le reverse tethering (pour que le téléphone utilise la connexion du PC). Ne faites pas ça ! :D

En parlant d’infini (même si ça n’a rien à voir), savais‐tu, cher journal, qu’une boucle infinie était un undefined behavior (Ah bon, pourquoi ? Quel rapport avec le dernier théorème de Fermat ?) ?

-

Un décalage de 64 bits, ça vous inspire comment ?

(Journaux LinuxFR)

Salut à tous,

après l'excellent journal d'Anaseto sur le fameux "1+3a", un pote à moi, prof de maths à L'INSA de Rouen, m'a demandé de faire ce petit journal après une "découverte" faite par ses étudiants.

Ceux-ci écrivant des tests unitaires en Free Pascal sont tombés sur un comportement non documenté qui nous a amené à nous poser la question du "comment ksa fait sur les autres langages" :)Le problème

Le problème vient de l'opérateur de décalage de bits à droite.

Si je prend un entier initialisé à 1, le décalage d'un bit vers la droite retourne 0. Si l'on décale de 2 bits, on s'attend à avoir 0… Et c'est toujours le cas.

Par contre, le code suivant ne retourne pas 0program beBitwise; var a, b: integer; begin a := 1; b := a >> 64; (* la, on s'attend normalement à obtenir un 0 *) writeln('Valeur de b ', b ); end.Le code retourne 1 à savoir a.

Si l'on remplace 64 par 63 ou 65, on obtient bien 0.

Bien sûr, sur une machine 32 bits, on obtient le même comportement avec un décalage de 32 bits.Si le comportement peut s'expliquer, le fait que le compilateur ne prévienne pas du risque et qu'aucune documentation ne le spécifie est un poil gênant.

Résultat, les étudiants sont en train de remplir un rapport de bug pour Free Pascal, ne serait-ce que pour que le comportement soit documenté quelque part.

Et chez les autres ?

En C/C++

#include <iostream> using namespace std; int main(int argc, char** argv) { unsigned long long a = 1; unsigned long long b = a << 64; cout << "b vaut " << b << endl; }Au moins, le compilateur GCC nous prévient du problème en affichant le warning si on travaille en statique

shift.cpp: In function ‘int main(int, char**)’:

shift.cpp:8:31: warning: left shift count >= width of type [-Wshift-count-overflow]

unsigned long long b = a << 64;En Java

public class Shift { public static void main(String[] args) { int a = 1; System.out.println("Resultat : " + (a >> 64)); } }Même punition et surtout pas de warning.

En Ada

Vous n'y couperez pas, je vais forcément donner un exemple en Ada

with Interfaces; use Interfaces; with Ada.Text_Io; use Ada.Text_Io; Procedure Shift is begin Put_Line("Resultat " & Unsigned_64'Image(Shift_Right(Unsigned_64(1), 64))); end Shift;Là, pas de message d'erreur ni de warning mais au final pas d'erreur non plus, le résultat est bien 0.

En OCAML

Il s'agit juste d'une ligne de commande dans l'interpréteur:

# open Int64;; # shift_right one 64;; - : int64 = 1L #J'avoue que je ne m'attendais pas à ce résultat mais OCAML retourne lui aussi 1 en lieu et place de 0.

En Python

>>> 1 >> 64 0Ce qui est normal pour un langage typé canard ;)

Que disent les docs ?

Le reproche que l'on peut faire à Free Pascal, c'est justement de ne rien dire quant à ce fonctionnement.

Par contre, si l'on prend OCAML, la documentation du module Int64 précise que le comportement est non spécifié.