Linux (fr)

-

Colortest.it - simuler le daltonisme avec des filtres CSS SVG

(Journaux LinuxFR)

Sommaire

Chers et chères camarades, trichromates ou pas, bonsoir,

Depuis assez longtemps je cherche un moyen de tester l'accessibilité de sites ou de graphiques aux daltoniens. Il existe un certain nombre de sites qui proposent ce genre de service, mais aucun qui m'ait convaincu. J'avais déjà tenté de mettre en place moi-même un tel service il y a des années, mais les technologies du web ne permettaient pas à l'époque de faire ce la. Les choses ont changé aujourd'hui, en particulier grâce à CSS3.

Bon… je vois que c'est bien long, alors si vous avez la flemme allez directement à la fin ou bien allez juste faire un test sur le site en question, colortest.it

Ce qui existe

Etre Colsim http://www.colsim.com

Pour commencer le service est payant, et 1,20€ la page web ou l'image testée, ça fait un peu cher.

Il fonctionne avec un form à soumettre, et on reçoit les images simulées par email, autant dire que c'est râpé pour tester un site avec des éléments interactifs, et j'imagine qu'il faut oublier tout le contenu généré en JavaScript. Je ne l'ai pas testé, parce que je ne veux pas payer.Coblis http://www.color-blindness.com/coblis-color-blindness-simulator/

Ce simulateur est assez bon, il semble reproduire précisément les couleurs perçues et fournit même un lien vers les matrices de transformation des couleurs (dommage que le lien soit down depuis longtemps maintenant).

Malheureusement, il ne fonctionne qu'avec les images, et de moins de 600 ko. Impossible donc de tester un site facilement.Chromatic Vision Simulator http://asada.tukusi.ne.jp/cvsimulator/e/

Une application Android/iOS. Si j'ai bien compris, elle applique la simulation à ce que voit la caméra de l'appareil, ou éventuellement à une image statique. Une version web est disponible, et c'est ce qu'elle propose (le navigateur doit supporter WebGL).

Toujours pas de support des sites web dynamiques, à moins de filmer un écran d'ordinateur pendant qu'on utilise le site.ColorBlindness SimulateCorrect https://play.google.com/store/apps/details?id=com.SeewaldSolutions.ColorBlindnessSimulator

Une application Android qui fait la même chose, mais qui propose aussi de corriger les couleurs pour les daltoniens (je reste dubitatif devant la possibilité technologique de faire ça, mais n'étant pas daltonien moi-même je ne peux pas réellement juger).L'extension Firefox que j'avais testée a semble-t-il été supprimée par son auteur.

Vischeck http://www.vischeck.com/vischeck/vischeckURL.php

Le seul service gratuit permettant la simulation d'un site, mais apparemment il est maintenant down.

Je ne me souviens plus trop à quel point il fonctionnait, mais il ne supportait pas la simulation sur les<canvas>

Ce que je cherche

Peut-être n'êtes-vous pas sans savoir qu'un de mes loisirs est la création de graphiques divers, en voici une petite sélection :

* http://ssz.fr/bac/ Résultats du Bac 2013, moyenne par département

* http://ssz.fr/subventions/ Utilisation de la réserve parlementaire 2011

* http://ssz.fr/finances/ Résultat comptable 2011 par commune, en euros par habitant

* http://ssz.fr/presidents/ Chefs de l'état et chefs du gouvernement français depuis 1800

* http://ssz.fr/vaches/ Population de la France en porcs, vaches, humains, moutons et chèvres

* http://ssz.fr/eez/ Rapport ZEE/superficie des pays du mondeVoilà donc des graphiques qui sont pour certains en SVG, pour d'autres en

canvas, tous générés en JavaScript (je ne suis pas responsable de l'éventuel plantage de votre navigateur /o/). Certains dépendent directement de la vision des couleurs pour être lisibles, d'autres non grâce à plusieurs techniques.Dans tous les cas, il est rapidement évident que les services précédemment cités ne sont d'aucune utilité pour tester l'accessibilité de ce type de graphiques.

L'autre possibilité est de montrer les graphiques sur la tribune et d'attendre les retours, mais les daltoniens eux-mêmes ne sont pas les mieux placés pour tester l'accessibilité d'un site puisqu'ils ne savent justement pas forcément ce qu'ils ne peuvent pas distinguer !

Ce qui est possible

Je me suis donc mis en quête d'un système qui permettrait de tester tout ça facilement, rapidement, en même temps que je développerais mes sites ou graphiques.

La façon la plus courante de modifier les couleurs d'un site semble être de le proxyfier et de modifier au passage les valeurs de couleurs dans les styles, mais cela pose problème à plusieurs égards :

Il est impossible par cette méthode de toucher aux couleurs des<canvas>à moins de modifier sans discrimination toutes les références à des couleurs dans le code - et même là, difficile de remplacer "red" ou "teal" sans risquer de modifier du texte important, sans compter les couleurs générées à partir d'échelles dans d3js.L'autre façon est évidemment de faire un rendu de la page et d'appliquer les modifications idoines à l'image résultante, au prix de la perte de l'interactivité. Même si les sites qui tentent de faire ça échouent souvent lamentablement, il suffirait d'utiliser PhantomJS pour avoir un rendu tout à fait correct, y compris des

canvaset du SVG. Seulement, c'est lourd et très peu pratique pendant le développement.Je me suis donc tourné vers les filtres CSS SVG :

Parmi les filtres SVG se trouve le filtrefeColorMatrixqui permet d'appliquer une matrice de transformation aux couleurs. Exactement ce que je veux !Après avoir créé la matrice, il suffit d'appliquer le style

filter: url(#id-du-filtre)à l'élément dont je veux ajuster les couleurs. Contre toute attente, aucun navigateur ne restreint l'application d'un tel filtre à une<iframe>, il ne reste donc qu'à afficher dans une iframe le site à tester, et tout se passe tout seul.Il y a bien deux ou trois inconvénients :

- Le plus important, une matrice de transformation n'est pas vraiment assez puissante pour simuler précisément le daltonisme. La vision humaine est plus complexe qu'une simple transformation linéaire de valeurs RVB, les capteurs ont des plages de réception complexes, qui se chevauchent. Des méthodes existent pour faire ces calculs de manière précise, mais d'après ce que je comprends des résultats que j'ai eus les navigateurs ne calculent pas les couleurs avec une précision suffisante pour les mettre en application.

- Les performances, bien qu'acceptables, ne sont pas exceptionnelles. Elles dépendent beaucoup du site affiché, par exemple on peut tester des vidéos mais elles rament un petit peu, ou du SVG interactif mais là aussi les performances ne sont pas au top.

- Certains sites refusent de s'afficher dans une

<iframe>, en particulier les sites de Google. C'est légitime, il y a même un header HTTP spécifique pour ça (x-frame-options: SAMEORIGIN) et je ne peux rien y faire (bien qu'il reste possible de passer par un deuxième site servant de proxy, disons Proxfree par exemple, pour tester une vidéo sur Youtube). - L'iframe empêche le site de savoir ce qu'il se passe à l'intérieur de l'iframe, impossible de donc de mettre à jour l'url comme dans une vraie barre d'adresse lorsqu'on clique sur des liens à l'intérieur.

Au final, la solution des filtres CSS SVG reste satisfaisante malgré ces petits défauts (et c'est surtout la seule solution viable).

L'autre option, qui me semblait prometeuse, se basait sur les WebGL custom filters, mais WebGL a l'inconvénient de ne pas fonctionner partout, et de toute façon… après une courte période de test sur Chromium, ces filtres ne sont plus supportés par aucun navigateur aujourd'hui.

Ma solution

Bref, après ce pâté de texte, que j'espère vous avez lu sans rien sauter, vous avez le droit au lien vers mon site de simulation de daltonisme, et n'hésitez pas sur les rapports de bug :

En plus de simuler les trois types de daltonisme les plus courants, le menu à gauche de la barre d'adresse propose deux entrées, "enhance green" et "enhance red", qui peuvent aider les daltonien à distinguer les dégradés ou autres graphiques qui vont du vert au rouge. Ces filtres transforment respectivement le vert ou le rouge en bleu, que la plupart des daltoniens voient distinctement, en laissant l'autre canal tel qu'il est.

-

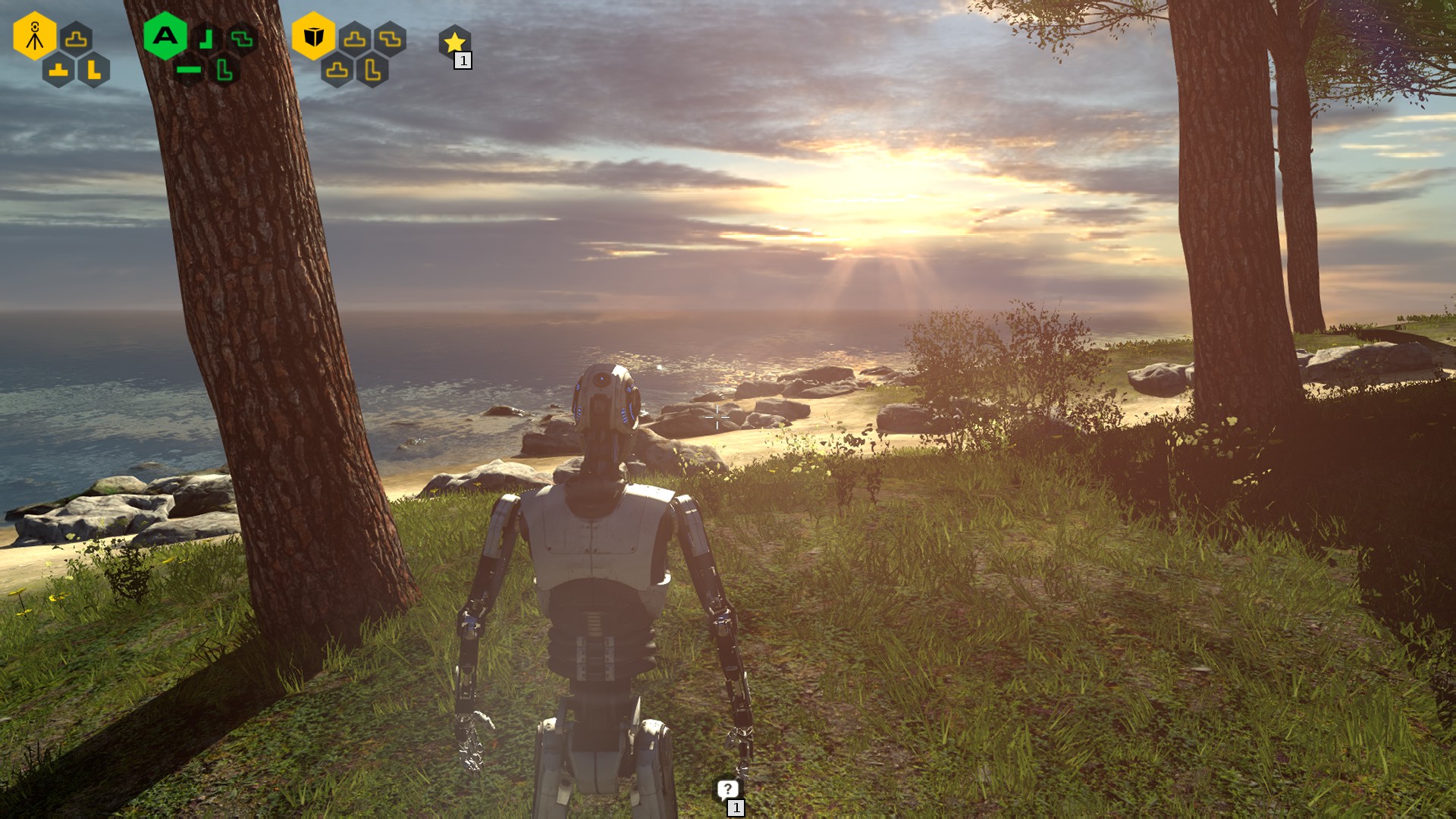

Jeu sous linux : The Talos Principle

(Journaux LinuxFR)

Bonjour,

Afin de faire revenir cet espace de discussion vers son but principal, parler de Linux, je me propose de vous présenter un jeu que j'ai beaucoup apprécié récemment (le jeu a plus de deux ans).

Qu'est ce que c'est ?

C'est un jeu propriétaire disponible sous Steam sous Linux, Windows et Mac OS et sorti en décembre 2014 et développé par le studio croate Croteam.

On peut le ranger dans la catégorie "First Person Puzzler". En gros, on se balade avec son avatar dans un monde en 3 dimensions, et on y résout des énigmes principalement à base de faisceaux lasers qu'il faut envoyer à certains endroits. Ça ressemble un peu à Portal, mais l'ambiance et les énigmes sont vraiment différentes.

Le prix est d'environ 40 €, mais il est régulièrement en réduction, et est trouvable chez d'autres revendeurs beaucoup moins cher.

Prérequis

En plus de Steam pour pouvoir y jouer, il faut du hardware pas trop ancien sans pour autant être à la pointe de la technologie (Minimum 2 Go de RAM, 4 Go, c'est mieux, dual core et une carte graphique pas trop vieille).

Comment on y joue ?

On se déplace dans un monde semi-ouvert composé d'un hub principal, relié à trois sous hubs, eux mêmes reliés à 7 zones.

Chaque sous-hub possède un thème particulier (la Rome antique, l'ancienne Égypte et le moyen-âge). On peut se déplacer librement dans chaque zone, qui est composée de plusieurs énigmes à résoudre. Il n'y a pas d'obligation à faire toutes les énigmes, il suffit d'en avoir réussi un certain nombre pour pouvoir avancer.Il n'y a pas de combat. Pour résoudre les énigmes, il faut porter des objets d'un endroit à un autre, actionner des interrupteurs, connecter des faisceaux lasers… La courbe de progression est bien faite et chaque nouveau concept est bien amené, il y a du challenge pour les bons joueurs.

Vu qu'il n'y a pas d'obligation de résoudre toutes les énigmes, on peut tout à fait passer à la suivante en cas de blocage et y revenir plus tard, une fois que l'on aura mieux assimilé certains concepts de jeu.

Le jeu est plutôt beau, et se déplacer dans les décors des différentes zones est quelque chose de très reposant.

De plus, le fait qu'il y a énormément de défis cachés et d'easter eggs pousse au fait de vraiment parcourir chaque niveau en entier, et pas juste aller d'une énigme à une autre. Certains de ces défis peuvent être très difficiles et réussir le jeu à 100% sans aide extérieure est un vrai challenge.

En plus de son côté énigmes à résoudre et monde à explorer, il y a toute une dimension philosophique intéressante, autour de qu'est ce que la vie, qu'est ce que la conscience… Cette partie est tout à fait optionnelle (on interagit alors avec des terminaux disséminés dans le jeu) et est très bien amenée.

Pourquoi j'ai aimé ce jeu ?

C'est un jeu à la fois facile dans le concept, mais pouvant demander de beaucoup réfléchir pour résoudre certaines énigmes. De plus, chaque énigmes pouvant être très courte (quelques minutes max une fois que l'on a trouvé comment faire), il est possible de faire quelques parties rapides.

Le côté aussi très relaxant de la musique et des décors est aussi quelque chose de super en fin de journée. Tu n'as pas de pression du jeu, et donc tu peux te détendre.

Que vaut Road to Gehenna ?

J'ai récemment acheté le DLC appelé Road to Gehenna. C'est le premier DLC que j'ai acheté de ma vie. Au final, je ne le regrette pas. Je ne le conseille qu'aux joueurs ayant facilement terminé le jeu de base car il est beaucoup plus dur (dédicace spéciale à l'étoile située au milieu du lac dans la zone égyptienne), et nécessite des connaître tous les concepts. Par contre, il raconte une histoire vraiment différente, et également intéressante.

Comment j'ai découvert ce jeu ?

Cela fait maintenant plus d'un an que je me suis abonné à Humble Monthly. C'est un bundle de jeu mensuel créé par Humble Bundle. On l'achète 12$ alors que l'on ne connaît qu'un seul jeu du bundle, et le premier vendredi de chaque mois, on découvre le contenu (6 à 8 jeux souvent). Bien qu'il n'y a rien de figé dans le marbre, j'ai toujours eu des jeux pour linux. Ce jeu faisait parti du bundle de Janvier 2016.

Conclusion

Si vous aimez vous creuser les méninges et jouer à des jeux propriétaires sous steam ne vous rebute pas, je vous conseille de jouer à the talos principle. Si vous trouvez que ce journal fait publi-reportage, je suis désolé de vous apprendre que je n'ai aucun lien avec Steam, Croteam ou Humble bundle.

Si vous aussi, vous avez découvert un bon jeu sous linux, n'hésitez pas non plus à venir nous en parler, je suis tout intéressé, même si j'ai plus d'une cinquantaine de jeux encore à commencer/finir.

-

Pimp my FnacBook

(Journaux LinuxFR)

Cher Journal,

Je t'écris pour la première fois en ce beau jour de Noël pour te parler du cadeau que j'ai trouvé ce matin dans mon petit soulier: un FnacBook, c'est à dire un livre numérique, aka: une liseuse. Ma première réaction fut de m'asseoir en face du père Noël, qui s'était arrêté pour prendre un café, et de lui dire que non, décidément, je n'ai pas l'usage d'un livre numérique. J'ai beau lire beaucoup, je ne vois pas comment un appareil électronique, donc fragile, et qui fonctionne sur batterie pourrait remplacer un livre en papier, que je considère comme un objet absolument parfait, du moins pour l'usage que j'en ai. Le père Noël me dit de réfléchir et repartit par la cheminée.

A l'heure qu'il est, je n'ai donc pas encore déballé mon FnacBook et je me renseigne sur les détails techniques de la bête. Et LÀ, je dois dire que je suis épaté par ce que je vois sous le capot :

1) GNU/Linux

2) Papier électronique

3) Carte micro SD

4) Accéléromètre

5) Wifi

(et roulements de tambours)

6) Carte SIM GPRS/EDGE/3G (réseau SFR)

Je précise qu'il n'y a aucun abonnement lié à la carte SIM. Mon premier réflexe, c'est donc de me demander si je peux installer un navigateur sur la bête ? Car rends-toi bien compte, cher Journal, des capacités qu'offrirait un tel système : on parle là d'avoir un accès internet illimité pour zéro euro, sur un écran à encre électronique qui tient dans la paume de la main avec une autonomie de quinze heures (ok, je fantasme sur l'autonomie annoncée de l'appareil, qui ne prend probablement pas en compte la connexion 3G).

Bon, en gros : soit je parviens à trouver une manière de modifier l'UI et l'OS pour utiliser un navigateur, soit je rends la bête au magasin. Journal, qu'en penses-tu ? Est-ce que ce projet te paraît réalisable ? -

HS - carte d'identité et empreinte de l'index gauche

(Journaux LinuxFR)

Bonjour tout le monde,

Ma carte d'identité arrivant à expiration je suis allé la faire renouveler.

Je remplis le formulaire, donne le justificatif de domicile et les photos (faut pas sourire , bien être au centre, etc.) je donne tout à la dame et là, elle me demande de faire une empreinte de mon index gauche !

Je n'étais pas au courant qu'il fallait donner une empreinte, je ne vous cache pas mon étonnement.

J'ai trouvé ça assez choquant d'avoir un petit bon de moi sur ce formulaire.

bref je l'ai fait quand même. Bin ouai faut bien avoir des papiers !Au final maintenant je me sens moins libre qu'hier et j'ai plein de question en tête :

- a-t-on le droit de refuser de donner ses empreintes ?

- cette empreinte sera utilisée dans quel but ?

- a-t-on un droit de regard sur ce qui est fait avec notre empreinte ?

- jusqu'où ça va aller avec ce fichage (à quand le prélèvement d' ADN ?) ?

- on fait comment quand on n'a plus d'index gauche ?

bref je voulais savoir si je suis le seul à ne pas apprécier devoir filer une empreinte ou est-ce que je commence a être un vieux con qui fait chier son monde à pas vouloir être fiché comme tout le monde ?

-

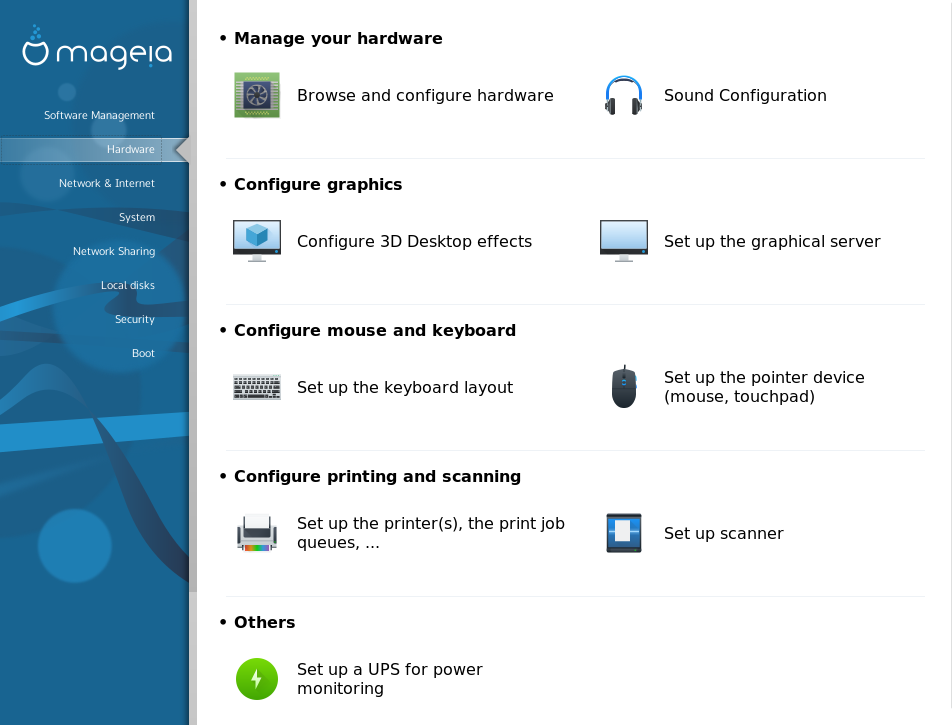

Mageia 6 est sortie

(Dépêches LinuxFR)

La très attendue Mageia 6 est enfin disponible. Des problèmes de compatibilité avec des périphériques pas très libres — mais très utilisés — sont la cause principale de ce retard.

En attendant cette sortie, la communauté des développeurs avait publié la robuste version 5.1 qui sera maintenue pendant encore trois mois. L’enjeu était de faire mieux et d’éviter les régressions.

De nombreux testeurs utilisent au quotidien cette version depuis la parution de la version candidate. Elle semble tenir toutes ses promesses :

- passage à Wayland par défaut pour GNOME (X.org reste disponible) et vous pouvez l’essayer avec KDE Plasma ;

- ajout du média autonome (live) avec l’environnement Xfce, aux côtés des classiques KDE Plasma et GNOME, le tout sous GRUB 2 remplaçant de GRUB 1 ;

- ajout de

dnf2en tant que gestionnaire de paquetages alternatif au classiqueurpmiet de l’interface graphique dnfdragora en plus du classique rpmdrake ; - prise en charge d’AppStream pour ajouter des méta‐données aux outils comme GNOME Logiciels (GNOME Software) et Plasma Discover pour découvrir des logiciels à installer ;

- retour de la portabilité sur processeur ARM (pour les plus aventureux).

- lien n°1 : Annonce de la sortie de Mageia 6

- lien n°2 : Miroirs pour télécharger Mageia 6

- lien n°3 : Les nouveautés de cette version Mageia 6

- lien n°4 : Les errata de Mageia 6 pour gérer les problèmes connus

- lien n°5 : Documentation d’installation de Mageia

- lien n°6 : Les forums d’entraide de Mageia Linux Online (MLO)

Sommaire

- Les nouveautés principales de Mageia 6

- Dans le détail des nouveautés de Mageia 6

- Mageia 6 pour l’architecture ARM

- Participer à l’activité de Mageia et de sa communauté

Les nouveautés principales de Mageia 6

Bien qu’il ne s’agisse pas d’une nouvelle fonctionnalité, Mageia 6 prend en charge plus de 25 environnements de bureau et gestionnaires de fenêtres (les détails seront disponibles lors d’une prochaine publication sur le blog) ! Que ce soit KDE Plasma 5.8.7 (LTS), GNOME 3.24.2, MATE 1.18, Cinnamon 3.2.8, Xfce 4.12.1, LXQt 0.11…

KDE Plasma

Le passage de Qt 4 à Qt 5 permet d’alléger notablement KDE Plasma, que l’on ne peut plus qualifier de lourd.

Presque toutes les applications KDE 4 ont été migrées vers Plasma, de sorte que vous bénéficierez d’une belle expérience unifiée.GNOME

Le serveur d’affichage Wayland est activé par défaut, l’utilisation de X.Org reste possible au besoin, si votre matériel est défaillant. Sur les processeurs graphiques Intel (voire AMD et sans doute NVIDIA), l’interface HDMI est gérée de base pour envoyer la vidéo vers un écran LCD ; le Bluetooth aussi, pour envoyer l’audio sur votre chaîne Hi‐Fi.

Les extensions GNOME Shell les plus classiques sont disponibles en paquets de base : hibernate-status, alternate-tab, apps-menu, auto-move-windows, common, drive-menu, launch-new-instance, native-window-placement, onboard, overrides, places-menu, screenshot-window-sizer, user-theme, window-list, windowsNavigator et workspace-indicator, permettant d’utiliser GNOME au clavier efficacement tout en conservant quelques fonctionnalités utiles.

Xfce et les autres…

Une version autonome (live) est distribuée en ISO aux côtés de KDE Plasma et GNOME pour permettre de tester un environnement plus léger. Vous pouvez tester sur clef USB ou DVD. Voici la gamme complète des images ISO de Mageia :

- installation classique DVD pour 32 bits ;

- installation classique DVD pour 64 bits ;

- DVD autonome GNOME 64 bits ;

- DVD autonome Plasma 64 bits ;

- DVD autonome Xfce 32 bits ;

- DVD autonome Xfce 64 bits.

En synthèse des mises à jour

Tous les logiciels dans les dépôts ont été reconstruits et mis à jour pour inclure les derniers et les plus importants logiciels de l’écosystème libre, vous trouverez ci‐dessous quelques‐uns des principaux composants inclus dans cette version :

- système de base : noyau Linux 4.9.35 (LTS), systemd 230, X.org 1.19.3, Wayland 1.11.0, Mesa 17.1.4 ;

- bibliothèques graphiques : Qt 5.6.2 (LTS), GTK+ 3.22.16 ;

- environnements de bureau : Plasma 5.8.7 (LTS), GNOME 3.24.2, MATE 1.18, Cinnamon 3.2.8, Xfce 4.12.1, LXQt 0.11 ;

- applications : LibreOffice 5.3.4.2, Firefox 52.2.0 ESR, Thunderbird 52.2.1, Chromium 57.

Dans le détail des nouveautés de Mageia 6

Prise en charge de Wayland

Wayland est un protocole de serveur d’affichage plus simple et plus efficace que l’architecture de X.Org qui utilise un gestionnaire de fenêtres composite fonctionnant de concert avec le système X Window.

Avec l’introduction des compositeurs (permettant des effets de transparence, d’ombre portée, etc.), X.Org ne peut plus être performant, car il constitue une étape supplémentaire entre l’application et le compositeur, ainsi qu’entre le compositeur et le matériel.

Wayland a été proposé pour succéder à X11 : un serveur Wayland joue à la fois le rôle de compositeur (gestionnaire de fenêtres) et de serveur d’affichage.

Wayland est donc une évolution majeure dans l’architecture GNU/Linux, même si elle n’est que peu visible pour la majorité des utilisateurs. Une couche logicielle est fournie pour faire fonctionner les anciennes applications, via une version spéciale du serveur X.Org fonctionnant au‐dessus de Wayland : XWayland.

Une conséquence possible de la disponibilité de Wayland devrait être la disponibilité de jeux nécessitant un affichage performant.MCC : le Centre de contrôle Mageia

Cet utilitaire qui permet de configurer le système contribue fortement à la réputation de Mageia. Il est hérité de Mandrake, puis de Mandriva Linux, et s’est perfectionné au fil des années et des versions. Il a bénéficié d’une heureuse cure de jouvence. De nouvelles icônes ont joliment amélioré la convivialité de MCC.

Cette illustration vient de la version anglaise mais, rassurez‐vous, Mageia vous propose une version française lors de l’installation. Mageia est certainement la plus française des grandes distributions.Ajout de DNF2

Proposé par Fedora, dnf a été logiquement intégré à Mageia. Il est disponible en plus de l’outil classique d’installation

urpmi.Les apports d’AppStream

Les utilisateurs bénéficient de l’outil dnfagora dans la continuité de rpmdrake, pour une interface graphique améliorée et cohérente. Cela permet à l’utilisateur de rechercher un logiciel correspondant à son besoin, en se basant sur des méta‐données consolidées entre distributions.

C’est un apport en complément du travail de Debian pour http://madb.mageia.org, avec les copies d’écran des applications graphiques. Il y a aussi la possibilité de participer à l’assurance qualité de MageiaMageia 6 pour l’architecture ARM

Le portage ARM (re‐)prend vie : démarré avec Mageia 1, il est désormais disponible sur les miroirs pour architecture armv5tl et armv7hl (respectivement ARMv5 et ARMv7, ce qui inclut le Raspberry Pi). Attention, cela reste réservé aux aventureux, des images d’installation pourront être disponibles par la suite, si suffisamment de personnes se montrent intéressées.

Par exemple, les serveurs de base de données PostgreSQL 9.4 et 9.6 sont disponibles : http://madb.mageia.org/package/list/t_group/68/application/0/arch/armv7hl/page/2.

Pour ceux intéressés, vous pouvez aussi suivre le statut des paquets inclus selon l’architecture : https://pkgsubmit.mageia.org/arm-status.html.Participer à l’activité de Mageia et de sa communauté

Nos amis francophones de MLO sont très actifs dans le soutien en français aux utilisateurs de la distribution avec tutoriels et forums officiels pour Mageia.

Pour autant, la difficulté à sortir une distribution dans les temps a pesé pour certains :

- Mageia 5 est sortie en juin 2015 ;

- Mageia 5.1 est sortie en décembre 2016 ;

- Mageia 6 arrive enfin en juillet 2017, pour une date initiale (re‐)planifiée en mars ou mai 2017, mais initialement prévue en août 2016, reportée à décembre 2016 pour diverses raisons ;

- entretemps Cauldron (la version de dév’) a continué d’évoluer, pris en compte Wayland notamment, des mises à jour de beaucoup de logiciels (et de jeux) sur le mode de la publication continue — rolling release — (« jouez aux dés », si vous en avez envie, c’est votre choix, cela a été le nôtre pendant toute cette période).

C’est un vrai travail de motivation et de recrutement, d’accueil de nouveaux contributeurs qui a permis la sortie de cette version Mageia 6. En bref, vous êtes les bienvenus à rejoindre le projet et à le faire perdurer (ce qui nous tient à cœur et nous motive, pouvant permettre à chacun d’apprendre beaucoup plus qu’il n’en aurait espéré de son passage sous GNU/Linux). Les contributeurs à Mageia sont présents sur la plupart des événements du Libre : FOSDEM, RMLL, JDLL, POSS, premiers samedis, Kernel Recipes, etc. N’hésitez pas à venir à notre rencontre !

Comme Mageia 5 est bien maîtrisée, vous avez au moins jusqu’au 31 octobre 2017 pour passer à Mageia 6 qui, elle, vous permettra d’être tranquille jusqu’au 16 janvier 2019. :-)

Bon passage à Mageia 6 ! _o/*

-

Tutoriel 3D - 2D découpe au laser, le retour du tux

(Journaux LinuxFR)

Sommaire

- Tranche de pingouin

- Au début était le cube

- Il est gros vot manchot ?

- Et si on l’écartelait ?

- Mais quand est-ce qu’on coupe ?

- Et si on l’empalait ?

- On l’empale plus ?

- Parlons peu, parlons kerf

- C’est la lutte finale

- Le petit oiseau va sortir

- TuxOlaser

- Déboitage du tux et montage

- Tadaaaa

- A propos de licences

- Les fichiers

Tranche de pingouin

Chose promise, cause perdue. Voici comment transformer un modèle 3D en tranches de bois pour découpe laser. Et en bonus, mon essai initial de découpe en création originale.

Les outils que j’ai utilisé sont blender et inkscape, et ce juste parce que je les connaissais et donc plus facile pour expérimenter.Note aux amateurs de freecad, j’ai commencé à regarder comment ça marche, au cas où ce serait plus simple avec, si jamais je trouve une idée et le courage de refaire un tuto, ça me fera un zeugma.

Au début était le cube

Ouvrir un nouveau fichier dans blender et mettre la scène en métrique, car sinon les mesures ne sont pas fixées par taille réelle. Notez que à chaque étape du tuto on aura des soucis de conversion de dimensions, donc en fait… mais bon faut pas en profiter pour être négligent.

Retirer le cube et ajouter le Tux à la scène. Vous pouvez le trouver ainsi que toutes les licences à Tuuuuuuux

- Faire face au tux (1 au pavé num)

- Mettre la vue iso (5 au pavé num)

- sélectionner le tux

- passer en editor mode (tab)

- Sélectionner le dessous des pattes (B) qui est rond

- Niveler (SZ0)

- sélectionner les deux centres des pattes, (S) Snap cursor to selected

- rebasculer en object mode (tab) , transform origine to 3d cursor (object/transform)

Maintenant, le tux est calé pour avoir le plancher des pattes en comme origine, à la verticale du pseudo centre de gravité que nous venons de choisir.

mettre la bête en Z 0.

Il est gros vot manchot ?

Il nous faut choisir une taille, suffisamment grosse pour que ce soit cool, et pas trop gros pour limiter le prix. Comme l’objet c’est aussi tester une bonne quantité d’épaisseurs pour voir comment ajuster la taille théorique d’une planche par rapport à sa taille réelle (il reste du vide, la colle ça épaissit, les planches sont pas forcément pile à la taille).

Une planche 2mm chez sculpteo (chez qui je teste la découpe laser) fait 94cm*59cm, il faut aussi essayer de rester dans une seule planche avec tous les morceaux. Le tux est presque aussi large que haut, du coup on cherche une approximation de cube découpé en tranches et étalé fait la même surface en gardant un peu de marge. ça fait 55 tranches, donc une hauteur de 116.875mm

Et si on l’écartelait ?

Il nous faut séparer les pattes du corps du tux (ce sont des objets distincts dans le modèle de base en fait et elles s’interconnectent :

Il faut les réunir par booléen union au corps pour avoir un seul objet avec un intérieur/extérieur propre.

On peut maintenant appliquer une subdivision sur le tux CTRL+3, parce que le tux aime la douceur, et pas que celle angevine.

Lui sculpter des yeux plus sympa, parce que même si tout le monde ne veut pas l’avouer, pour avoir l’air cool faut quand même avoir un peu l’air con.

Mais quand est-ce qu’on coupe ?

Patience, il faut regarder un peu avant de couper. Placer un plan plus grand que le tux au sol, genre 20cmx20cm et lui appliquer un booléen d’intersection avec le tux. Et regarder en bougeant le plan sur Z comment seront les tranches.

On voit deux endroits à problème, les ailes et la queue qui auront des tranches avec plus que un morceau, ce qui est plus complexe à coller.

par ex les ailes :

Ce sera lourd à coller ensuite, on peut mais pourquoi…

autant relier les ailes au tronc le plus légèrement possible, avec un lien de 1mm de large.

idem au niveau de la queue :

J’ajoute un bloc en union au niveau de la queue, le plus ajusté possible par un booléen union.

Cela vous permettra de facilement coller, il sera toujours possible de le limer après collage.

Il faut bien nettoyer le résultat de l’union à l’intérieur du tux, ne pas laisser de cloisons internes, c’est à dire éviter d’avoir des plan à l’intérieur des plans :

Finir de nettoyer en retirant les doublons de vertices, boucher les trous, assurer les normales pour que ce soit clair ce qui est à l’intérieur et à l’extérieur.

Et si on l’empalait ?

Pensons au support central qui va nous permettre de facilement positionner et coller les tranches de tux, il va être en trapèze et ressembler à ça au niveau d’une tranche :

Le choix de la découpe sera donc toujours du côté le plus grand, en bas. Donc notre référence pour le positionnement des plans de découpe doit être la face basse de chaque tranche.

Replaçons le plan à 0.01mm en Z (pour éviter le chevauchement parfait des surface avec les pattes Z=0), pensez à remettre tous les éléments avec scale=1 (Ctrl+A scale and rotation) pour la suite.

Faire une array de 50 plans en Z espacés de 2.125mm, faire le booléen intersection avec le tux. Lors de la réalisation de mon bureau réel avec des tux, j’ai constaté que l’empilage de x tranches de 2mm n’a pas un résultat de x*2mm, mais avec l’air restant et la colle environ 2.125. Je vais affiner avec ce tux cette estimation mais déjà on part de 2.125mm par tranche.

On voit les tranches et on voit des petits problèmes

Une tranche qui manque en haut et le cul qui a une mini tranche en bas.

Diminuer le overlap thresold du booléen pour que le problème du haut disparaisse :

Remonter le point du bas du tux pour supprimer le second problème et non, ce n'est pas lui mettre un doigt dans le cul car ça ne doit pas rentrer :

Nickel !

Simulons une épaisseur des tranches pour avoir un aperçu du résultat réel, ajoutons au plan un modifier solidify 2mm avec l’offfet à +1 (vers le haut) pour suivre le plan d’avoir la face basse comme référence :

Le résultat est conforme, retirez le solidify, il ne doit pas interférer avec l’étape de création du lien central.

On l’empale plus ?

Mais si, mais si. En fait ce n’est pas obligatoire, mais ça facilite le positionnement des étages, et on peut aussi le garde sans le coller. Le lien central doit avoir une forme de trapèze et être parfaitement vertical, car pour l’instant sculpteo ne fait pas de découpe oblique.

Il doit faire une épaisseur égale à celle du bois. Pour mon exemple je suis resté sur mon approximation (2.125mm) mais normalement il faut prendre 2mm et ajuster avec l’épaisseur du kerf qui est la taille du laser laissant un vide de découpe autour du trait de coupe. En pratique lors de mon premier essai j’ai eu des soucis d’épaisseur et j’ai du poncer mon trapèze. Du coup comme ce n’est pas nécessaire d’ajuster. Je surestime cette fois-ci la taille du trapèze.

Il faut ajuster sa position pour qu’il traverse tout le tux, coup de chance c’est possible sur ce modèle en plaçant la traverse au centre de la dernière tranche du tux. Mais sinon on l’aurait simplement fait avec deux trapèzes sur deux hauteurs.

Ajustez la taille en X et la hauteur de la partie haute pour faire joli, elle va dépasser un peu et même arrondir sa tête (note postérieure en pratique le trapèze sera toujours trop court, il faut juger les tranches encore un peu plus grand que 2.125mm).

En dessous ajuster aussi la taille en X pour donner un beau trapèze

On voit que c’est moche au niveau du pied

On va donc remodeler un peu le trapèze pour qu’il soit plus joli à cet endroit.

Parlons peu, parlons kerf

Le kerf c’est la partie du bois éliminée par le laser, en pratique la découpe est plus petite que le plan car le laser à une taille non ponctuelle. la découpe de la traverse dans les tranches sera donc un peu plus grande que prévu, et la traverse découpée plus court aussi que prévu.

Dans ce modèle, on peut ignorer le kerf et accepter les différences, elles seront minimes et les pièces collées seront bien ajustées.

appliquons donc le booléen différence entre le plan des tranches et la traverse

Le résultat est difficile à voir mais en vue fil de fer c’est visible

C’est la lutte finale

On peut passer à la phase finale, on réalise les “modifier” sur les planches, puis on aplati le trapèze en retirant les vertices d’un côté.

En mode éditeur, on sépare toutes les tranches (P+loose parts en mode édition) et on les étale dans le bon ordre en vue du dessus. Attention, les numéros générés lors de la réalisation de l’array ne sont pas forcément dans l’ordre de Z…

Pour ne pas me planter, je me met dans une vue adaptée et je bouge une par une les tranches avec des gx0.1 … Je vérifie bien que tout est dans l’ordre puis je met tout le monde à plat (sélectionner tout A puis SZ0)Nous allons avoir des soucis de conversion de taille entre blender puis Inkscape puis sculpteo… on commence par poser un étalon dans blender, un plan au sol de 1cm sur 90cm

Le petit oiseau va sortir

Enfin presque, il faut encore à faire la photo !

Il existe une option de rendering qui génère du svg.

Mettons la caméra au dessus en mode orthographique, d’abord une résolution 100% sur un ratio approximatif de mon rectangle incluant tout.

puis placer la caméra assez bien au dessus de la scène et changez les paramètres :

L’échelle orthographique est ce qui correspond au zoom, ajustez la valeur pour que tout rentre au plus juste

Tout doit rentrer dans la fenêtre de rendering :

Maintenant depuis les user pref, activez le svg freestyle exporter :

Et activez les deux options freestyle et svg export depuis les options rendering

Pressez F12, une image svg sera générée dans le répertoire indiqué dans output nommé 0001.svg,Ouvrez le dans Inkscape, dégroupez et sélectionnez l’étalon. mettez lui une épaisseur de contour à 0 pour ne pas fausser la taille et regardez sa taille. Dans mon cas je tombe sur 35.719cm.

Je vais donc changer la résolution de l’image pour ajuster la taille d’un facteur de 90/35.719=2.52

Je change dans blender le render pour :

Re F12 et vérification.

Mon étalon fait maintenant 1cm sur 90.01cm.

aller, on essaie avec un pixel de moins en Y :), on tombe sur 89.987. C’est moins bon, retour en arrière.Maintenant que l’on a les bonnes tailles dans Inkscape, il faut nettoyer. Parce que le freestyle a introduit des pixels de temps en temps.

Je prends donc chaque découpe pour la repositionner au mieux et aussi supprimer les traces.

Pour m’aider et aussi servir d’étalon entre Inkscape et sculpteo je place un cadre dans une autre couleur qui délimite ma sélection, 53.5cm de large sur 75cm de haut.

Et je fais tout rentrer dedans.

Je vérifie chaque pièce pour assurer qu’il n’y a pas de défaut, et j’assure les contours à 1px et mon cadre avec une couleur différente

C’est prêt.

Pour ceux qui sont plus observateurs que moi, vous verrez que j’ai oublié de grouper une fente dans une tranche. Moi je vais le voir au montage plus tard…TuxOlaser

J’upload chez sculpteo.

Deux couleurs sont détectées, l"une correspond au noir et l’autre au rouge du cadre. Les mesures n’ont pas été conservées, je ne sais pas pourquoi… mais mon cadre me permet de choisir un ajustement de taille à 26.5% qui me redonne les bonnes dimensions.Je peux alors désactiver le cadre rouge dans sculpteo (style 2 sur aucun et voila !

prêt à couper.Livraison comprise il vous en coûtera 53.33€.

Pour info, les tux du bureau ont coûté moins cher, ils étaient en une seule livraison et un peu plus petits, 72€ les 3.Déboitage du tux et montage

Je hais les video de unboxing, et me voilà moi même à déboiter…

Bon, puisqu’il faut :

la boite est bien protégée

et la planche dans la mousse

Les pièces sont tenues par du scotch, il faudra faire attention en retirant le scotch de ne pas casser les pièces fragiles.

Je numérote mes pièces avant de défaire, c’est moins cher que de faire des numéros au laser.

Ensuite on empile jusqu’à la fameuse pièce 33 qu’il faudra redécouper.

Tadaaaa

A propos de licences

J’ai fouillé pour trouver les licences attachées au modèle de base, les voici :

https://opengameart.org/content/tux

https://opengameart.org/sites/default/files/license_images/gpl.png

http://www.gnu.org/licenses/gpl-3.0.html

https://opengameart.org/sites/default/files/license_images/cc-by.png

http://creativecommons.org/licenses/by/3.0/Les fichiers

Voila les fichiers sources blender et le inkscape (piece 33 corrigée)

fichier blender

fichier svgCommentaires : voir le flux atom ouvrir dans le navigateur

-

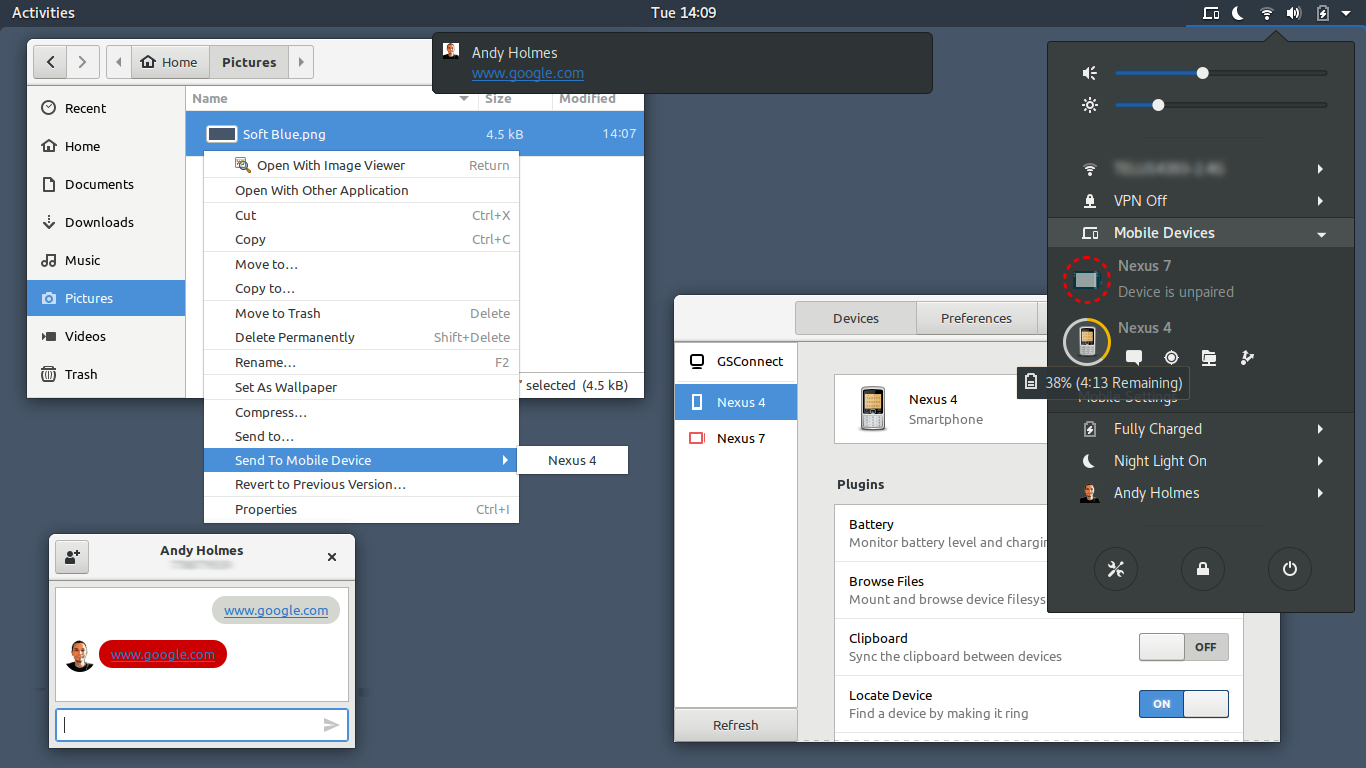

KDE Connect et Gnome

(Journaux LinuxFR)

Bonjoir,

Voilà des semaines que je cherche à avoir un truc potable sous Gnome pour piloter depuis son ordinateur son smartphone (sous Android évidemment).

Il y a bien gnome-phone-manager mais apparemment déjà c'est pour Gnome 2 (et donc c'est du Gtk2), et d'autre part cela exploite un vieux protocole de communication d'après ce que j'ai compris, c'est plus pour les téléphones qui avaient encore des touches et n'étaient pas tactiles (vous me direz ça existe encore mais je pense que le protocole ne marchera pas sur les récents). En plus, c'est limité aux SMS.

Après l'autre solution ce sont les trucs pas très libres, vous savez, les AirDroid et j'en passe. Je n'aime pas trop tout ce qui est permissions abusives, donc je passe, même si les possibilités sont alléchantes.

J'ai cherché une solution libre, c'est là que je suis tombé sur KDE Connect, un projet/protocole de communication avec des appareils tel que smartphone, mais basé sur les toolkits KDE. Je me dis, j'ai pas trop envie d'installer toute la clique KDE sachant que je suis et je veux rester sur un Gnome "seul et propre". Dommage.

Mais je poursuis mes recherches et que vois-je… tiens tiens, une extensions Gnome3 utilisant le protocole KDE Connect… MConnect oui, c'est bien, mais il faut installer quand même des paquets de KDE (je suis sous Fedora)… il y a un lien github qui explique que l'auteur abandonne le projet au profit d'une extension avec une réécriture en moteur GJS (le javascript utilisé pour les extension Gnome3), donc plus besoin des paquets KDE ! L'extension est GSConnect. Attention, pour ceux qui sont en Gnome 3.28, il faut installer la version 11 (qui n'est pas encore proposée sur le site gnome-extensions) présent sur le github avec les explications d'installation du zip ici.

Ensuite, il suffit si comme moi vous utilisez Fdroid de le télécharger à travers lui l'apk KDE Connect et l'installer sur le smartphone, et oui, c'est libre, donc ça y est disponible ! Sachant qu'il y est aussi sur Google Play.

Enfin, configuration de l'extension sous Gnome en nommant votre PC à travers l'extension (cela n'affecte nullement le hostname), le détecter sous KDE Connect Android, configurer les permissions, et voilà ! Vous pouvez contrôler quasi intégralement votre téléphone sans y poser le moindre petit doigt dessus ! Envoi et notification de réception de SMS, transfert de fichiers bi-directionnel par le biais de Nautilus (montage automatique), pourcentage de batterie aussi et d'autre encore. Côté téléphone, vous pouvez vous en servir pour contrôler comme avec une télécommande un lecteur multimédia supportant le protocole MPRIS2.

Pour l'instant les limitations sont entre autre que cela ne fonctionne que par Wifi pour l'instant, la gestion de connexion par Bluetooth semble ardue selon l'auteur, mais il pense qu'il y arrivera.

En image :

Commentaires : voir le flux atom ouvrir dans le navigateur

-

Revue de presse de l'April pour la semaine 24 de l'année 2018

(Dépêches LinuxFR)

La revue de presse de l’April est régulièrement éditée par les membres de l’association. Elle couvre l’actualité de la presse en ligne, liée au logiciel libre. Il s’agit donc d’une sélection d’articles de presse et non de prises de position de l’Association de promotion et de défense du logiciel libre.

Sommaire

- [Numéro Magazine] Portrait de l’artiste en hackeur qui détourne les nouvelles technologies

- [France Culture] Que reste‐t‐il du logiciel libre ?

- [RFI] Software Heritage, la grande bibliothèque du logiciel

- [Numerama] Open source : qui sont les bons élèves et les cancres parmi les géants de la tech ?

- [BFMtv] Pourquoi les mèmes sur Internet sont en danger

- lien n°1 : April

- lien n°2 : Revue de presse de l’April

- lien n°3 : Revue de presse de la semaine précédente

[Numéro Magazine] Portrait de l’artiste en hackeur qui détourne les nouvelles technologies

Par Ingrid Luquet‐Gad, le jeudi 14 juin 2018. Extrait :« Algorithmes, codage, datas, hardware… comment les artistes détournent‐ils les nouvelles technologies ? C’est la question vertigineuse à laquelle répond une double exposition au centre Pompidou, avec l’artiste japonais Ryoji Ikeda en invité d’honneur. »

[France Culture] Que reste‐t‐il du logiciel libre ?

Par Hervé Gardette, le mercredi 13 juin 2018. Extrait :« Microsoft vient de racheter la plate‐forme de création collaborative de logiciels GitHub. Est‐ce vraiment une bonne nouvelle pour le logiciel libre ? Et quelles conséquences pour les utilisateurs ? La philosophie du libre a‐t‐elle gagné ou s’est‐elle fait manger ? »

Et aussi :

[RFI] Software Heritage, la grande bibliothèque du logiciel

Par Dominique Desaunay, le mercredi 13 juin 2018. Extrait :« La plupart des activités humaines dépendent exclusivement des programmes informatiques qui permettent, par exemple, aux internautes de consulter leurs réseaux sociaux ainsi que de surfer sur n’importe quelle page Web. Des logiciels fragiles qui contrairement aux hiéroglyphes gravés dans la pierre peuvent s’altérer avec le temps et disparaître à jamais. C’est la raison pour laquelle les informaticiens de l’Institut national de recherche en informatique et en automatique ont développé une immense bibliothèque en ligne dénommée Software Heritage. »

Et aussi :

- [les-infostrateges.com] Software Heritage : une bibliothèque au service de l’archive universelle des logiciels ;

- [Industrie et Technologies] Software Heritage : les logiciels ont leur bibliothèque d’Alexandrie.

[Numerama] Open source : qui sont les bons élèves et les cancres parmi les géants de la tech ?

Par Victoria Castro, le mardi 12 juin 2018. Extrait :« Tout le monde dit aimer l’open source, mais qu’en est‐il vraiment ? Nous avons dressé un classement de 6 géants de la tech, du plus grand sympathisant de l’ouverture au plus propriétaire d’entre eux. »

[BFMtv] Pourquoi les mèmes sur Internet sont en danger

Par Elsa Trujillo, le lundi 11 juin 2018. Extrait :« L’article 13 d’un projet de directive européenne sur le droit d’auteur entend limiter drastiquement la réutilisation de contenus protégés. »

Et aussi :

- [Usbek & Rica] Adieu mèmes et parodies ? Pourquoi « l’article 13 » menace Internet ;

- [RTL.fr] Un projet de loi européen voté le 20 juin va‐t‐il changer la face du Web ? ;

- [Konbini France] Les gifs et les mèmes sont‐ils en danger de mort ?.

Voir aussi :

- Sauvons le partage de code ! Appel à signature de la lettre ouverte « Save Code Share » ;

- Campagne « Save Your Internet » (agir avant le 20 juin 2018).

Commentaires : voir le flux atom ouvrir dans le navigateur

-

CVE-2014-3566 — Vulnérabilité POODLE

(Dépêches LinuxFR)

Qu’est‐ce POODLE ?

POODLE signifie Padding Oracle On Downgraded Legacy. Il s’agit d’une vulnérabilité permettant via une attaque de l’« homme du milieu » (MIM, Man In the Middle), en se plaçant entre le navigateur Web et le serveur Web, de déchiffrer les informations chiffrées.

POODLE affecte les anciennes normes de chiffrement, notamment Secure Socket Layer (SSL) version 3.0. Il n’affecte pas le mécanisme de chiffrement plus récent, et standardisé, appelé Transport Layer Security (TLS).

Recommandations

Pour atténuer cette vulnérabilité, désactivez SSL 3.0 en forçant l’utilisation de TLS, tout en vérifiant la compatibilité des navigateurs clients devant y avoir accès.

Plusieurs bulletins de sécurité ont annoncé la vulnérabilité :

- alerte CERT : http://cert.ssi.gouv.fr/site/CERTFR-2014-ALE-007/ ;

- alerte NVD : https://web.nvd.nist.gov/view/vuln/detail?vulnId=CVE-2014-3566.

- lien n°1 : OpenSSL décrit POODLE

- lien n°2 : Préconisation Red Hat

- lien n°3 : Détection de la faille proposée par Red Hat

- lien n°4 : Piqûre de rappel TLS

- lien n°5 : Explication claire en français

Histoire et aides diverses

Google a identifié une faille dans le protocole SSL v3. Il existe des contournements côté serveurs comme côté clients : garder en tête la compatibilité avec les navigateurs clients. Red Hat n’a pour l’instant pas publié d’errata. Cela affecte RHEL5, RHEL6 et RHEL7, également les CentOS. À voir pour les autres distributions…

Remarque : poodle signifie caniche en anglais.

Page pour tester votre navigateur client

Tester par vous même

openssl s_client -connect mon_site:443 -ssl3Configurer Apache

SSLProtocol All -SSLv2 -SSLv3Configurer Postfix

smtpd_tls_mandatory_protocols = !SSLv2, !SSLv3Tester la vulnérabilité de vos sites

Voici le script proposé par Red Hat :

#!/bin/bash # # Copyright (C) 2014 by Dan Varga <dvarga@redhat.com> # # This program is free software; you can redistribute it and/or modify # it under the terms of the GNU General Public License as published by # the Free Software Foundation; either version 3 of the License, or # (at your option) any later version. host=$1 port=$2 if [ "$2" == "" ] then port=443 fi out="`echo x | timeout 5 openssl s_client -ssl3 -connect ${host}:${port} 2>/dev/null`" ret=$? if [ $ret -eq 0 ] then echo "VULNERABLE! SSLv3 detected." exit elif [ $ret -eq 1 ] then out=`echo $out | perl -pe 's|.*Cipher is (.*?) .*|$1|'` if [ "$out" == "0000" ] || [ "$out" == "(NONE)" ] then echo "Not Vulnerable. We detected that this server does not support SSLv3" exit fi elif [ $ret -eq 124 ] then echo "error: timeout connecting to host $host:$port" exit fi echo "error: Unable to connect to host $host:$port" -

Eolie, le petit frère de Lollypop

(Journaux LinuxFR)

Bonjour à tous,

pour ceux qui me connaissent, je suis l'auteur de Lollypop, un lecteur audio pour GNOME. Ce dernier depuis plusieurs mois ne reçoit que des corrections de bug et des ajouts de fonctionnalités quand je trouve les demandes pertinentes, mais de mon point de vue, il est «terminé».

Du coup, je me faisais chier dans le train alors j'ai commencé à bosser sur une autre application: Eolie

Il s'agit d'un navigateur web pour GNOME avec les fonctionnalités de base d'un navigateur web plus:

- Support de la synchronisation avec Firefox Sync

- Support du téléchargement des vidéos en cours de lecture

- Mode "privé" par "onglets" et non par fenêtre

- Mode lectureVoilà, j'en avais marre de Firefox et son manque d'intégration, Epiphany ne répond pas vraiment à mon besoin et je suis une merde en C (donc dur de contribuer). J'ai démarré Eolie il y'a 4 mois, python + GTK + WebKit sont vraiment efficaces.

https://www.gnomelibre.fr/2017/04/developpement-dun-nouveau-navigateur-web-eolie/

https://www.youtube.com/watch?v=pWHLbaqKOUQ

-

Lancement de GapMea logiciel de modélisation de données

(Dépêches LinuxFR)

GapMea est un outil de conception de bases de données (code sous licence GPL v3+ et documentation sous GFDL v1.3+).

GapMea est un outil graphique de modélisation des données écrit en C++ à l’aide de la bibliothèque Qt. Il permet de formaliser des schémas recueillant et structurant les informations nécessaires à un domaine de gestion. Le schéma obtenu est enregistré dans un fichier texte au format XML. Le logiciel permet la génération du code SQL nécessaire à la création des tables de la base de données qui vont accueillir les informations.

- lien n°1 : Le site du projet

- lien n°2 : Les sources

- lien n°3 : La documentation

- lien n°4 : La documentation technique

- lien n°5 : Téléchargements

- lien n°6 : le BTS SIO de GAP

Cet outil permet un apprentissage rapide de la modélisation des données. Il offre une représentation synthétique des relations entre les tables d’une base de données.

Voici un aperçu du genre de schémas que l’on peut créer :

L’auteur

Professeur certifié en Informatique de Gestion, j’enseigne depuis plus de vingt ans en section de Technicien supérieur en informatique, aujourd’hui dénomméee BTS « Services Informatiques aux Organisations ».

Je suis donc en premier lieu enseignant, mais aussi développeur, administrateur système, dompteur de routeurs et autres commutateurs…

Le projet

Il est né d’un besoin, ni Umbrello ni Dia ne me satisfaisaient pour cet objectif particulier.

Historique

GapMea est un projet que je traîne depuis très longtemps : un premier jet a été développé avec Delphi et Interbase, puis un portage sous feu Kilix, une reprise complète et salutaire en Qt4 et enfin un portage sous Qt5.

De très nombreuses heures de travail donc… Il est maintenant temps pour ce code de quitter mon disque dur poussiéreux.

Longue vie à lui et au logiciel libre.

-

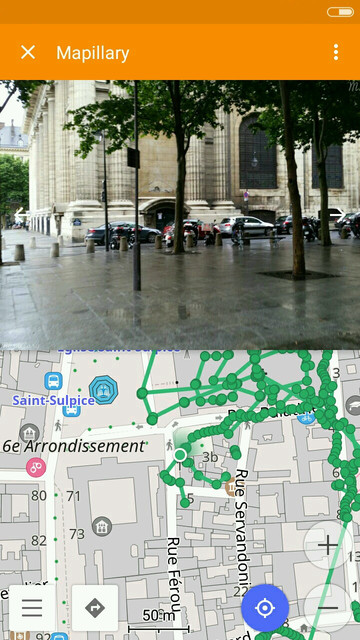

Cartographie et images de rues : Mapillary et OpenStreetCam

(Dépêches LinuxFR)

Vous connaissez probablement déjà OpenStreetMap, la base de données cartographique libre. Mais vous connaissez sans doute aussi des concurrents qui proposent en plus des cartes d’autres services, comme les images aériennes, et depuis une dizaine d’années vous avez peut‐être pris l’habitude des images prises directement dans les rues : StreetView chez Google, StreetSide chez Microsoft…

Des alternatives libres se mettent en place, et c’est ce dont nous allons parler : OpenStreetCam, né en 2013, et Mapillary. Les deux initiatives sont ouvertes, tout le monde peut participer facilement via une application pour mobile.

Ces solutions permettent une alternative libre pour les utilisateurs et sont une aide très précieuse pour les contributeurs d’OpenStreetMap.

- lien n°1 : Mapillary

- lien n°2 : OpenStreetCam

- lien n°3 : Discussion et comparaison entre Mapillary et OpenStreetCam sur le projet GitHub d’OpenStreetCam

- lien n°4 : OpenStreetCam sur le wiki d’OpenStreetMap

- lien n°5 : Mapillary sur le wiki d’OpenStreetMap

Sommaire

Réunir une telle collection d’images aurait pu paraître impossible il y a peu, mais l’avènement des smartphones change la donne : cartographier une rue peut être aussi simple que de fixer son téléphone sur son vélo, sa voiture, ou le tenir à la main en marchant. Une application s’occupe de prendre des photos (géolocalisées, bien sûr) périodiquement et de les envoyer vers les serveurs qui s’occupent du reste.

Dur d’atteindre la qualité des images panoramiques à 360° des concurrents, mais, à l’inverse, permettre à tout le monde de contribuer permet aussi de couvrir les zones inaccessibles en voiture.

En cinq ans, Mapillary a collecté 179 millions d’images (après avoir passé les 100 millions il y a moins d’un an), soit plus de trois millions de kilomètres couverts. La couverture OpenStreetCam n’est pas encore aussi bonne, mais c’est quand même plus de 50 millions d’images, et la croissance est très forte de ce côté aussi (multiplication par quatre depuis novembre 2016).

À quoi tout ceci peut‐il servir ?

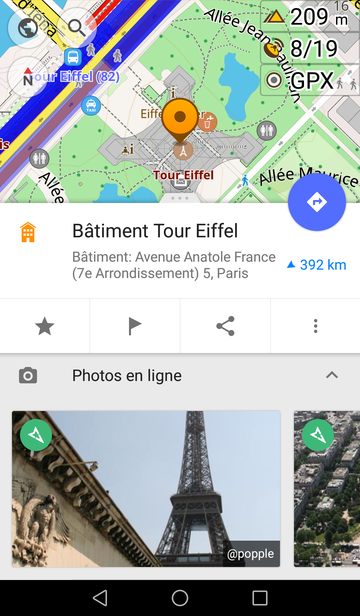

- Pour tout le monde : comme la concurrence, à savoir à quoi ressemble un endroit sans y être allé, à planifier un itinéraire… On peut accéder aux images depuis un navigateur via le site des deux projets. Mapillary est intégré à l’application libre Android OsmAnd depuis la version 2.7 de juillet 2017 (disponible sur le dépôt F-Droid sous le nom OsmAnd~). On peut maintenant visualiser les séquences Mapillary directement sur la carte :

Ou plus simplement, une section « photos en ligne » est maintenant disponible quand on examine les détails d’un lieu :

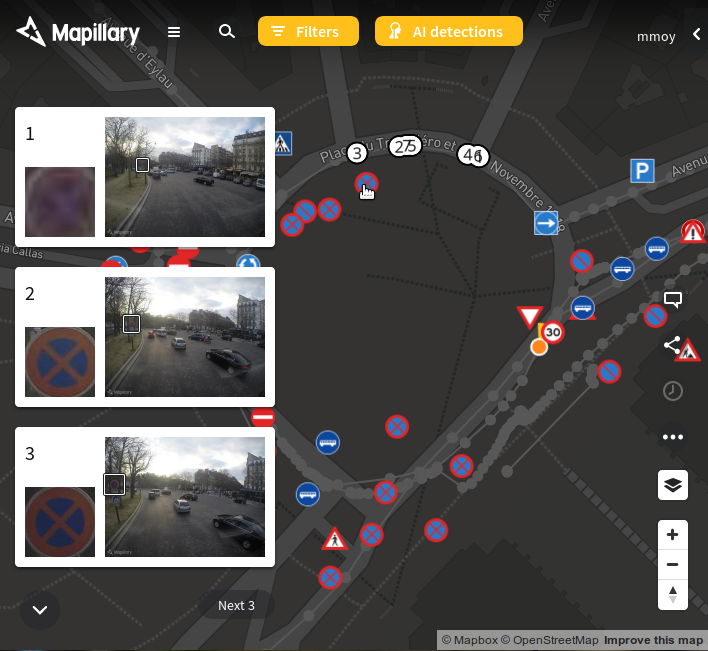

- Pour les contributeurs OpenStreetMap, c’est un outil précieux pour la cartographie de fauteuil, c’est‐à‐dire la possibilité d’éditer la carte OpenStreetMap sans être sur le lieu qu’on édite et éventuellement sans avoir fait de reconnaissance au préalable. L’éditeur ID en ligne sur https://openstreetmap.org permettait déjà d’éditer sur fond d’images aériennes ou de plan de cadastre par exemple. On peut maintenant visualiser les images de Mapillary directement depuis l’éditeur et, mieux encore, voir directement les panneaux de signalisation détectés par Mapillary en analysant les images.

Mapillary

Le principe de Mapillary est de récolter puis d’analyser un maximum d’images. L’analyse d’image permet de repérer les panneaux, feux tricolores, et aussi d’autres éléments comme les voitures, garages à vélo, verdure, poubelles… Ces données sont utilisables librement par OpenStreetMap, et l’entreprise derrière Mapillary monnaye ces données.

Voici par exemple ce que Mapillary détecte place du Trocadéro :

Ces données sont utilisables directement depuis les éditeurs OpenStreetMap ID (éditeur par défaut depuis le site Web) et JOSM (client lourd). Lire l’article de blog et les vidéos associées pour les détails. Les éléments de carte peuvent être associés à une image Mapillary via l’étiquette

mapillary=….Mapillary est également intégré dans l’application Android OsmAnd.

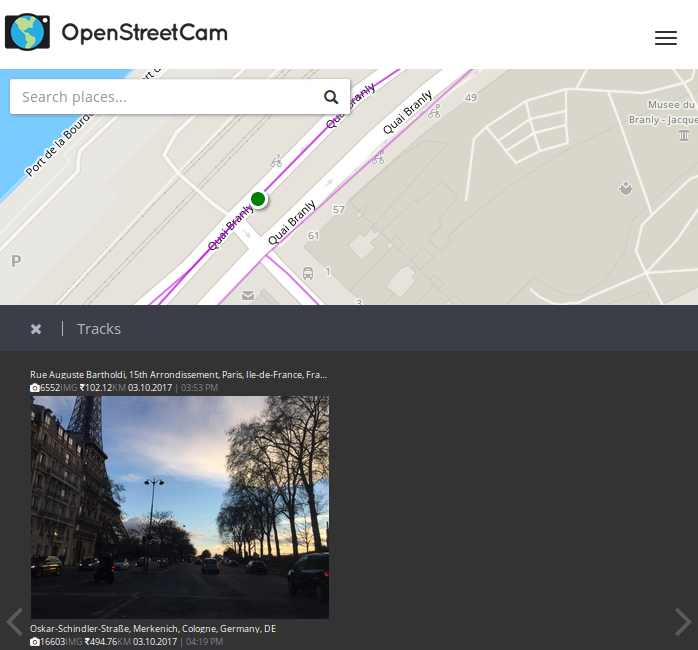

OpenStreetCam

OpenStreetCam est mené par Telenav, qui s’appuie sur OpenStreetMap pour les outils de navigation qu’elle commercialise.

Une originalité d’OpenStreetCam est sa manière d’encourager les contributeurs par un système de points : on gagne des points en contribuant des images, et d’autant plus de points qu’on couvre des zones non couvertes.

OpenStreetCam est intégré dans l’éditeur JOSM, mais pas (encore ?) dans ID ni OsmAnd.

Historiquement, le projet s’est lancé sous le nom OpenStreetView pour reprendre le nom de domaine d’un projet lancé en 2009 qui n’avait pas réussi à devenir populaire. Il a été renommé plus tard en OpenStreetCam pour éviter la confusion possible avec la solution de Google.

Est‐ce vraiment libre ?

On lit çà et là sur le Web des controverses comme quoi l’une des solutions est commerciale et l’autre libre. En réalité, les deux solutions sont supportées par des entités commerciales (Mapillary AB est une entreprise basée en Suède centrée sur le service mapillary.com, et OpenStreetCam est mené par l’entreprise Telenav qui vend des systèmes de navigation pour voiture qui utilisent OpenStreetMap). Et les deux solutions sont « en grande partie libre ».

Les deux services distribuent les images sous licence CC-BY-SA, et dans les deux cas les contributeurs donnent au service une licence qui lui permet d’utiliser les images sans restrictions.

Chez OpenStreetCam, le code du site Web et des applications pour Android et pour iOS sont libres (mais au moins l’application Android a des dépendances non libres qui empêchent, entre autres, son inclusion dans F-Droid). Mapillary fournit plusieurs logiciels libres, par exemple mapillary-js, le code qui permet l’affichage des images sur leur site Web, mais l’application pour Android et iOS n’est pas libre (elle pourrait le devenir prochainement).

Pour Mapillary, il faut distinguer les conditions d’utilisation du service et la licence des images. Les conditions pour le service ne permettent pas l’usage commercial hors contrat avec lui (d’après la partie 1.2 de ses conditions d’utilisations) et limitent par défaut les téléchargements à 50 000. La licence des images est la licence CC-by-SA et il est possible de re‐licencier les travaux dérivés dans le cadre d’OpenStreetMap selon les conditions de la fondation OpenStreetMap. En d’autres termes, il y a des restrictions sur le téléchargement d’images, mais une fois les images téléchargées, elles sont utilisables librement. Les images sont libres, mais le service n’est pas entièrement gratuit (250 €/mois pour le pack « professional », par exemple).

Pour un comparatif des conditions des deux services (écrite par un employé Mapillary), voir par exemple ici.

Et la pérennité ?

L’ouverture est souvent citée comme gage de pérennité. Si l’auteur d’un logiciel libre décide de passer à autre chose, quelqu’un d’autre peut, au moins en théorie, prendre le relai.

Pour OpenStreetCam et Mapillary, la situation est un peu plus compliquée. Le scénario catastrophe où l’un des deux arrête son activité ou se fait racheter par une entreprise qui décide d’arrêter de diffuser les images sous licence libre est tout à fait possible. Pour qu’une autre entité puisse reprendre la suite, il faut que deux conditions soient réunies : que les images soient réutilisables (c’est le cas avec la licence CC-BY-SA), et que quelqu’un ait gardé les images avant qu’elles ne disparaissent. C’est le deuxième point qui est problématique : les bases d’images sont colossales (plus de 500 téraoctets pour Mapillary, un peu moins pour OpenStreetCam, mais fort taux de croissance dans les deux cas) donc maintenir un stockage correctement fiabilisé pour un miroir aurait un coût de l’ordre de la centaine de milliers d’euros par an (en calcul de coin de table…). Ajouté à la limite de téléchargement pour Mapillary, maintenir un miroir n’est clairement pas à la porté du premier venu (même si en comparaison une fondation comme celle de Wikipédia gère un budget autrement plus élevé). Côté OpenStreetCam, certains en ont discuté, mais toujours pas de miroir non plus.

On peut espérer que les deux services ne fermeront pas en même temps, donc une solution pour les contributeurs pour pérenniser leurs images est d’envoyer les images aux deux, mais ce n’est pas faisable directement depuis les applications pour mobile. Certains contributeurs conservent également une copie de leurs images localement, « au cas où ».

Comment contribuer ?

Contribuer est très facile si vous avez un smartphone. Un contributeur peut installer l’application et prendre des images de sa rue à pied et sans matériel supplémentaire en quelques minutes, ou se fixer des objectifs plus ambitieux comme certains contributeurs qui s’imposent de dépasser le million d’images contribuées en un mois. Pour contribuer en voiture ou à vélo, il est recommandé d’avoir un support, Mapillary en envoie gratuitement sur demande aux contributeurs si besoin. Toute la richesse de ces bases d’images vient de la diversité des contributeurs, donc de la diversité des images qu’elles contiennent.

Alors, vous avez commencé ? Qu’attendez‐vous ? ;-)

-

Inverse annonce la sortie de la version 4 de SOGo !

(Dépêches LinuxFR)

Cette version offre de nouvelles fonctionnalités telles que la prise en charge complète du S/MIME, une nouvelle vue calendrier, une meilleure gestion des événements répétitifs et des sources d’authentification SQL. De plus, SOGo v4 apporte un grand nombre d’améliorations et de correctifs à la version précédente au niveau du protocole Exchange ActiveSync et de l’interface Web.

SOGo est un collecticiel (groupware) axé sur l’extensibilité et le respect des standards ouverts. Il permet aux utilisateurs Mozilla Thunderbird avec l’extension Lightning, Apple Calendar/Contacts (macOS et iOS) et Microsoft Outlook de collaborer dans un environnement moderne et cohérent. Il propose les composants classiques des collecticiels : carnet d’adresses, gestion de courrier électronique et calendriers partagés. Finalement, SOGo supporte aussi le protocole Exchange ActiveSync pour la synchronisation des appareils Android, iOS, Windows Phone, BlackBerry et même Microsoft Outlook 2013/2016. SOGo est traduit dans trente‐quatre langues.

SOGo est édité sous licence GPL v2.

- lien n°1 : Site de SOGo

-

Migrer Windows 10 d'un disque BIOS/MBR, vers un SSD en mode UEFI/GPT avec des logiciels libres

(Journaux LinuxFR)

Sommaire

- Introduction

- Prérequis

- Nomenclature

- Procédure de base

- Quelques pistes si ça ne fonctionne pas…

- Documentation, pour aller plus loin…

- Historique de révisions

Introduction

Ce tutoriel vous guide pas à pas pour migrer votre installation de

Windows qui est actuellement sur un disque dur de votre PC vers un

nouveau disque, en l'occurrence un SSD. A vrai dire, vous pouvez aussi

bien migrer vers un autre HDD.La spécificité de ce tutoriel est qu'elle utilise les outils fournis par

Microsoft avec Windows ainsi que des logiciels libres (Clonezilla

principalement, mais si quelque chose devait mal tourner vous pouvez avoir

besoin d'utiliser fdisk, gdisk ou testdisk pour ne citer qu'eux). Quand

j'ai voulu faire cette migration je n'ai pas trouvé de tutoriel

expliquant de bout en bout comment faire cette migration juste avec les

outils de Microsoft et des logiciels libres.Typiquement, vous pouvez avoir envie/besoin de faire cela car vous avez

acheté un nouveau disque pour remplacer l'ancien (par exemple car

l'ancien montre des signes de faiblesse, ou vous voulez améliorer la

réactivité de votre système).En plus de la migration du système d'exploitation, ce tutoriel vous

explique comment passer d'un démarrage en mode BIOS/MBR à un démarrage

en mode UEFI/GPT.Succinctement la démarche est la suivante, d'abord installer le nouveau

disque dans le PC, et initialiser la table de partition selon les normes

Microsoft. Puis cloner/dupliquer la partition contenant le système

d'exploitation à l'aide de Clonezilla. Ensuite et avant de redémarrer

dans le clone de Windows sur le SSD, faire quelques modifications dans

le registre pour que la lettre de lecteurC:pointe vers la bonne

partition et éventuellement modifier le mode SATA en AHCI si vous le

modifiez aussi dans le UEFI/BIOS. Après cela, on va préparer la

partition système EFI/ESP pour que le PC puisse démarrer dessus et qu'il

démarre sur le Windows du SSD. Finalement, une fois dans le Windows du

SSD, on va réactiver l'"environnement de récupération de Windows".Mise en garde : Faites une sauvegarde de vos données avant toute

opération. Personne n'est à l'abri d'une mauvaise manipulation ou d'une

erreur.Prérequis

Compétences

Niveau de difficulté : Difficile.

Vous devez être à l'aise au niveau de l'utilisation de la ligne de

commande dans Windows, mais aussi assez à l'aise pour gérer les

partitions de votre disque. Savoir modifier le paramétrage de votre

Firmware UEFI/BIOS et aussi nécessaire. Ce tutoriel guide pas à pas pour

la majorité des opérations. Certaines n'ont pas été détaillées par souci

de simplicité et d'efficacité.Matériel

Le PC où vous voulez installer le SSD. Il faut qu'il soit en état de

marche. De plus il doit avoir un firmware UEFI. S'il n'a que un BIOS

standard, sans UEFI, ce tutoriel n'est pas adapté.Clé(s) USB ou plusieurs CD/DVD sur lequel vous aurez mis

Clonezilla, System rescue

CD et un environnement de démarrage

Windows PE, ou Windows RE, ou le DVD/Disque d'installation de Windows.Le disque SSD (testé avec Samsung SSD 860 EVO 250GB). Il doit avoir une

taille suffisante pour contenir votre partition de Windows. Dans tous

les cas, la taille de la partition qui contiendra Windows sur le SSD

doit être au moins égale à la taille de la partition Windows du HDD que

vous voulez cloner. Au besoin, pour remplir ce critère, réduisez la

taille de votre partition Windows avec le gestionnaire de disque de

Windows par exemple (ou un autre outil de gestion de partition, comme

gparted, sur le System Rescue CD). Cherchez sur internet si vous ne

savez pas comment faire.Logiciel

Windows 10 installé (en version 64 bits) (testé avec Win10 v1709)

Windows 10 PE ou support d'installation de Windows 10 (clé USB ou DVD) -

En Version 64 bits (testé avec un support d'installation de Win10 v1804)System rescue CD (version 5.2.2 par

exemple)Clonezilla installé sur une clé ou un CD.

Bien vérifier avant que votre système arrive à démarrer dessus. (Testé

avec Clonezilla 2.5.5-38)Nomenclature

SSD : désigne le nouveau SSD

HDD : désigne votre disque actuel, sur lequel est installé Windows

WinPE : un environnement de démarrage Windows PE, ou Windows RE, ou le

DVD/Disque d'installation de Windows. Il doit être sur un support

amovible (USB, CD ou DVD)S: La lettre de lecteur affectée à la partition Système EFI qui sera sur

le nouveau SSD (parfois appelée ESP, EFI_System_Partition ou encore

SYSTEM, ou EFI)N: Le clone de Windows, sur le SSD

O: Le Windows cloné, sur le HDD

C: La partition dans laquelle est installée Windows, lorsqu'on est dans

Windows (que ce soit le windows cloné, ou le clone)Les commandes doivent être lancées en tant qu'administrateur.

Procédure de base

Fixer et brancher le SSD dans l’ordinateur

Désactiver Windows FastStart (cf votre moteur de recherche préféré)

-

Initialiser et partitionner le disque à l'aide de Windows

- Démarrer sur le Windows installé ou WinPE

- Pour initialiser le disque, d'abord créer une table de partition,

puis partitionner le disque. Pour ce faire :

- Suivre les instructions de partitionnement UEFI/GPT selon Microsoft. Ci-dessous mon exemple, mais peut-être avez-vous besoin d'une partition "recovery" aussi, ou votre configuration nécessite quelques aménagements. Dans ce cas, voir les instructions de Microsoft et adapter pour vos besoins.

- Par exemple: une partition EFI de 260Mo, une partition

Microsoft Reserved (MSR) de 16Mo, une partition pour Windows

(taille au moins égale à la taille de la partition de Windows

à cloner). Pour informations, dans diskpart, les tailles que

vous donnez en MB/Mo sont en réalité des MiB/Mio (220 =

10242 octets).

- Ouvrir une invite de commande en mode administrateur et

lancer

diskpart

. Et une fois dans diskpart :

- list disk pour lister les disques et connaître le n° du SSD.

- select disk # avec le numéro du SSD à la place de #

- clean Supprime le contenu du disque / l'initialise

- convert gpt Définit que le disque aura une table de partition GPT

- create partition efi size=260 Crée une partition EFI de 260MiB

- format quick fs=fat32 label="System" Formater la partition EFI au format FAT32

- assign letter="S" Lui donner la lettre S

- create partition msr size=16 Créer une partition Microsoft Reserved de 16MiB

- create partition primary

Créer la partition pour Windows (l'équivalent du

C:) - format quick fs=ntfs label="Windows" Formater la partition pour Windows au format NTFS

- assign letter="N" Lui donner la lettre N

- list volume Liste les volumes. Permet de voir la table de partition.

- exit Quitte diskpart

- Ouvrir une invite de commande en mode administrateur et

lancer

diskpart

. Et une fois dans diskpart :

-

Cloner le Windows installé sur le HDD. Ceci sera fait à l'aide de

Clonezilla- Redémarrer dans Clonezilla

- Une fois dans clonezilla, et si vous êtes confortable avec les

lignes de commande Linux, éventuellement supprimer de la partition

Windows du HDD les fichiers

pagefile.sys,hyberfil.sys(désactiver windows faststart avant),swapfile.sys. - Cloner la partition Windows du HDD vers le SSD (de préférence,

partition de même taille, et de toutes façons, la partition de

destination doit être plus grande que la source. Si ce n'est pas

le cas, réduisez d'abord la taille de votre partition Windows

depuis Windows). Dans clonezilla, utiliser le mode Partition vers

Partition, et en mode Export. Utiliser les options

-e1 auto(automatically adjust file system geometry for a ntfs boot partition if exists)-e2(sfdisk uses CHS of hard drive from EDD (for non grub loader)-r(resize filesystem to fit partition size of target)-m(do NOT clone boot loader)-v(verbose) - Optionnellement cacher la partition contenant le windows source de la table de partition du disque source (si vous ne savez pas à quoi ça sert, passez votre chemin). Pour cela modifier le type de partition de la partition NTFS de windows (en principe, NTFS a un id de « 7 ». On peut utiliser id 17 pour la partition cachée : 17 correspond à « IFS Hidden »). Utiliser cfdisk ou fdisk pour faire ce changement (ce sont des programmes linux).

Dans le Firmware UEFI (ou BIOS-UEFI), on peut en profiter pour passer

du mode SATA "IDE" vers "AHCI". Windows n'aime pas ce changement et

il faut donc faire une opération dans le registre qui est

détaillée ci-dessous. Tant que vous ne le faites pas, vous aurez un

écran de plantage bleu de windows au démarrage (BSOD).Si vous voulez être sûr de ne pas faire de bêtise dans le Windows que

vous venez de cloner, je vous conseille d'éteindre l’ordinateur & de

débrancher l’ancien disque. Ainsi vous ne risquez pas de modifier le

mauvais fichier de registre (en l'occurrence celui de votre Windows

sur le HDD)-

Effectuer quelques opérations sur le Windows de destination (celui

sur le SSD) avant qu'on ne démarre dessus. En particulier corriger le

registre pour affecter la lettre de lecteur C: à la bonne partition,

et si le paramétrage du Firmware UEFI (BIOS-UEFI) a été modifié pour

passer de SATA Mode PCI vers AHCI, on va aussi faire ce changement

pour que ca fonctionne.- Redémarrer dans WinPE (en Mode UEFI, pas MBR !)

- Tout d'abord déterminer la lettre de lecteur affectée au clone

de Windows, celui qui est sur le SSD. Ou, s'il n'y a pas de

lettre affectée, lui en donner une, par exemple

N:(lettre utilisée dans les exemples qui suivent)- Pour cela, lancer dans

diskpart

- list volume

Ce qui retourne la liste des volumes avec la lettre de lecteur qui a été affectée à chacun.

- list volume

- Si aucune lettre de lecteur n'est affectée, il faut alors

lui en affecter une. Pour cela, lancer dans

diskpart

- select volume # (avec # étant le numéro du volume qui contient le nouveau windows)

- assign letter=N

S'il n'est pas possible d'utiliser select volume alors faire comme ceci - list disk

- select disk # (# étant le numéro affecté au SSD)

- list partition

- select partition # (# étant le numéro affecté à la partition de Windows sur le SSD, probablement 3)

- assign letter=N

- Pour cela, lancer dans

diskpart

- Faire un CHKDSK /F sur la lettre du nouveau Win

- Pour que la partition

C:utilisée par Windows soit celle du SSD et pas celle de l’ancien disque, modifier une clé de registre du nouveau Windows :- Lancer

REGEDIT

et dans le registre HKEY_LOCAL_MACHINE monter la ruche

N:\Windows\System32\Config\SYSTEM. Lui donner le nom "NewWin" On s’intéresse àHKEY_LOCAL_MACHINE\NewWin\MountedDevices. Ce sont là les valeurs qui sont dans le registre "HKEY_LOCAL_MACHINE\SYSTEM\MountedDevices" lorsqu'on est dans l'installation de Windows.- Dans

HKEY_LOCAL_MACHINE\NewWin\MountedDevicesmodifier la lettre de lecteur C: en renommant \DosDevices\C: par \DosDevices\O: (car la valeur fait référence à la partition de l'ancien Windows sur le HDD et on ne veut pas, en démarrant, utiliser cette partition mais celle de son clone qui est sur le SSD). Ainsi, lorsqu'on démarrera dans le nouveau Windows, la partition contenant le Windows sur le HDD aura la lettre O:, et la partition contenant le Windows sur le SSD aura la lettre C: - Créer une nouvelle valeur binaire nommée \DosDevices\C:

et lui donner comme contenu celui de \DosDevices\N: qui

est renseignée dans le registre WinPE, c'est-à-dire là

HKEY_LOCAL_MACHINE\SYSTEM\MountedDevices(C:étant la lettre qu'utilisait le Windows du HDD comme partition où il y a le dossier \Windows ) - ATTENTION: Bien vérifier que la copie a fonctionné et qu'il y a les bonnes valeurs, car dans mes essais, j'ai du m'y reprendre à 2 fois car le 1er "coller" ne collait pas ce que je voulais.

- En principe c'est tout. Mais d'après certaines sources,

il y aurait une clé \\?\Volume{GUID} ayant le même

contenu que le \DosDevices\O: qu’on vient de modifier.

Chez moi ce n'était pas le cas. Si vous avez une telle

valeur, alors il faut lui donner le contenu de

\DosDevices\N: depuis le registre WinPE

- Dans

- Lancer

REGEDIT

et dans le registre HKEY_LOCAL_MACHINE monter la ruche

- Si en même temps que la migration on veut aussi passer du mode

SATA IDE vers AHCI alors il faut encore faire ceci. Cela a été

repris du site

tomshardware.co.uk

- Toujours dans

REGEDIT

avec la ruche montée en

HKEY_LOCAL_MACHINE\NewWin - Aller à

HKEY_LOCAL_MACHINE\NewWin\ControlSet000\Services\storahci\StartOverride - Changer la valeur DWORD de 3 à 0.

- Au redémarrage, si ça n'a pas été fait, changer la paramétrage du contrôleur SATA de IDE à AHCI. Au redémarrage, Windows devrait directement démarrer correctement et sans plantage (BSOD).

- Toujours dans

REGEDIT

avec la ruche montée en

- Rendre le disque bootable en installant les outils EFI de

microsoft et configurant le Magasin BCD (BCD Store)

- D'abord assigner une lettre de lecteur à la partition ESP

- MOUNTVOL S: /S

Si ca n'a pas fonctionné, faire comme ceci dans diskpart - list disk

- select disk # (# est le numero du SSD retourné par list disk)

- list partition

- select partition # (# est probablement 1)

- assign letter=S

- MOUNTVOL S: /S

- Puis lancer

bcdboot

N:\windows /l fr-fr /s S: /f UEFI- Où

N:\Windowsest le répertoire contenant le clone de Windows sur le SSD) - S: = partition EFI

- Où

- D'abord assigner une lettre de lecteur à la partition ESP

- Tout d'abord déterminer la lettre de lecteur affectée au clone

de Windows, celui qui est sur le SSD. Ou, s'il n'y a pas de

lettre affectée, lui en donner une, par exemple

- Redémarrer dans WinPE (en Mode UEFI, pas MBR !)

Redémarrer, et avant le lancement de Windows vérifier votre UEFI

(ou BIOS-UEFI). Il faut qu'il soit configuré pour démarrer par défaut

en mode UEFI et pas en mode BIOS. Penser aussi à corriger le

paramétrage SATA si cela a été modifié dans le registre de Windows.

Le paramétrage du démarrage avecbcdboot N:\windows /l fr-fr /s S: /f UEFIa normalement créé le

magasin BCD, mis tous les fichiers EFI sur la partition SYSTEME (ESP,

partiton EFI, la 1ère du SSD) et dit au firmware UEFI qu'il doit

automatiquement démarrer avec le gestionnaire de démarrage

(boot manager) de Windows.-

Une fois qu’on a réussi à démarrer dans la copie de Windows

- Réactiver le "FastBoot"

- Réactiver l'environnement de récupération de Windows

en lançant, depuis une ligne de commande avec les droits

administrateur, la commande

reagentc.exe /enable. Vérifier avecreagentc.exe /info. Et s'il y a une erreur essayer avecreagentc.exe /enable /setreimage /path C:\Recovery\WindowsREoùC:\Recovery\WindowsREest le dossier où se trouve le fichierWinre.wim - Vérifier que tout est en ordre. Eventuellement donner un nouveau

nom à votre partition

C:(pour la différencier de celle sur le HDD) en lançant:LABEL [drive:][label] - Redémarrer encore une fois en laissant le processus de démarrage se faire tout seul pour vérifier que tout est ok.

Réinsérer l'ancien disque dur.

Normalement, il devrait être possible de redémarrer dans l'ancien

Windows, du moment que vous savez comment booter en MBR, et sous

réserve de ne pas avoir modifié le mode SATA dans le UEFI/BIOS. SI

c'est le cas, vous pouvez envisager de modifier le registre du

Windows du HDD, ou de modifier le paramétrage du UEFI/BIOS.

Si vous avez aussi Linux d'installé sur le HDD, il devrait toujours

être possible de le démarrer en mode BIOSOn peut diminuer/augmenter la taille de la partition C: du SSD (Pour

un SSD TLC ou VNAND, on peut par exemple laisser de l’espace libre à

la fin ~10 % de la capacité du disque d'après le logiciel Samsung

Magician, pour un SSD 860 EVO)En principe, puisqu’on boot en EFI on peut enlever sur le clone

Windows sur le SSD les fichiers\bootmgret\Boot\BCDpuisque ce

sont ceux qui étaient utilisés pour un boot en mode BIOS/MBR et que

désormais on est en EFI. Vous pouvez d'abord les renommer et vérifier

que ca ne change rien au prochain boot, plutôt que de les supprimer

tout de suite.

Quelques pistes si ça ne fonctionne pas…

- Faire un chkdsk sur la nouvelle partition

- Recréer le bootsector du NTFS avec testdisk (dispo sur System Rescue CD, mais peut être aussi dans Clonezilla ? Je n'ai pas vérifié)